标题:Revealing Occlusions with 4D Neural Fields

来源:CVPR 2022 (Oral Presentation)

解读&翻译:竹石

文章&代码&视频讲座:https://occlusions.cs.columbia.edu/

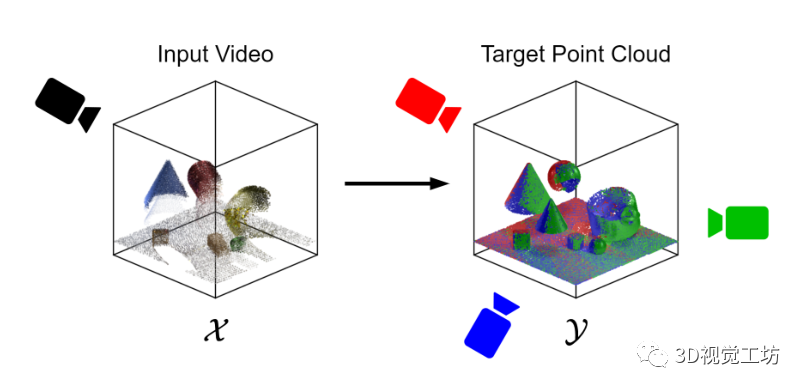

提出了从单目RGB-D(深度信息)视频输入中完成4D动态场景补全这一新的基本任务,为时空推理任务奠定了基础 提出了新的基准来评估场景完备性和杂乱环境中目标的持久性 提出了一种新的点云深度学习体系结构,它能够根据点云的上下文生成新的点

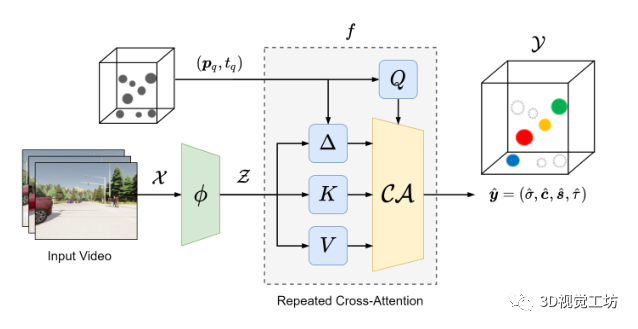

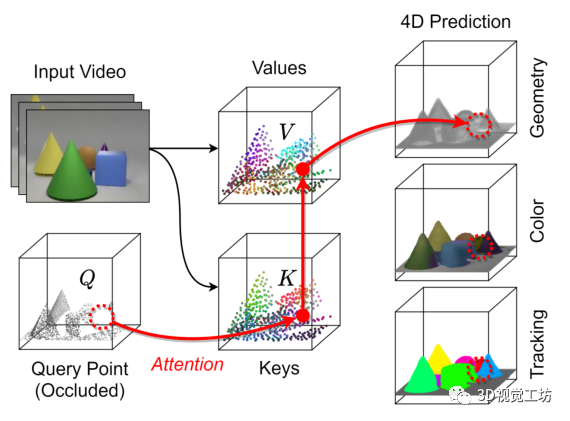

Model模型

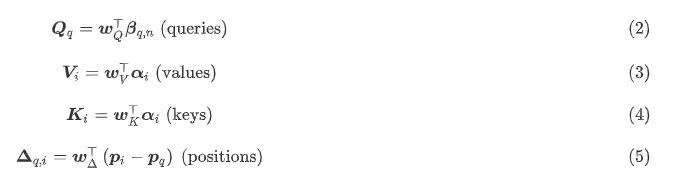

Point Attention集中注意力

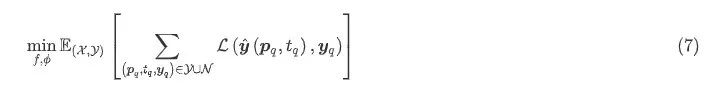

Learning and Supervision学习和监督

Tasks

Inference

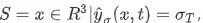

其中σ_T=0.5。在通过立方体推进算法对点云或网格进行采样后,我们通过检索与每个坐标相关的预测颜色 、语义类别或跟踪标志来对其着色。

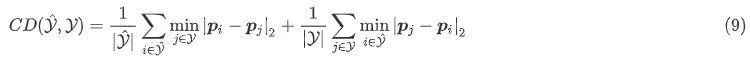

其中σ_T=0.5。在通过立方体推进算法对点云或网格进行采样后,我们通过检索与每个坐标相关的预测颜色 、语义类别或跟踪标志来对其着色。Evaluation Metrics评估指标

References

3D视觉工坊精品课程官网:3dcver.com

3.彻底搞透视觉三维重建:原理剖析、代码讲解、及优化改进

4.国内首个面向工业级实战的点云处理课程

5.激光-视觉-IMU-GPS融合SLAM算法梳理和代码讲解

6.彻底搞懂视觉-惯性SLAM:基于VINS-Fusion正式开课啦

7.彻底搞懂基于LOAM框架的3D激光SLAM: 源码剖析到算法优化

8.彻底剖析室内、室外激光SLAM关键算法原理、代码和实战(cartographer+LOAM +LIO-SAM)

重磅!3DCVer-学术论文写作投稿 交流群已成立

扫码添加小助手微信,可申请加入3D视觉工坊-学术论文写作与投稿 微信交流群,旨在交流顶会、顶刊、SCI、EI等写作与投稿事宜。

同时也可申请加入我们的细分方向交流群,目前主要有3D视觉、CV&深度学习、SLAM、三维重建、点云后处理、自动驾驶、多传感器融合、CV入门、三维测量、VR/AR、3D人脸识别、医疗影像、缺陷检测、行人重识别、目标跟踪、视觉产品落地、视觉竞赛、车牌识别、硬件选型、学术交流、求职交流、ORB-SLAM系列源码交流、深度估计等微信群。

一定要备注:研究方向+学校/公司+昵称,例如:”3D视觉 + 上海交大 + 静静“。请按照格式备注,可快速被通过且邀请进群。原创投稿也请联系。

▲长按加微信群或投稿

▲长按关注公众号

▲长按关注公众号

3D视觉从入门到精通知识星球:针对3D视觉领域的视频课程(三维重建系列、三维点云系列、结构光系列、手眼标定、相机标定、激光/视觉SLAM、自动驾驶等)、知识点汇总、入门进阶学习路线、最新paper分享、疑问解答五个方面进行深耕,更有各类大厂的算法工程人员进行技术指导。与此同时,星球将联合知名企业发布3D视觉相关算法开发岗位以及项目对接信息,打造成集技术与就业为一体的铁杆粉丝聚集区,近4000星球成员为创造更好的AI世界共同进步,知识星球入口:

学习3D视觉核心技术,扫描查看介绍,3天内无条件退款

圈里有高质量教程资料、答疑解惑、助你高效解决问题 觉得有用,麻烦给个赞和在看~