你好,我是郭震

这篇文章是关于搭建本地个人知识库,零代码!喂饭级教程!支持GPT、Llama3、Kimi等十几种大模型。

教程由我编写,每一步已经过验证,可实践!

1 搭建本地知识库优势

部署本地知识库,可以借助大模型能力,自动检索我们的工作学习文档,实现对文档内容的实时搜索与问答。 因为大模型、知识库和文档全部运行在本地,所以公司内的业务数据不会泄密,个人隐私不会泄密,保证这些同时,让:办公效率直接原地起飞! 搭建完成后,实现的效果如下:

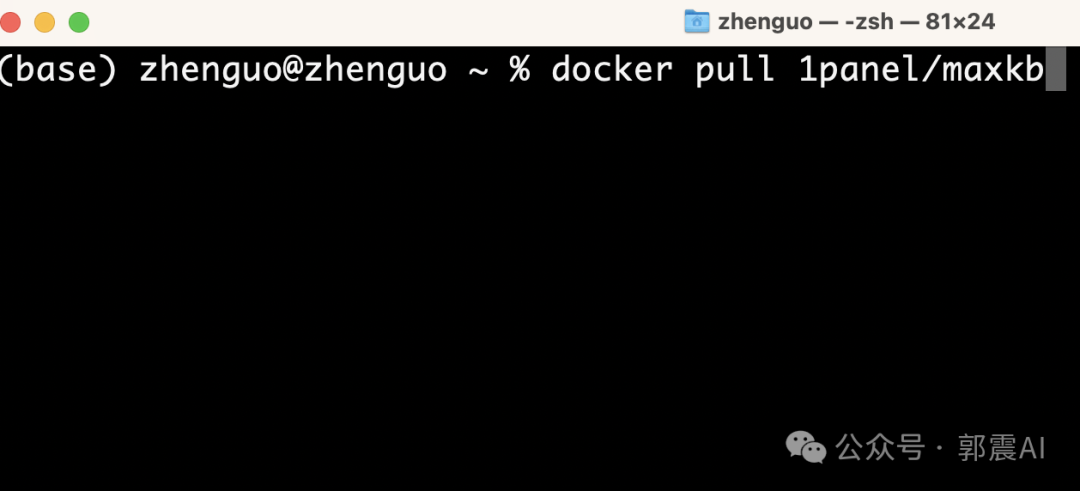

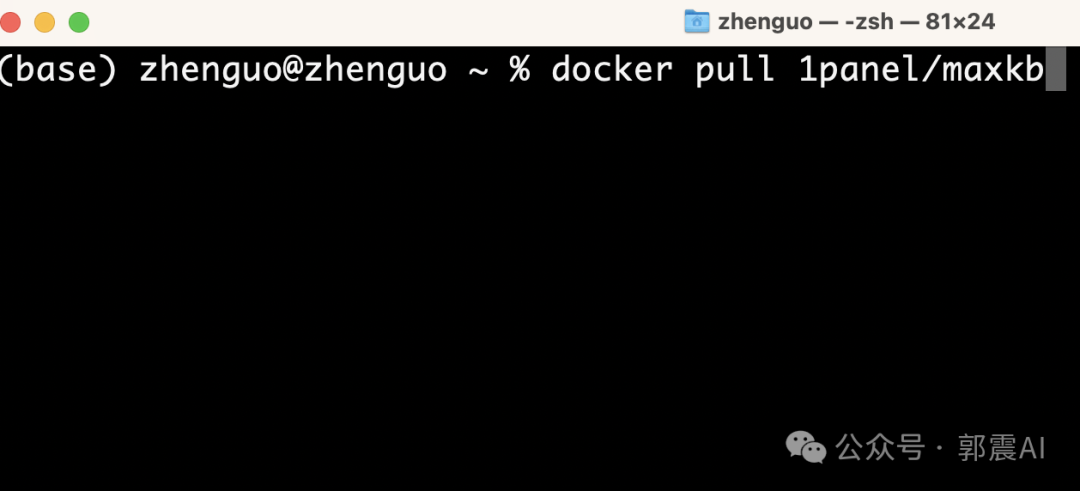

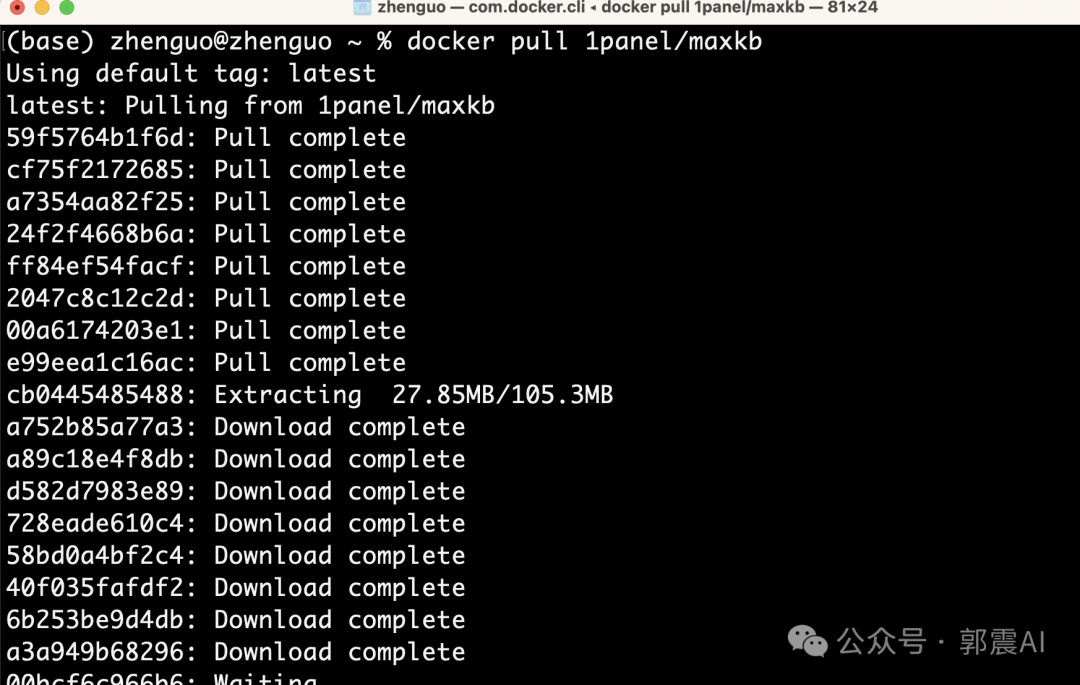

安装后docker后,执行下面命令获取到MaxKB的镜像到本地: 下面是正在安装的过程:

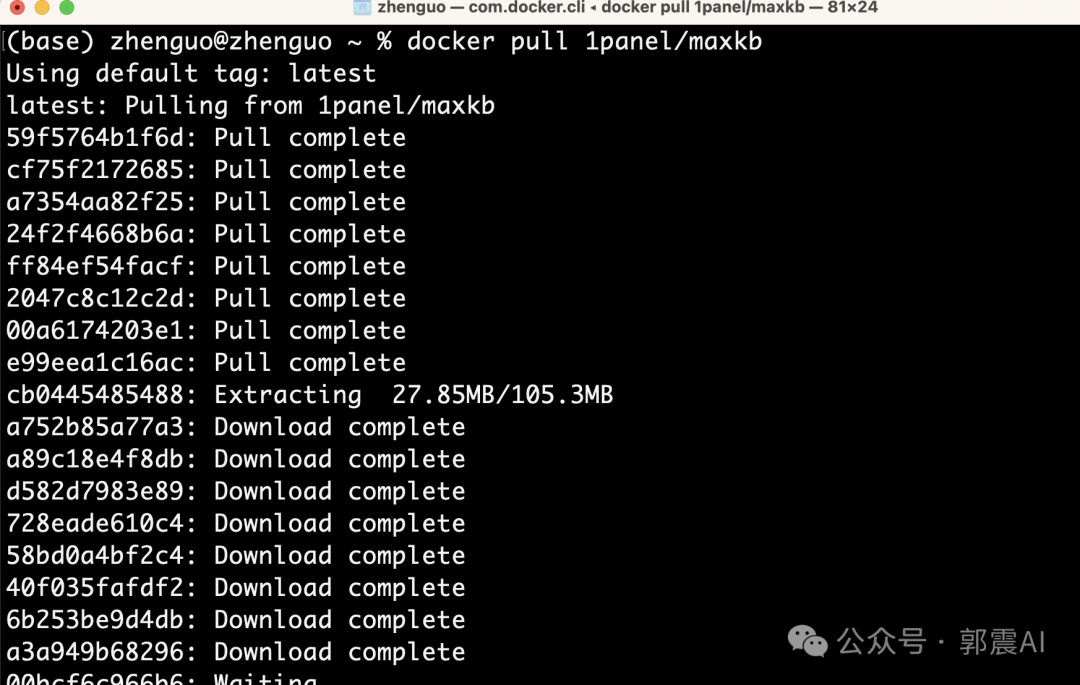

下面是正在安装的过程:

整个MaxKb的镜像大小为2GB左右。

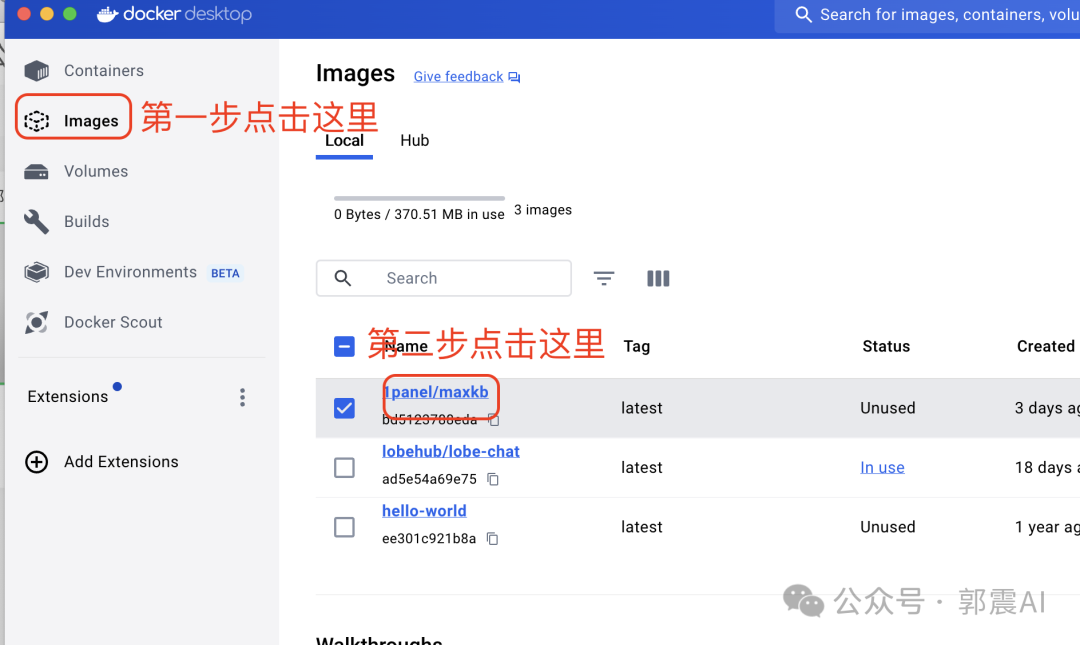

3 docker配置MaxKB

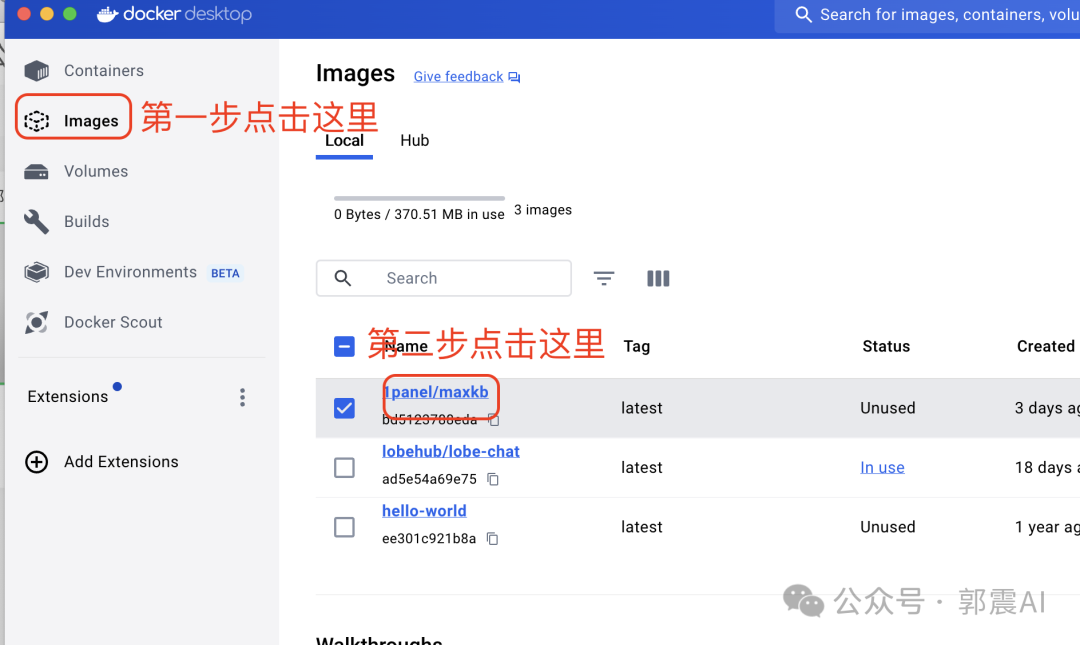

安装完成后,打开docker,按照下图逐步操作:

整个MaxKb的镜像大小为2GB左右。

3 docker配置MaxKB

安装完成后,打开docker,按照下图逐步操作:

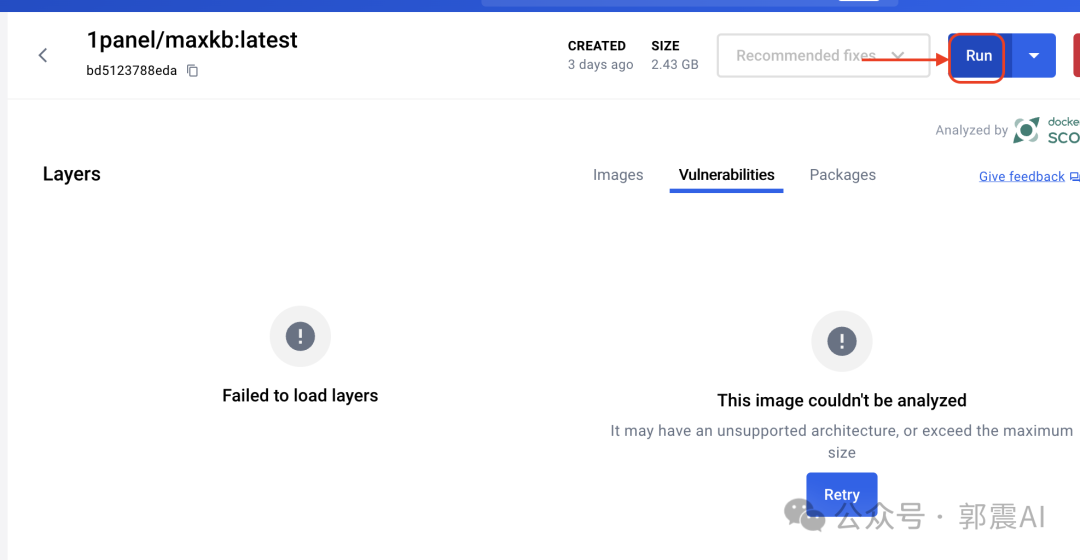

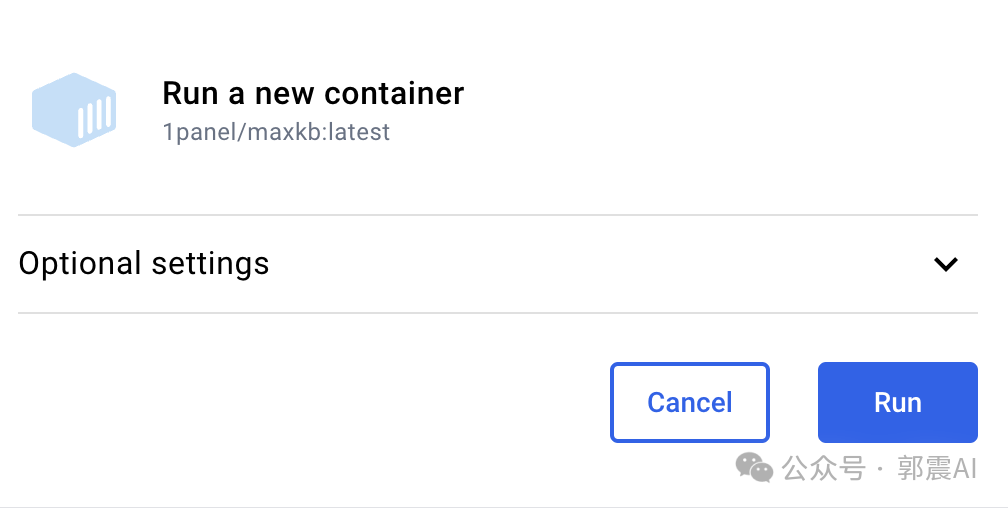

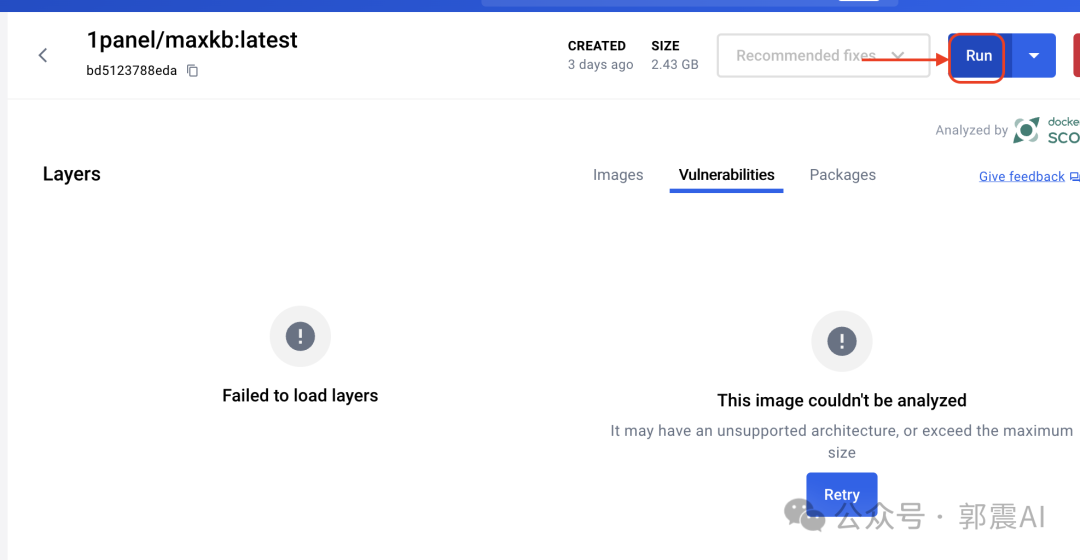

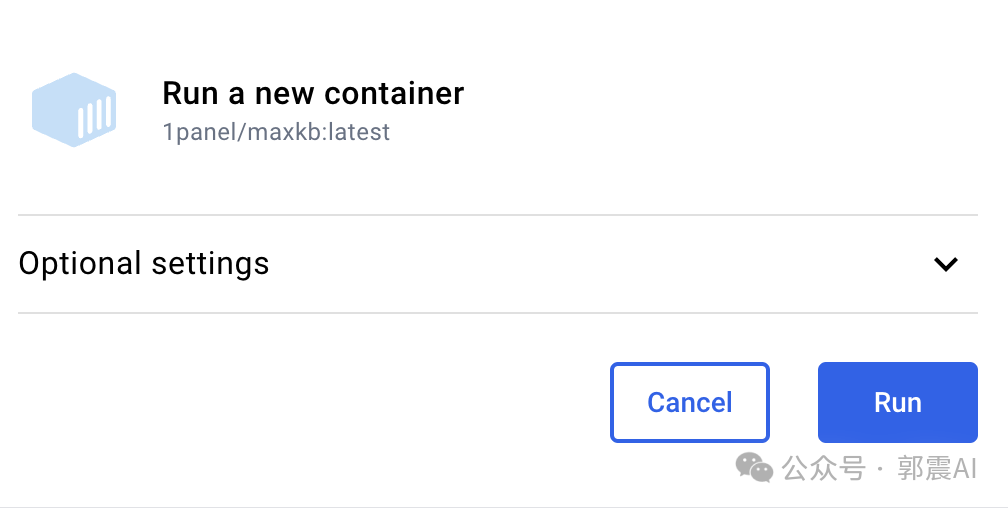

在弹出的界面,点击 Run:

在弹出的界面,点击 Run:

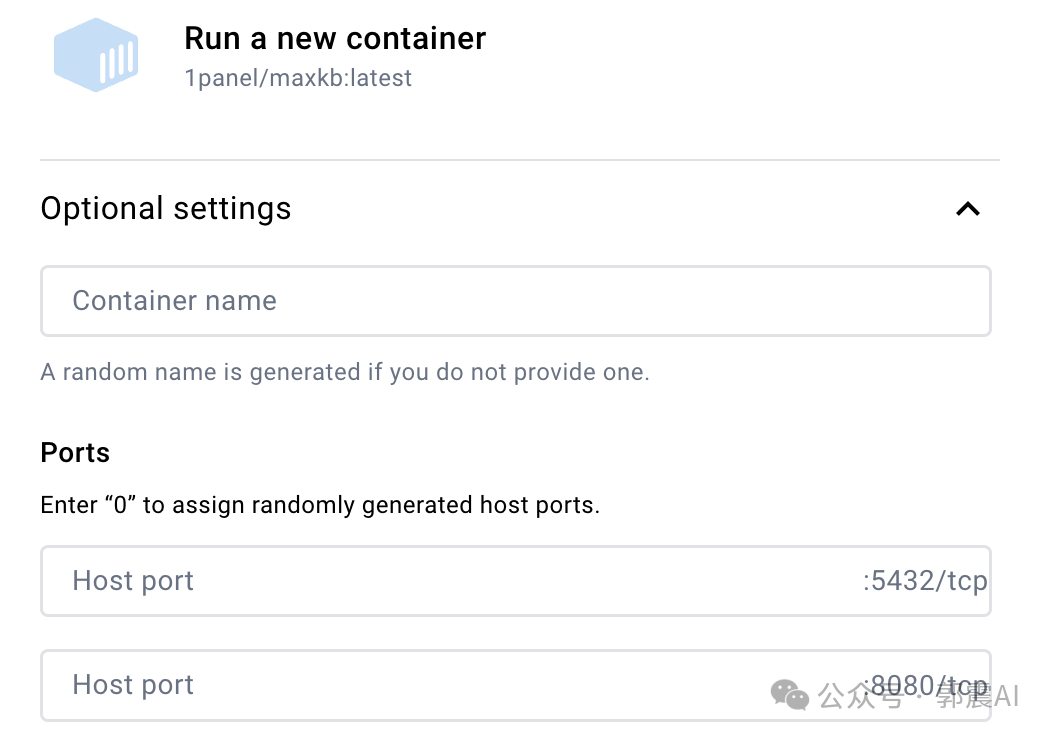

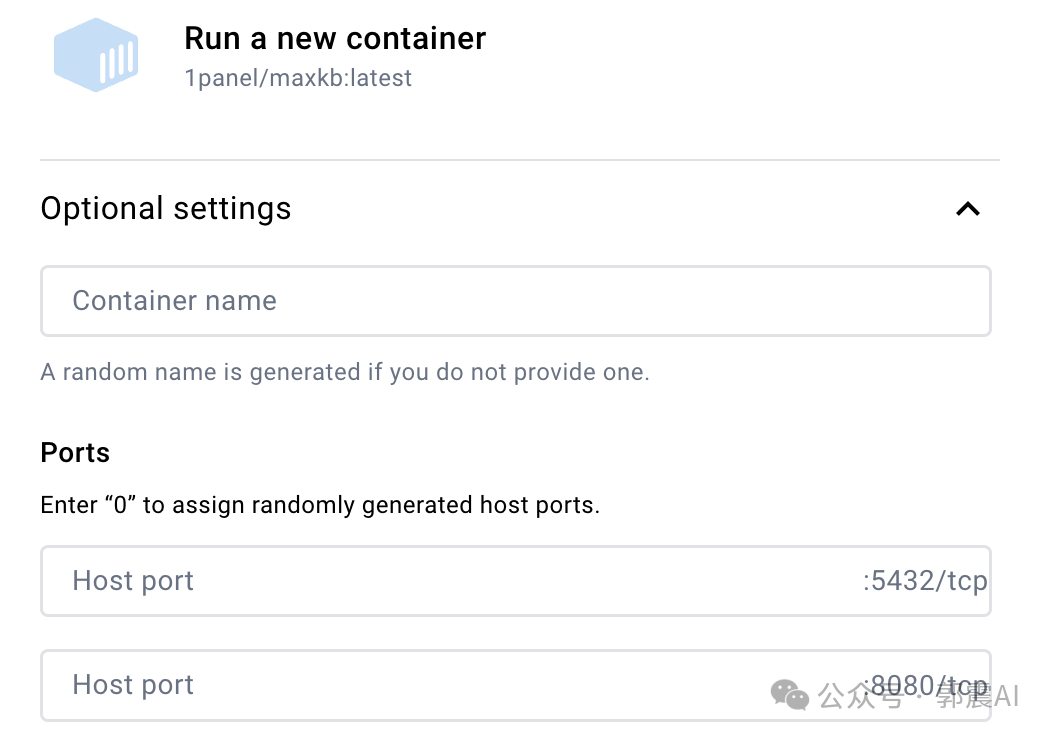

这是弹出的界面,如果你的缺少Ports这样端口设置,可以重启电脑,然后再次打开进入这里,大概率应该会出现。

这是弹出的界面,如果你的缺少Ports这样端口设置,可以重启电脑,然后再次打开进入这里,大概率应该会出现。

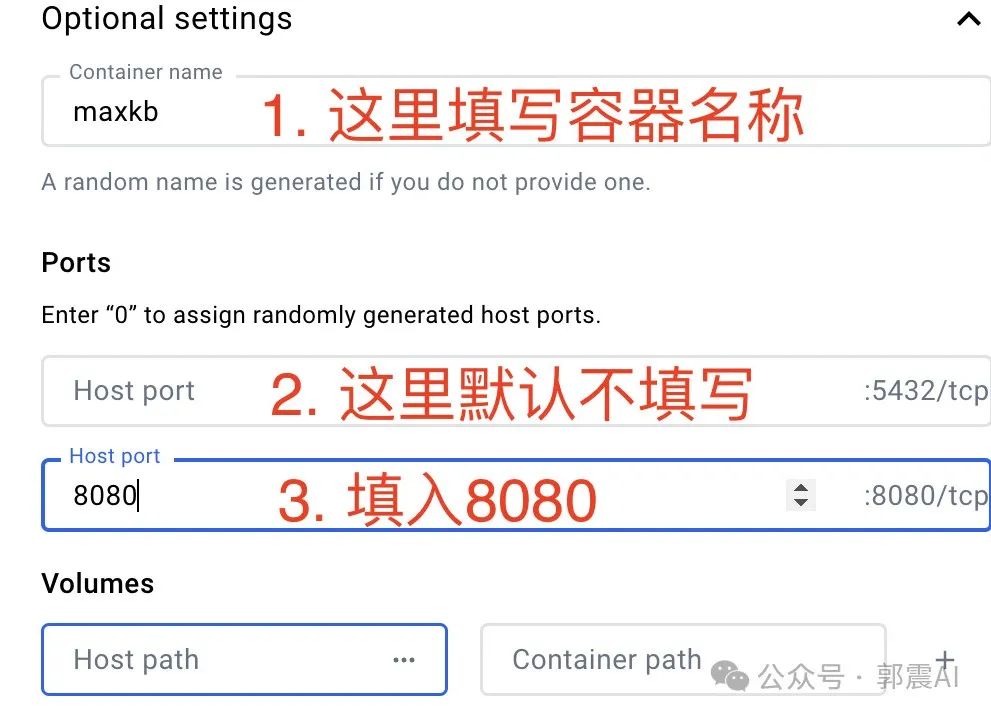

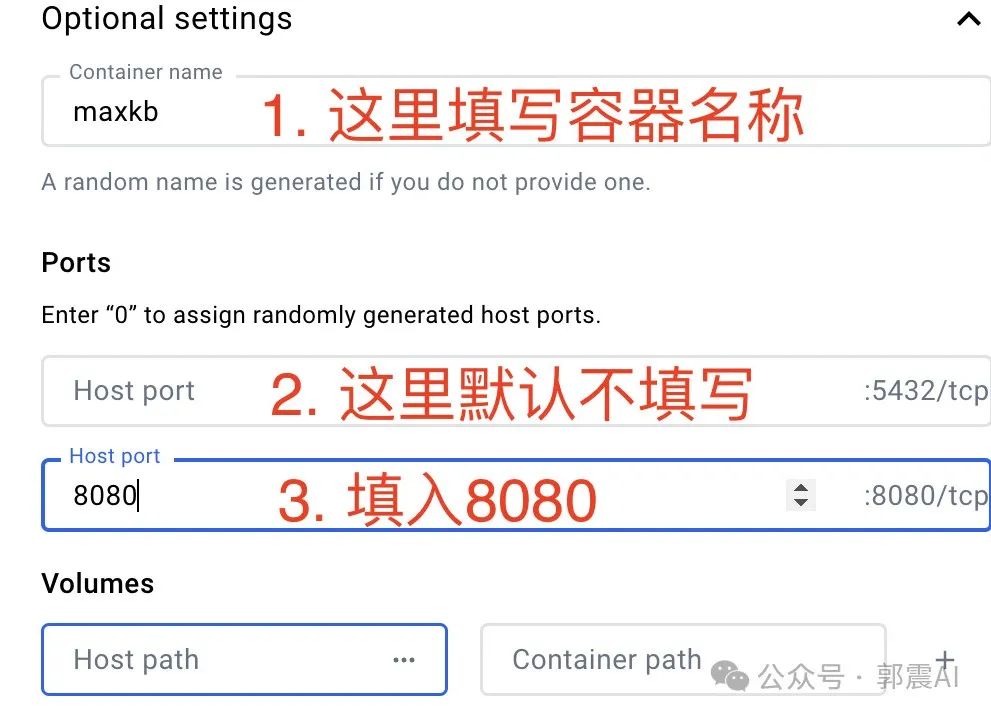

然后按照下面填写:

然后按照下面填写:

注意,先不要关闭这个窗口,稍后我们还需要再填入一些信息。

注意,先不要关闭这个窗口,稍后我们还需要再填入一些信息。

接下来,我们在自己的电脑上,创建一个存放知识库数据的文件夹,然后记住这个文件夹路径,因为我们还要返回到刚才的上面的界面,找到Volumes输入框,下图4处,填入刚才的知识库路径,我的路径如下: /Users/zhenguo/Documents/words 随后在Container path输入框中填入/var/lib/postgresql/data,下图5处,这是固定不变的,直接复制过去! 最后点击Run按钮,这样一个MaxKB容器就搭建完毕了!

4 打开MaxKB网页

浏览器打开下面链接,复制到浏览器中,看到MaxKB应用界面:

http://127.0.0.1:8080

最后点击Run按钮,这样一个MaxKB容器就搭建完毕了!

4 打开MaxKB网页

浏览器打开下面链接,复制到浏览器中,看到MaxKB应用界面:

http://127.0.0.1:8080

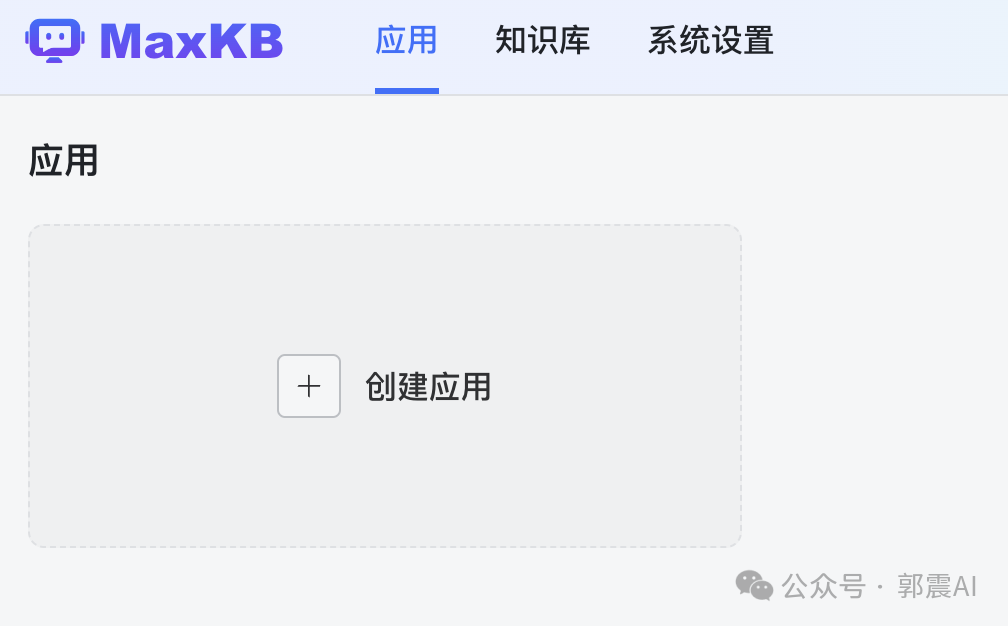

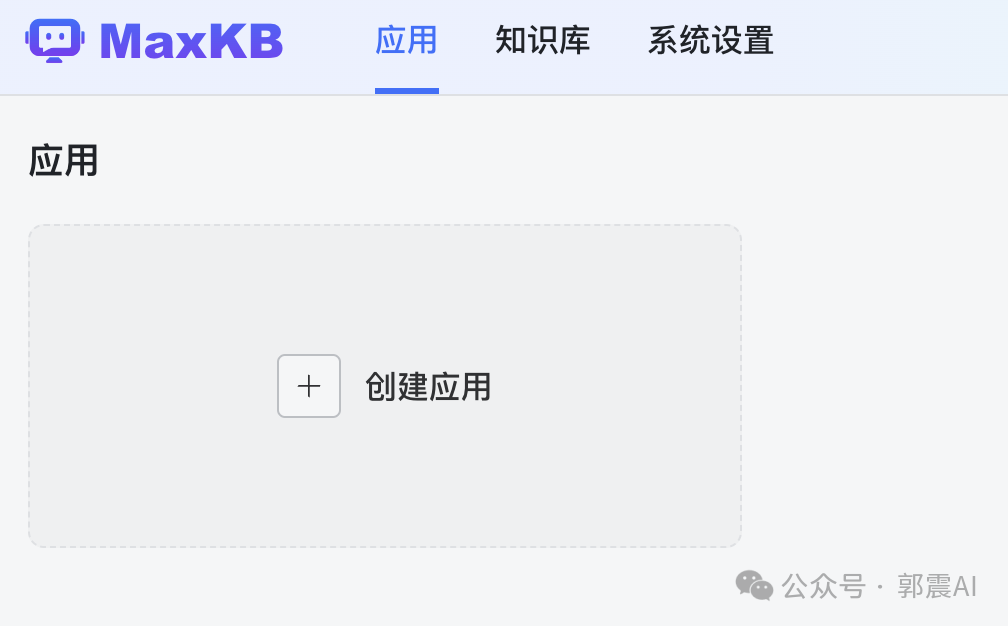

不过这里需要提供登录账号和密码, 大家关注我下面的公众号,并回复关键词 kb 获取: 登录进去后,初次登录到MaxKB后,需更改登录用户名和登录密码。看到创建应用程序的界面: 5 构建第一个知识库

我们先尝鲜它的知识库搭建,所以选择知识库导航这里:

5 构建第一个知识库

我们先尝鲜它的知识库搭建,所以选择知识库导航这里:

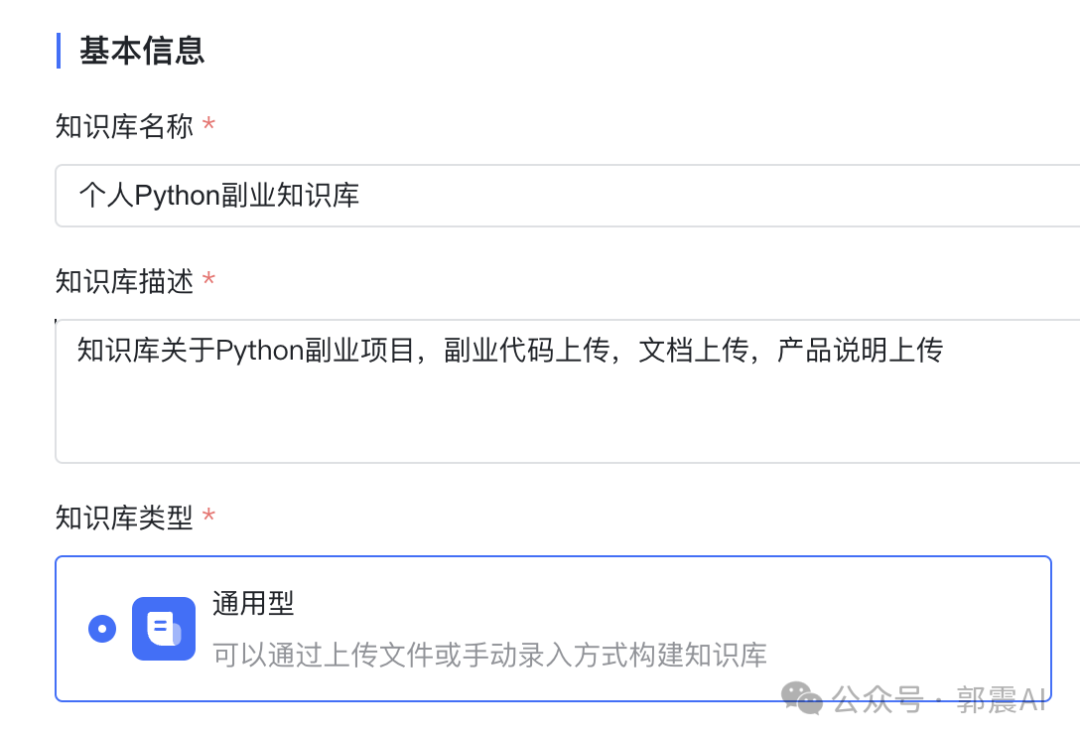

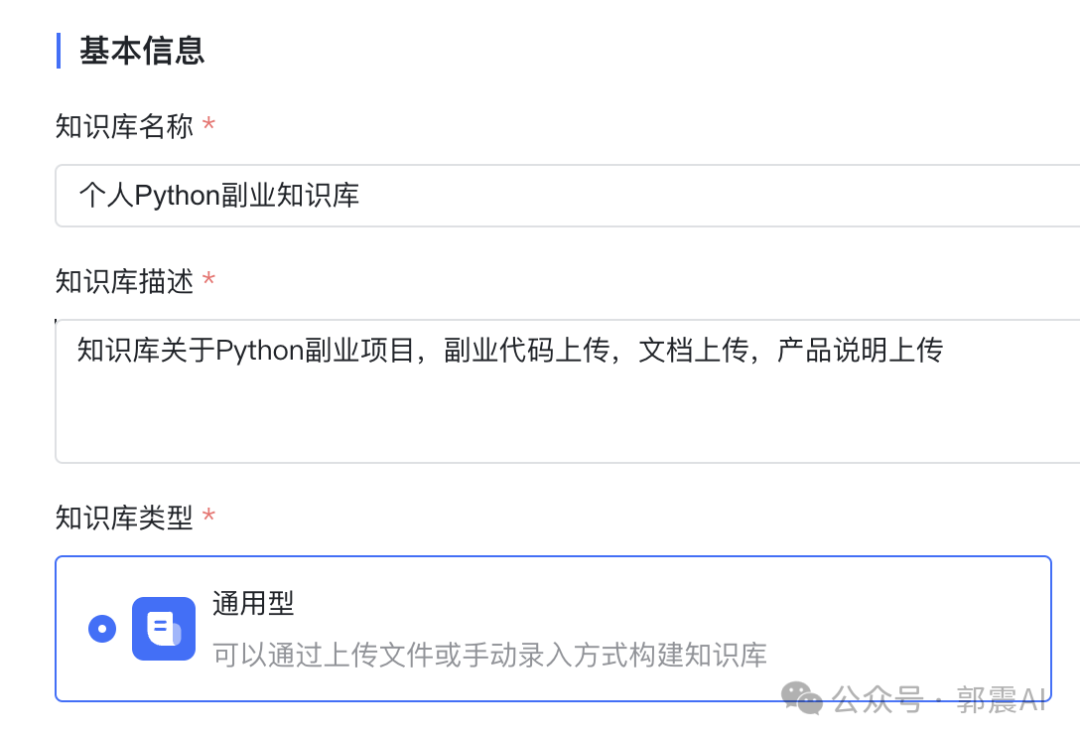

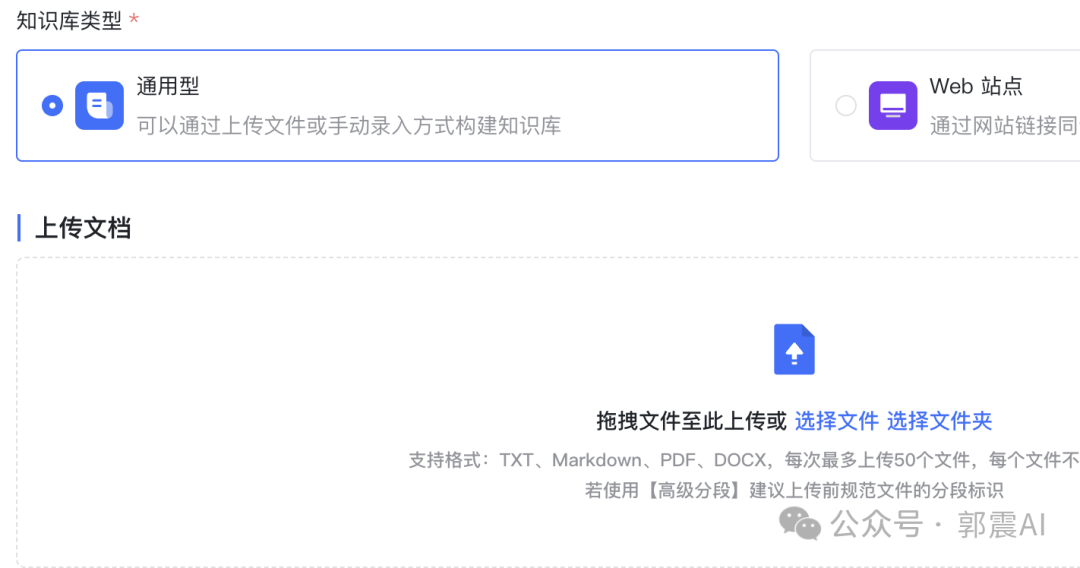

然后点击创建知识库按钮,就会出来下面页面:

然后点击创建知识库按钮,就会出来下面页面:

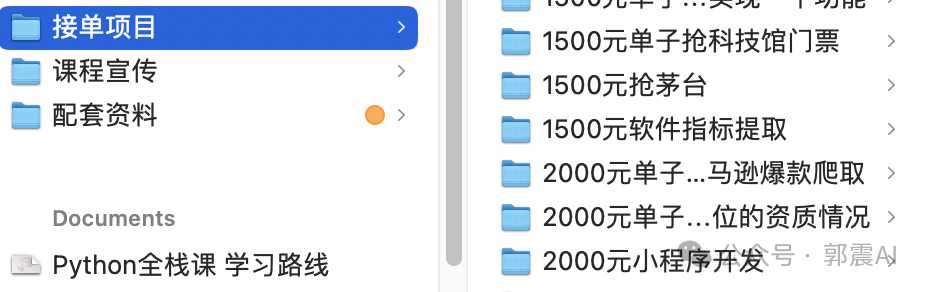

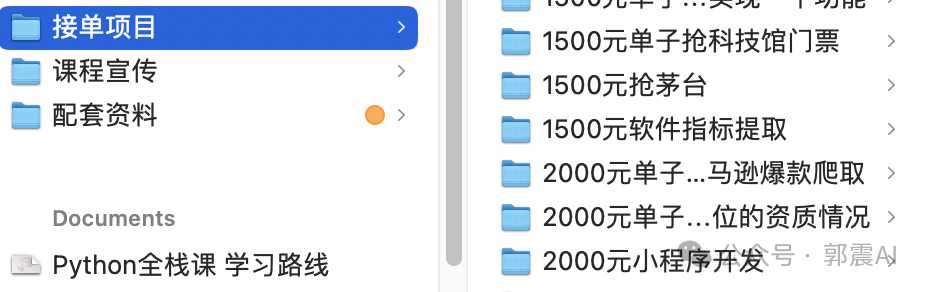

平时做过一些Python副业接单,把做过的其中一部分副业需求文档、传入到这个知识库里面,因为都是在本地构建,放心使用:

平时做过一些Python副业接单,把做过的其中一部分副业需求文档、传入到这个知识库里面,因为都是在本地构建,放心使用:

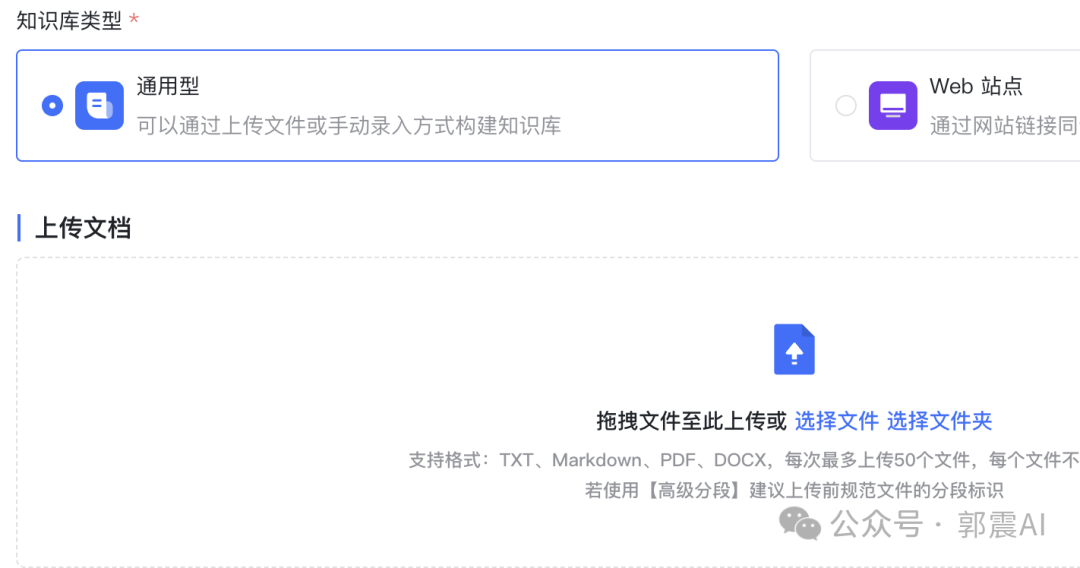

这里的知识库系统有两种,一种是通用型,也就是自己的文档本地上传,另一种是web站点,用某些网站作为知识库构建的数据来源。在这里根据我的需求,应该选择通用型。

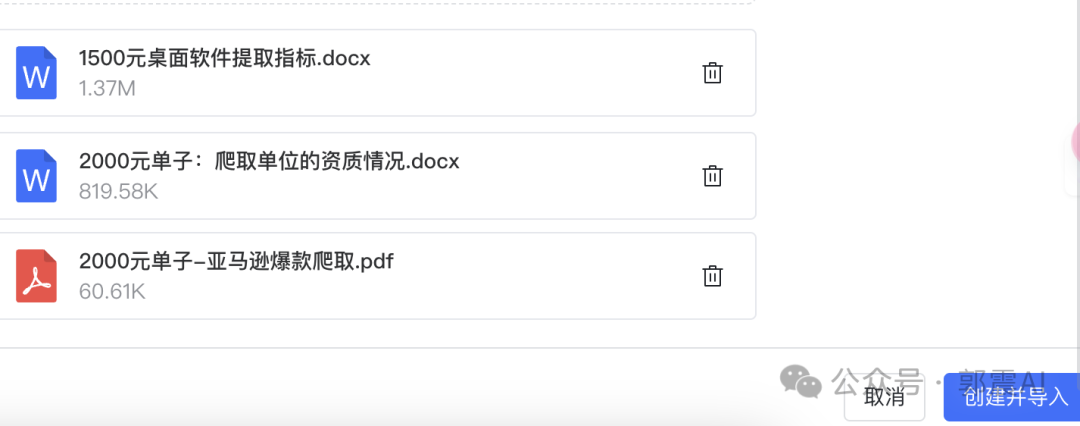

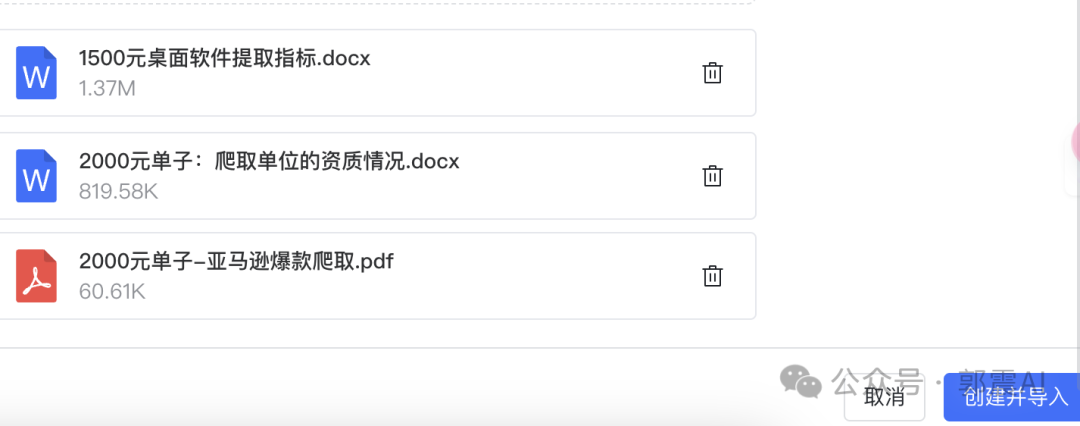

然后点击进入选择文件夹这里,上传我的Python副业代码文件,说明文档,数据格式可以是txt、word、pdf、ppt等,在确定需要上传的文档后,点击右下角的“创建并导入”按钮。

这里的知识库系统有两种,一种是通用型,也就是自己的文档本地上传,另一种是web站点,用某些网站作为知识库构建的数据来源。在这里根据我的需求,应该选择通用型。

然后点击进入选择文件夹这里,上传我的Python副业代码文件,说明文档,数据格式可以是txt、word、pdf、ppt等,在确定需要上传的文档后,点击右下角的“创建并导入”按钮。

如下图所示,上传这里面的文件到本地MaxKB系统,还可以直接读取一个文件夹,这样就更方便了。为了加快接入,选择一部分文件作为测试:

如下图所示,上传这里面的文件到本地MaxKB系统,还可以直接读取一个文件夹,这样就更方便了。为了加快接入,选择一部分文件作为测试:

然后点击右下角 创建并导入

然后点击右下角 创建并导入

导入后,系统就会开始处理分析和接入,文档导入时间长短取决于文档内容的多少,内容越多,导入时间就越长。

导入后,系统就会开始处理分析和接入,文档导入时间长短取决于文档内容的多少,内容越多,导入时间就越长。

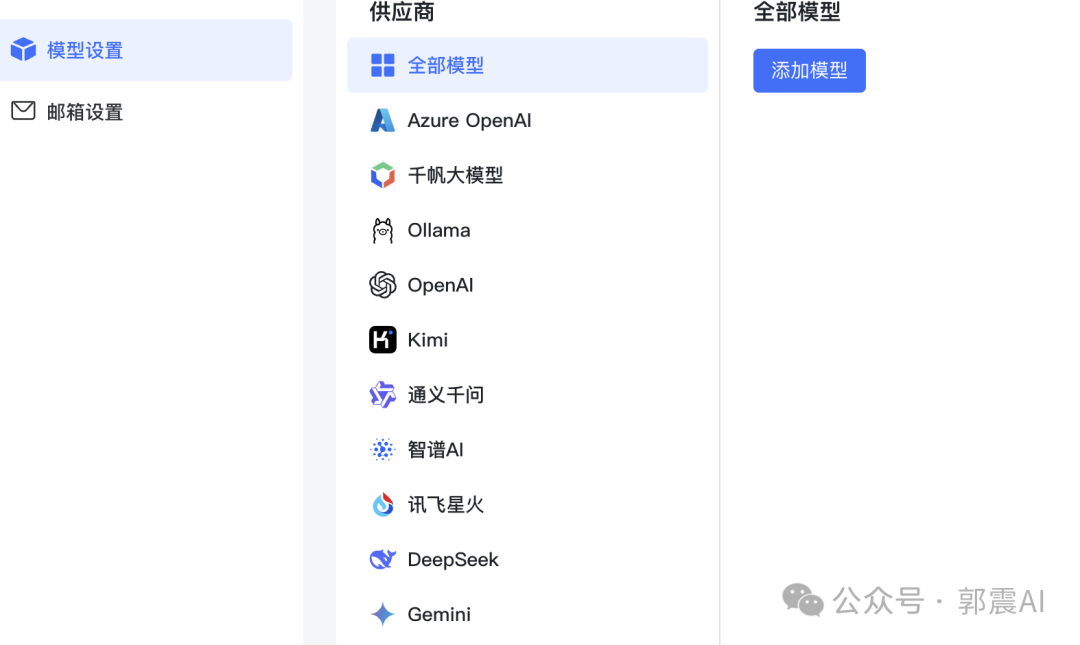

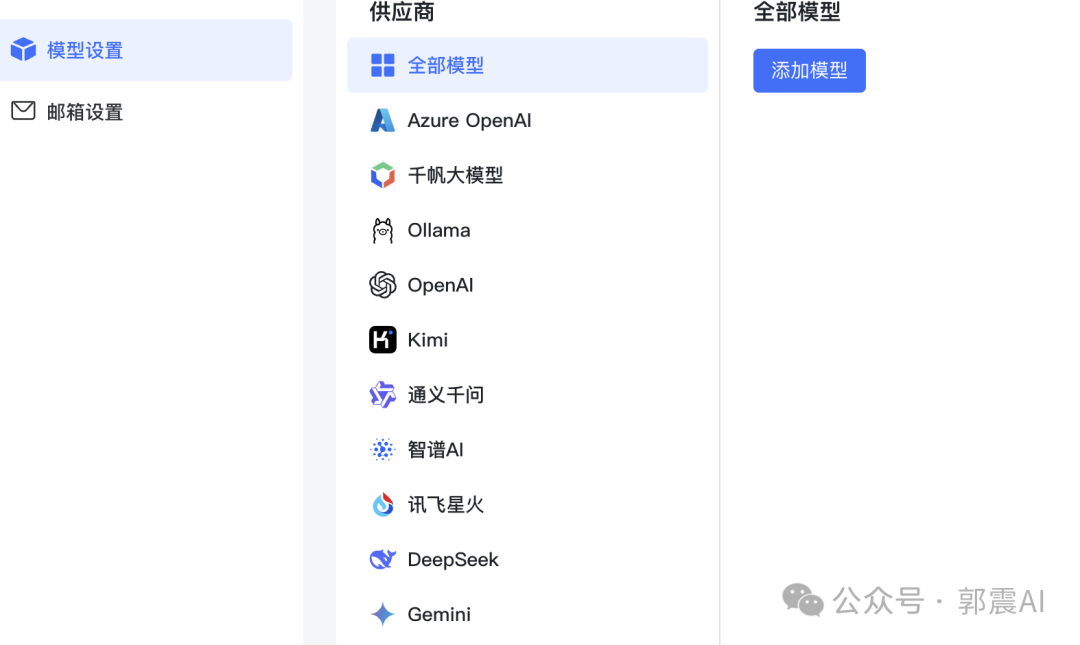

6 配置本地llama3

MaxKB网站内的应用界面中,按照如下所示点击系统设置,然后再进入模型设置界面

6 配置本地llama3

MaxKB网站内的应用界面中,按照如下所示点击系统设置,然后再进入模型设置界面

可以看到这里支持的大模型比较多:

可以看到这里支持的大模型比较多:

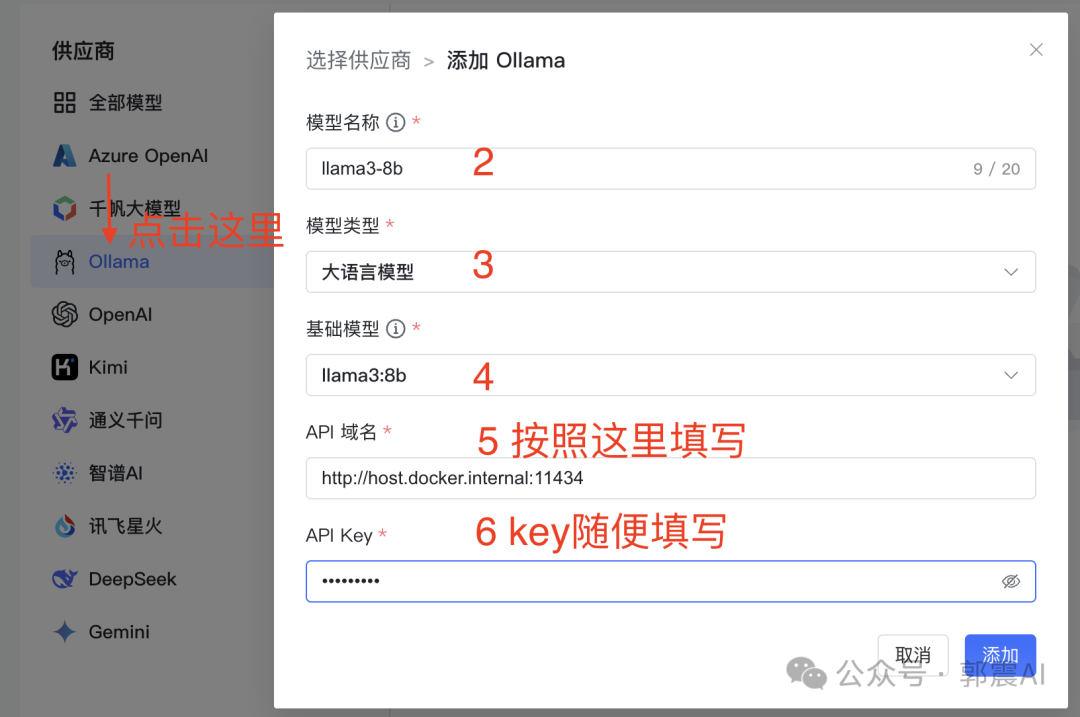

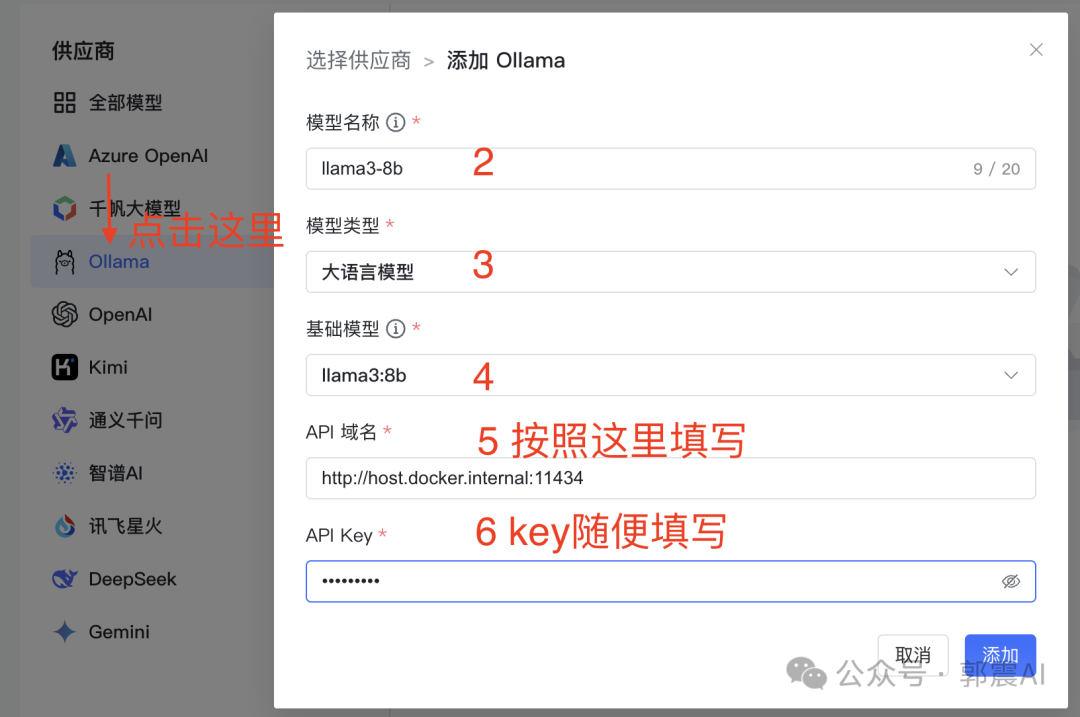

我以ollama+llama3配置为例,之前我已经总结过配置这些的详细教程,关注我的公众号,然后发消息:AI,直接获取PDF教程。在这里不再赘述。安

装完ollama和llama3后,

开始

下面一步,非常重要,按照我的这个说明,对应填写

,然后点击添加:

我以ollama+llama3配置为例,之前我已经总结过配置这些的详细教程,关注我的公众号,然后发消息:AI,直接获取PDF教程。在这里不再赘述。安

装完ollama和llama3后,

开始

下面一步,非常重要,按照我的这个说明,对应填写

,然后点击添加:

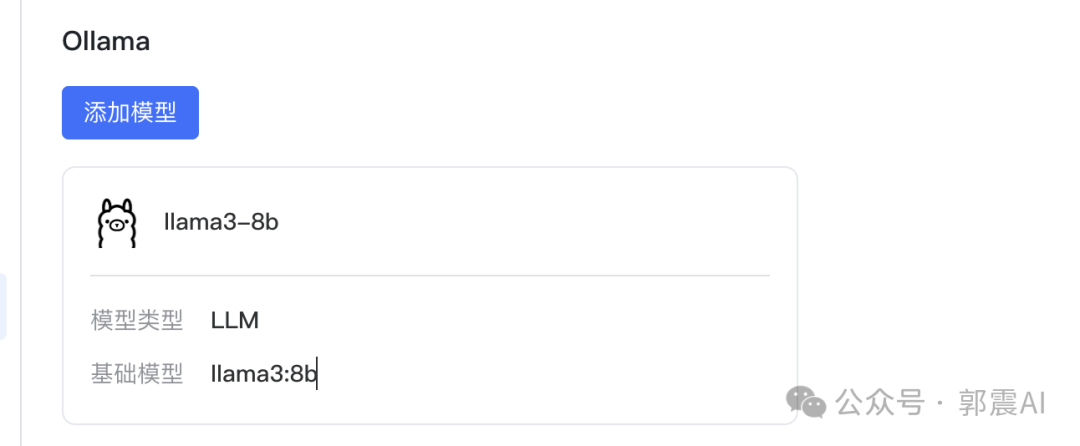

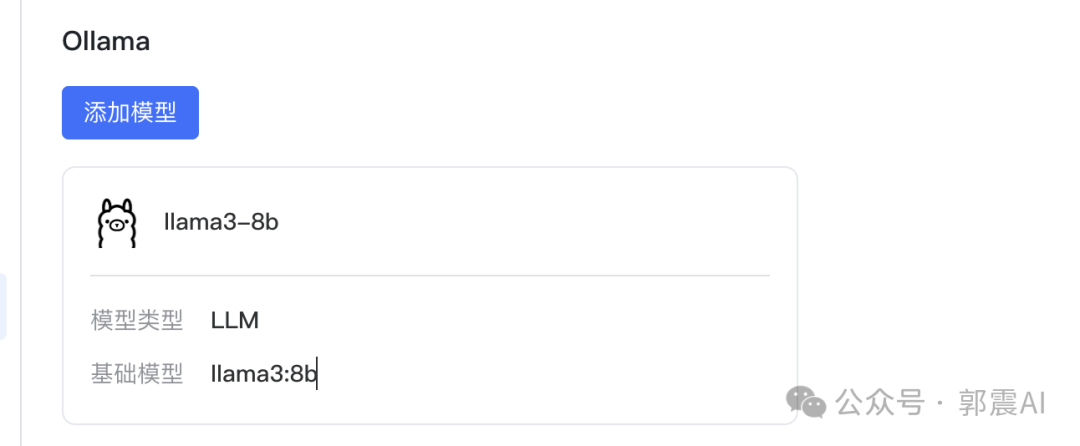

添加成功后,会显示下面界面:

添加成功后,会显示下面界面:

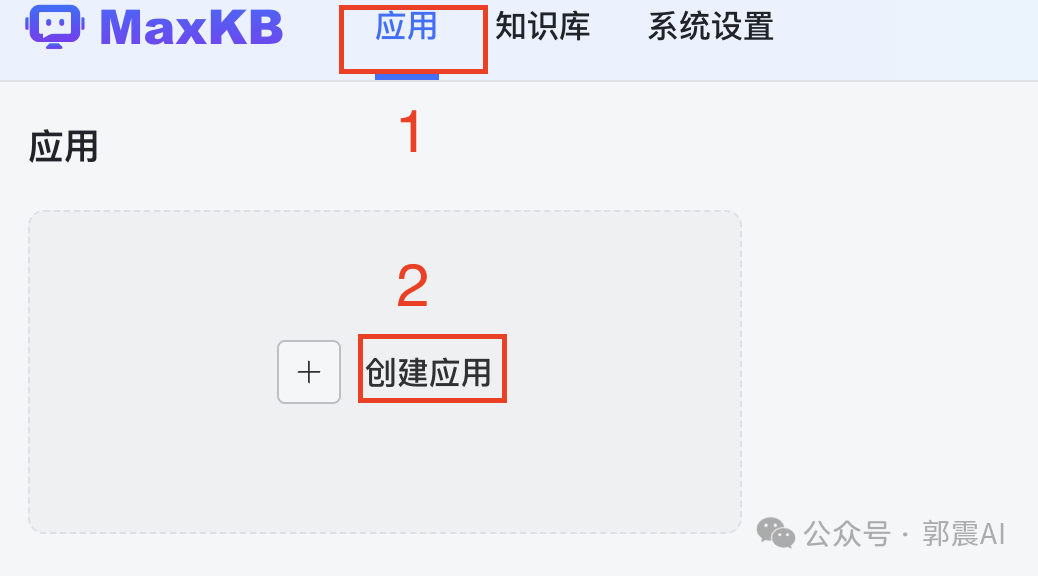

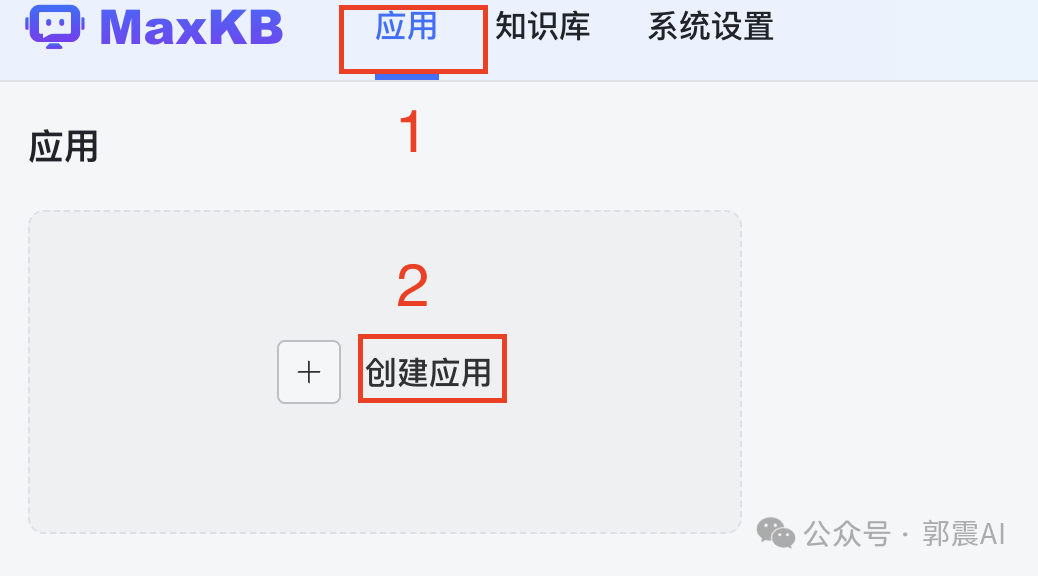

7 创建知识库应用

这是最后一步了,回到MaxKB界面:

7 创建知识库应用

这是最后一步了,回到MaxKB界面:

点击

应用

,然后

创建应用

,

填写

应用名称

、

应用描述

,

AI模型

这里,选择我们刚才创建的MaxKB里的llama3模型,如下所示,按照这样填写:

点击

应用

,然后

创建应用

,

填写

应用名称

、

应用描述

,

AI模型

这里,选择我们刚才创建的MaxKB里的llama3模型,如下所示,按照这样填写:

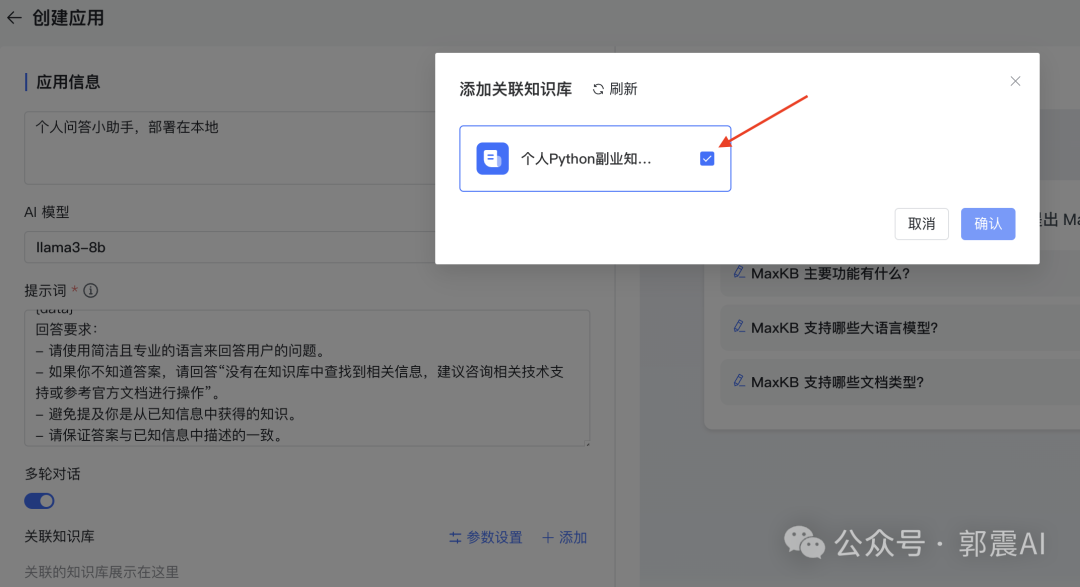

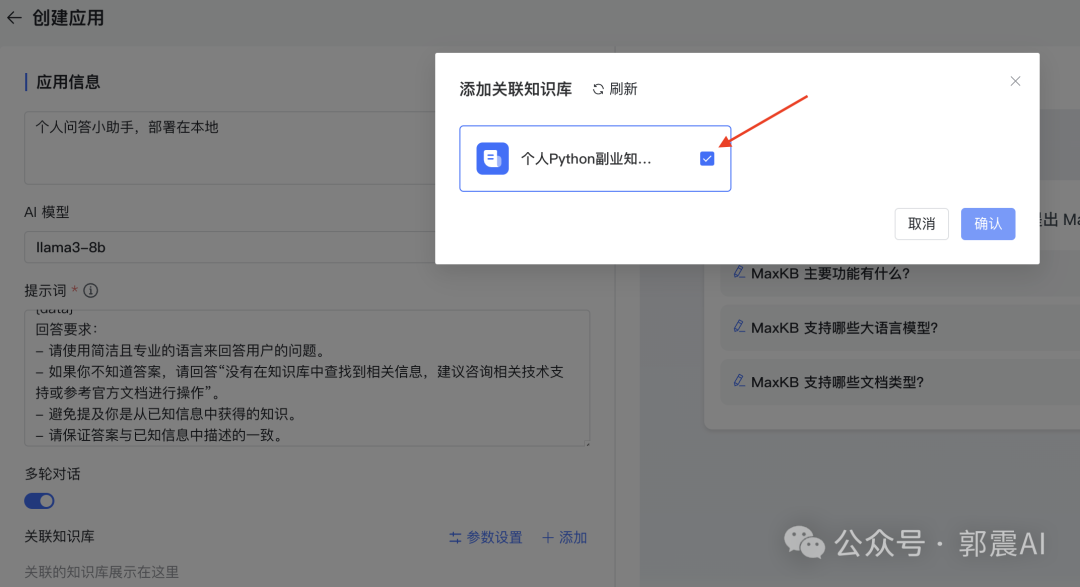

记得勾选这里:这样大模型和我们本地知识库就关联起来了:

记得勾选这里:这样大模型和我们本地知识库就关联起来了:

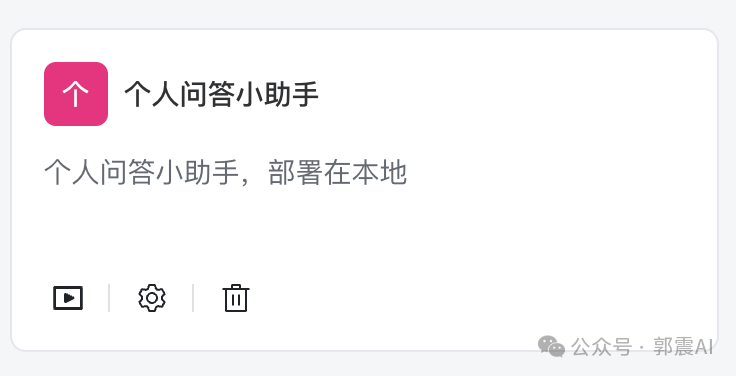

最后点击,创建,按钮,就会看到下面的应用:

最后点击,创建,按钮,就会看到下面的应用:

以上完整步骤,根据本文步骤,就可以实现文章开始的问答效果。老铁,原创教程不易,求点赞、在看、转发或留言,这样对我创作下一个良心教程会有莫大的动力!

以上完整步骤,根据本文步骤,就可以实现文章开始的问答效果。老铁,原创教程不易,求点赞、在看、转发或留言,这样对我创作下一个良心教程会有莫大的动力!

部署本地知识库,可以借助大模型能力,自动检索我们的工作学习文档,实现对文档内容的实时搜索与问答。 因为大模型、知识库和文档全部运行在本地,所以公司内的业务数据不会泄密,个人隐私不会泄密,保证这些同时,让:办公效率直接原地起飞! 搭建完成后,实现的效果如下:

按照本文教程走完 实现的本地知识库效果

大模型+个人知识库,太香了!

我在视频号也录制了一个回答效果,

老铁们可以参考,

视频号中有获取这个教程完整PDF版本的方法

2 docker下载MaxKB MaxKB是一个在本地搭建自己本地知识库问答的系统。主要优势: 1)开箱即用 2)支持GPT、百度千帆、Lama3,通义千问等几十种大语言模型 3)操作界面简介,小白也能快速上手 第一步,安装docker,如何下载docker,如何安装docker,我已经整理成详细的教程,不再赘述,不会的朋友,在我下面的公众号回复:AI,即可获取到PDF教程。安装后docker后,执行下面命令获取到MaxKB的镜像到本地:

下面是正在安装的过程:

下面是正在安装的过程: 整个MaxKb的镜像大小为2GB左右。

3 docker配置MaxKB

安装完成后,打开docker,按照下图逐步操作:

整个MaxKb的镜像大小为2GB左右。

3 docker配置MaxKB

安装完成后,打开docker,按照下图逐步操作: 在弹出的界面,点击 Run:

在弹出的界面,点击 Run:

这是弹出的界面,如果你的缺少Ports这样端口设置,可以重启电脑,然后再次打开进入这里,大概率应该会出现。

这是弹出的界面,如果你的缺少Ports这样端口设置,可以重启电脑,然后再次打开进入这里,大概率应该会出现。

然后按照下面填写:

然后按照下面填写: 注意,先不要关闭这个窗口,稍后我们还需要再填入一些信息。

注意,先不要关闭这个窗口,稍后我们还需要再填入一些信息。接下来,我们在自己的电脑上,创建一个存放知识库数据的文件夹,然后记住这个文件夹路径,因为我们还要返回到刚才的上面的界面,找到Volumes输入框,下图4处,填入刚才的知识库路径,我的路径如下: /Users/zhenguo/Documents/words 随后在Container path输入框中填入/var/lib/postgresql/data,下图5处,这是固定不变的,直接复制过去!

最后点击Run按钮,这样一个MaxKB容器就搭建完毕了!

4 打开MaxKB网页

浏览器打开下面链接,复制到浏览器中,看到MaxKB应用界面:

http://127.0.0.1:8080

最后点击Run按钮,这样一个MaxKB容器就搭建完毕了!

4 打开MaxKB网页

浏览器打开下面链接,复制到浏览器中,看到MaxKB应用界面:

http://127.0.0.1:8080

不过这里需要提供登录账号和密码, 大家关注我下面的公众号,并回复关键词 kb 获取: 登录进去后,初次登录到MaxKB后,需更改登录用户名和登录密码。看到创建应用程序的界面:

5 构建第一个知识库

我们先尝鲜它的知识库搭建,所以选择知识库导航这里:

5 构建第一个知识库

我们先尝鲜它的知识库搭建,所以选择知识库导航这里: 然后点击创建知识库按钮,就会出来下面页面:

然后点击创建知识库按钮,就会出来下面页面:

平时做过一些Python副业接单,把做过的其中一部分副业需求文档、传入到这个知识库里面,因为都是在本地构建,放心使用:

平时做过一些Python副业接单,把做过的其中一部分副业需求文档、传入到这个知识库里面,因为都是在本地构建,放心使用: 这里的知识库系统有两种,一种是通用型,也就是自己的文档本地上传,另一种是web站点,用某些网站作为知识库构建的数据来源。在这里根据我的需求,应该选择通用型。

然后点击进入选择文件夹这里,上传我的Python副业代码文件,说明文档,数据格式可以是txt、word、pdf、ppt等,在确定需要上传的文档后,点击右下角的“创建并导入”按钮。

这里的知识库系统有两种,一种是通用型,也就是自己的文档本地上传,另一种是web站点,用某些网站作为知识库构建的数据来源。在这里根据我的需求,应该选择通用型。

然后点击进入选择文件夹这里,上传我的Python副业代码文件,说明文档,数据格式可以是txt、word、pdf、ppt等,在确定需要上传的文档后,点击右下角的“创建并导入”按钮。

如下图所示,上传这里面的文件到本地MaxKB系统,还可以直接读取一个文件夹,这样就更方便了。为了加快接入,选择一部分文件作为测试:

如下图所示,上传这里面的文件到本地MaxKB系统,还可以直接读取一个文件夹,这样就更方便了。为了加快接入,选择一部分文件作为测试:

然后点击右下角 创建并导入

然后点击右下角 创建并导入

导入后,系统就会开始处理分析和接入,文档导入时间长短取决于文档内容的多少,内容越多,导入时间就越长。

导入后,系统就会开始处理分析和接入,文档导入时间长短取决于文档内容的多少,内容越多,导入时间就越长。

6 配置本地llama3

MaxKB网站内的应用界面中,按照如下所示点击系统设置,然后再进入模型设置界面

6 配置本地llama3

MaxKB网站内的应用界面中,按照如下所示点击系统设置,然后再进入模型设置界面

可以看到这里支持的大模型比较多:

可以看到这里支持的大模型比较多:

我以ollama+llama3配置为例,之前我已经总结过配置这些的详细教程,关注我的公众号,然后发消息:AI,直接获取PDF教程。在这里不再赘述。安

装完ollama和llama3后,

开始

下面一步,非常重要,按照我的这个说明,对应填写

,然后点击添加:

我以ollama+llama3配置为例,之前我已经总结过配置这些的详细教程,关注我的公众号,然后发消息:AI,直接获取PDF教程。在这里不再赘述。安

装完ollama和llama3后,

开始

下面一步,非常重要,按照我的这个说明,对应填写

,然后点击添加:

添加成功后,会显示下面界面:

添加成功后,会显示下面界面: 7 创建知识库应用

这是最后一步了,回到MaxKB界面:

7 创建知识库应用

这是最后一步了,回到MaxKB界面:

点击

应用

,然后

创建应用

,

填写

应用名称

、

应用描述

,

AI模型

这里,选择我们刚才创建的MaxKB里的llama3模型,如下所示,按照这样填写:

点击

应用

,然后

创建应用

,

填写

应用名称

、

应用描述

,

AI模型

这里,选择我们刚才创建的MaxKB里的llama3模型,如下所示,按照这样填写:

记得勾选这里:这样大模型和我们本地知识库就关联起来了:

记得勾选这里:这样大模型和我们本地知识库就关联起来了: 最后点击,创建,按钮,就会看到下面的应用:

最后点击,创建,按钮,就会看到下面的应用:

以上完整步骤,根据本文步骤,就可以实现文章开始的问答效果。老铁,原创教程不易,求点赞、在看、转发或留言,这样对我创作下一个良心教程会有莫大的动力!

以上完整步骤,根据本文步骤,就可以实现文章开始的问答效果。老铁,原创教程不易,求点赞、在看、转发或留言,这样对我创作下一个良心教程会有莫大的动力!