基于微调技术打造自己的私有LLM大模型

共 2432字,需浏览 5分钟

· 2023-11-01

▼最近直播超级多,预约保你有收获

近期直播:《基于开源 LLM 大模型的微调(Fine tuning)实战》

— 1 —

LLM 大模型微调(Fine tuning)技术

Fine tuning 是指在预训练模型的基础上,使用特定的任务数据对模型进行重新训练,以适应具体的应用场景或任务。通常,预训练模型通过大规模数据集进行事先训练,获得广泛的语言理解和生成能力。而 Fine tuning 则是在此基础上,针对特定任务的数据集进行进一步训练,以使模型更好地适应该任务,并提高其性能。通过 Fine tuning,可以使模型更加专业化,提高在具体任务上的准确性和效果。

— 2 —

微调(Fine tuning)实现原理

Fine tuning 是一种迁移学习的方法,它基于预先训练好的模型,提供特定语料进行微调,让机器人学习指定的数据格式进行模仿创新,使之适应特定的任务。

— 3 —

微调(Fine tuning)适用场景

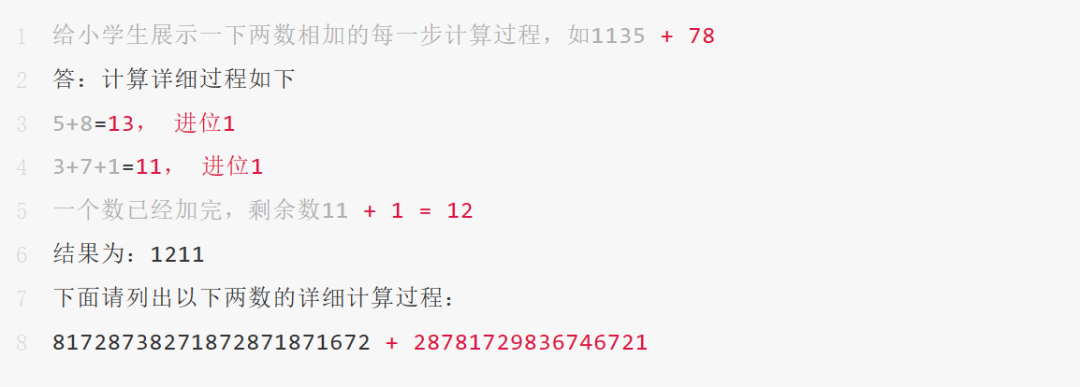

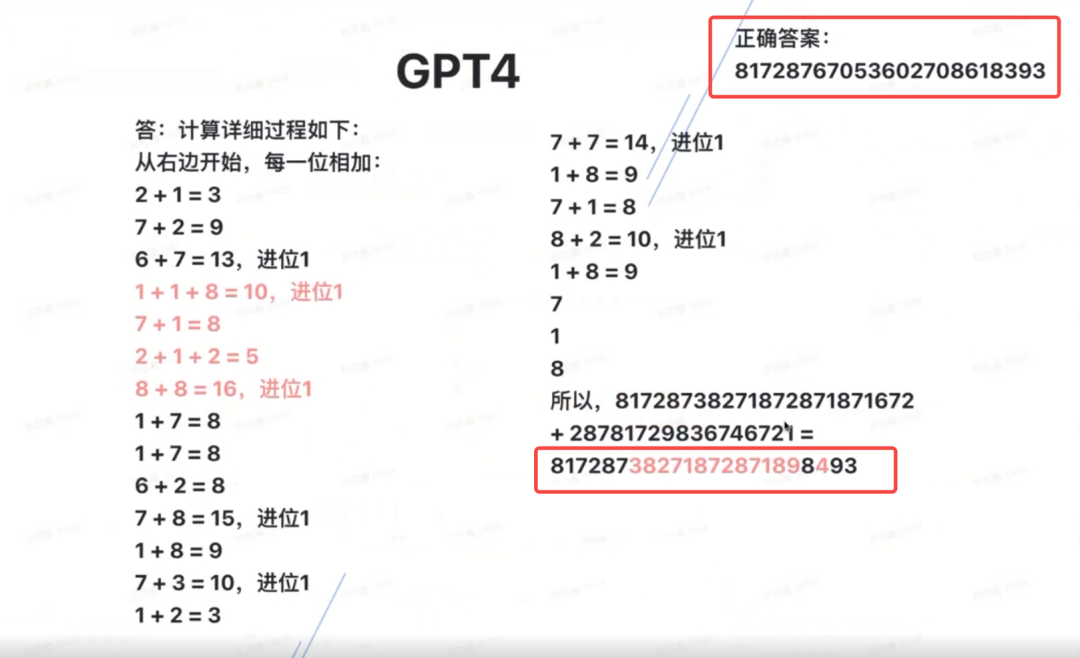

Fine tuning(微调),更适合于教授模型新的任务或模式,而不是新的信息。微调就是在大模型的数据基础上做二次训练,事先准备好一批 Prompt-Complition(类似于问答Q&A)的数据,生成新的模型,这个模型将会包含微调后的数据。比如,你可以使用 Fine tuning 来训练模型生成特定风格的文本,或者执行特定的 NLP 任务。Fine tuning 并不适合于作为知识存储,也不适合于问答任务。

ChatGPT 就像一个已经训练好的家政阿姨,她懂中文,会做家务,但是对你家里的情况不了解。微调就相当于阿姨第一次到你家干活的时候,你要花一小时时间告诉她家里的情况,比如物件的摆放、哪些地方不能动,哪些地方要重点照顾。

— 4 —

微调(Fine tuning)训练步骤

Fine tuning 一般包括以下步骤:

— 5—

免费超干货 LLM 大模型直播

为了帮助同学们掌握好大模型的微调技术,本周日晚8点,我会开一场直播和同学们深度聊聊大模型的技术、分布式训练和参数高效微调,请同学点击下方按钮预约直播,咱们本周日晚8点不见不散哦~~

END