作者:Gadi Singer May 11, 2022翻译:陈超

校对:zrx

本文将讨论机器学习中上下文的重要性,以及后期绑定上下文如何提高机器启蒙的标准。

图片版权:REDPIXEL via Adobe Stock

我们中的大多数人肯定听过这句谚语,“形象就是一切。”但谈到将AI升级到一个新的水平时,上下文才是一切。

上下文意识体现了人类学习的所有精细差别。正是‘谁’‘为什么’‘何时’为人类决策和行为提供了信息。如果没有上下文,当前的基础模型注定会转动车轮,并最终改变AI用于改善我们生活的期望轨迹。

这篇博客将讨论机器学习中上下文的重要性,以及后期绑定上下文如何提高机器启蒙的标准。

为什么上下文很重要

上下文深度嵌入人类学习当中,以至于很容易忽视它在我们对给定上下文反应当中的重要作用。为了阐明这一点,让我们假设一个两人对话场景,一个简单的问题开始:祖母怎么样?

在真实世界的对话当中,这个简单的问题会基于上下文因素(包括时间,环境,关系等)引发任意数量的潜在响应。

图1.对“祖母怎么样?”的合适回答是高度依赖上下文的。图片版权:Intel labs该问题表明人类思维是怎样追踪并把大量上下文信息,甚至微妙的幽默,纳入考虑以返回相关响应的。这种流畅地适应大量且精细的上下文的能力远远超出了现代AI系统的能力范畴。为了掌握这种机器学习缺陷的重要性,需要考虑基于强化学习(RL)的自主代理和机器人的发展。尽管基于RL的架构已经在Dota2和StarCraft II等模拟游戏环境中大肆宣传并获得成功,但由于在游戏中取得胜利所要求的策略具有高度上下文性和复杂性,即使像NetHack纯游戏环境都给当前的RL系统设置了一个可怕的障碍。相似地,在不需要认真的工程工作来在配置之前模拟正确类型的环境,或者强化习得规则却实现与以前从未见过的物理环境交互之前,自主机器人还有很长的路要走。当前机器学习和上下文查询处理

一般情况下,大部分机器学习模型都包含特定查询的非常有限的上下文,且主要依赖于由模型被训练或调试好的数据集提供的通用上下文。这些模型引发了对偏差的顾虑:这使得他们不适用于商业、医疗保健和其他重要应用程序。即使是最先进的语音助手AI应用程序中使用的最先进的模型(如D3ST),也需要手动创建模型需要识别上下文的可能意图和行动的架构或本体的描述。虽然这其中只涉及了相对最低的人工制作水平,但它意味着每一次任务上下文更新时都需要明确的人工输入。这并不是说机器学习模型在上下文感知上没有重大发展。OpenAI团队打造的著名大型语言模型GPT-3已经被用于生成可与人类创作相媲美的完整文章——这项任务至少需要追踪局部的上下文。Google于2022年4月推出的路径语言模型(Pathways Language Model, PaLM)则展示了更强大的功能,包括在适当的上下文下理解概念组合以对复杂查询做出响应的能力。

图2.PaLM能够成功的处理需要在相同概念但不同上下文之间切换的查询。图片版权:Google Research[13] CC BY 4.0 许可证

输入:Michael 正在法国那个非常著名的博物馆欣赏最著名的画。然而创作这幅画的艺术家让Michael想起了他童年最喜欢的卡通人物。卡通人物经常拿在手里的东西起源于那个国家?模型输出:卢浮宫最著名的画是蒙娜丽莎,蒙娜丽莎的作者是莱昂纳多·达·芬奇。莱昂纳多·达·芬奇也是动画忍者神龟少年变种人。莱昂纳多·达·芬奇来自意大利。他经常拿在手上的是武士刀。武士刀起源于日本,所以答案是“日本”。最近许多进展集中在基于检索的查询增强上,其中模型(查询)的输入由从辅助数据库自动检索相关数据来补充。这使得问答和推理等应用程序而非知识图谱本身取得了重大进展。即使在上下文约束下,可实现输出的质量也得到了相当大的提高,因此可能很容易推断这表明了现代AI系统更普遍的上下文感知。然而,这些模型仍然没有提供更复杂的应用程序所需的上下文,例如制造,医疗实践等。这样的应用程序通常需要在上下文方面具备一定的流动性——正如之前一篇博客中的适应性部分讨论的那样。例如,相关的上下文必须以时间信息为条件,例如用户请求的紧急程度或交互的目标和敏感性。这种适应性允许给定查询的适当上下文根据与人类通信的进度而发展。用简单的人类术语来说,模型必须避免在已经掌握所有相关上下文信息前就跳到任何结论。这种对原始查询最终响应的仔细定时暂停就被叫做迟绑定上下文。值得一提的是,最近神经网络模型确实有能力实现一些迟绑定上下文。例如,如果模型附加了一个辅助数据库,如维基百科,它可以用最新版本的维基数据来调整其响应,从而在提供对特定查询的响应之前考虑一定程度的时间相关上下文。高度重视上下文的领域之一是对话式AI,尤其是多轮对话建模。然而,必须承认在提供主题意识以及考虑隐含时间、先验知识和意图方面,仍存在关键性挑战。目前部署的大多数AI技术的问题在于即使他们可以在特定情况下执行条件过程,随着时间推移进行条件执行对许多应用程序来说仍然是一个挑战,因为它需要对手头任务的理解以及之前发生的时间记忆进行结合,并以此充当先验条件。考虑一个更轻松、更象征性的例子,人们可以回想一下加拿大侦探节目“默多克之谜”,它以“你有什么,乔治?”而闻名。这是侦探默多克不断用来询问警员克拉布特里最新事态发展的短语,而答案总是不同的,并且高度依赖于故事中以前发生的事件。在机器学习中建立上下文

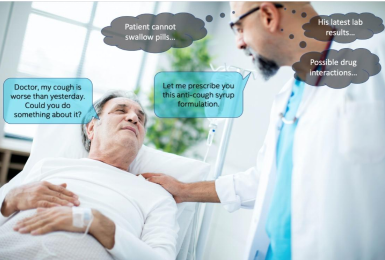

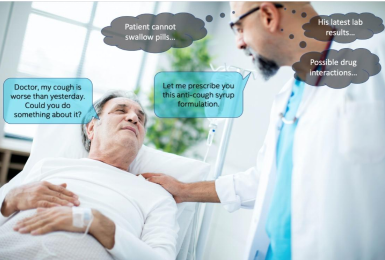

所以怎样才能在机器学习中大规模地整合并利用迟绑定呢?一种方法是创造提供相关上下文信息的重叠层的元知识的“选择掩蔽”或“叠加”从而有效缩小基于特定使用实例的检索参数的范畴。在正确处方的医疗检索的实例中,比如,医生可能会考虑病人的诊断情况,其他并发症,年龄,既往不良反应史和过敏等问题,将检索空间限制到特定的药物。为了解决上下文的迟绑定,此类叠加必须是动态的,以捕捉最新信息,基于实例特定知识优化范围,理解交互目的等。

图3:正确的医疗决策需要大量基于患者的上下文考虑。图片版权:Intel Labs

源归因是另外一个重要的元知识维度,对被用于启动迟绑定上下文的选择掩码尤其有用。这就是一个模型如何使一个特定来源比另一个来源更可靠的方式-比如新英格兰医学杂志与匿名帖子。源归因的另一个应用是选择被应用于给定上下文(例如,当地司法管辖区的法律、或特定州的交通规则)的决策规则和限制的正确集合。源归因也是通过在资源创造的上下文而非通过统计发生率来假定正确性上下文信息以减少偏差的关键。本文并未涉及到一个非常重要的方面——人类或未来的AI系统到底是怎样选择相关信息并作为特定查询的上下文考虑的呢?为了找到上下文相关的数据,个体必须搜索的数据结构是什么,以及该结构是如何被学习的?关于这些问题的更多内容将会在未来的推文中提到。避免脱离上下文考虑智能

AI领域在整合条件、组合性和上下文的方向上正取得长足进步。然而,升级版的机器智能要能够在整合动态理解并应用迟绑定的多方面能力上取得显著的进展。当在高度感知、在实时交互AI的范畴内考虑时,上下文就是一切。

参考文献

1.Bommasani, R., Hudson, D. A., Adeli, E., Altman, R., Arora, S., von Arx, S., … & Liang, P. (2021). On the opportunities and risks of foundation models.(https://arxiv.org/abs/2108.07258) arXiv preprint arXiv:2108.07258.

2.Berner, C., Brockman, G., Chan, B., Cheung, V., Dębiak, P., Dennison, C., … & Zhang, S. (2019). Dota 2 with large scale deep reinforcement learning.(https://cdn.openai.com/dota-2.pdf) arXiv preprint arXiv:1912.06680.

3.Vinyals, O., Babuschkin, I., Czarnecki, W. M., Mathieu, M., Dudzik, A., Chung, J., … & Silver, D. (2019). Grandmaster level in StarCraft II using multi-agent reinforcement learning.(https://www.nature.com/articles/s41586-019-1724-z) Nature, 575(7782), 350–354.

4.Küttler, H., Nardelli, N., Miller, A., Raileanu, R., Selvatici, M., Grefenstette, E., & Rocktäschel, T. (2020). The nethack learning environment.(https://proceedings.neurips.cc/paper/2020/hash/569ff987c643b4bedf504efda8f786c2-Abstract.html) Advances in Neural Information Processing Systems, 33, 7671–7684.

5.Kostrikov, I., Nair, A., & Levine, S. (2021). Offline reinforcement learning with implicit q-learning.(https://arxiv.org/abs/2110.06169) arXiv preprint arXiv:2110.06169.

6.Ibarz, J., Tan, J., Finn, C., Kalakrishnan, M., Pastor, P., & Levine, S. (2021). How to train your robot with deep reinforcement learning: lessons we have learned.(https://journals.sagepub.com/doi/abs/10.1177/0278364920987859) The International Journal of Robotics Research, 40(4–5), 698–721.

7.Loquercio, A., Kaufmann, E., Ranftl, R., Müller, M., Koltun, V., & Scaramuzza, D. (2021). Learning high-speed flight in the wild. (https://www.science.org/doi/abs/10.1126/scirobotics.abg5810)Science Robotics, 6(59), eabg5810.

8.Yasunaga, M., Ren, H., Bosselut, A., Liang, P., & Leskovec, J. (2021). Qa-gnn: Reasoning with language models and knowledge graphs for question answering. (https://arxiv.org/abs/2104.06378)arXiv preprint arXiv:2104.06378.

9.Mehrabi, N., Morstatter, F., Saxena, N., Lerman, K., & Galstyan, A. (2021). A survey on bias and fairness in machine learning. (https://dl.acm.org/doi/abs/10.1145/3457607)ACM Computing Surveys (CSUR), 54(6), 1–35.10.Zhao, J., Gupta, R., Cao, Y., Yu, D., Wang, M., Lee, H., … & Wu, Y. (2022). Description-Driven Task-Oriented Dialog Modeling. (https://arxiv.org/abs/2201.08904)arXiv preprint arXiv:2201.08904.11.Brown, T., Mann, B., Ryder, N., Subbiah, M., Kaplan, J. D., Dhariwal, P., … & Amodei, D. (2020). Language models are few-shot learners.(https://arxiv.org/abs/2005.14165) Advances in neural information processing systems, 33, 1877–1901.12.Reporter, G. S. (2020, September 11). A robot wrote this entire article. Are you scared yet, human?(https://www.theguardian.com/commentisfree/2020/sep/08/robot-wrote-this-article-gpt-3) The Guardian.13.Chowdhery, A., Narang, S., Devlin, J., Bosma, M., Mishra, G., Roberts, A., … & Fiedel, N. (2022). Palm: Scaling language modeling with pathways. (https://arxiv.org/pdf/2204.02311.pdf)arXiv preprint arXiv:2204.02311.14.Lewis, P., Perez, E., Piktus, A., Petroni, F., Karpukhin, V., Goyal, N., … & Kiela, D. (2020). Retrieval-augmented generation for knowledge-intensive nlp tasks.(https://arxiv.org/pdf/2005.11401.pdf) Advances in Neural Information Processing Systems, 33, 9459–9474.15.Borgeaud, S., Mensch, A., Hoffmann, J., Cai, T., Rutherford, E., Millican, K., … & Sifre, L. (2021). Improving language models by retrieving from trillions of tokens. (https://arxiv.org/abs/2112.04426)arXiv preprint arXiv:2112.04426.16.Singer, G. (2022, January 15). LM!=KM: The Five Reasons Why Language Models Fall Short of Supporting Knowledge Model Requirements of Next-Gen AI. (https://towardsdatascience.com/lm-km-3e81e1e1c3ae)Medium.17.Moore, A. W. (2022, April 14). Conversational AI’s Moment Is Now.(https://www.forbes.com/sites/googlecloud/2022/03/21/conversational-ais-moment-is-now/?sh=cb239b053919) Forbes.18.Xu, Y., Zhao, H., & Zhang, Z. (2021, May). Topic-aware multi-turn dialogue modeling. (https://www.aaai.org/AAAI21Papers/AAAI-9758.XuY.pdf)In The Thirty-Fifth AAAI Conference on Artificial Intelligence (AAAI-21).19.Li, Y., Li, W., & Nie, L. (2022). Dynamic Graph Reasoning for Conversational Open-Domain Question Answering. (https://dl.acm.org/doi/full/10.1145/3498557)ACM Transactions on Information Systems (TOIS), 40(4), 1–24.20.Gao, C., Lei, W., He, X., de Rijke, M., & Chua, T. S. (2021). Advances and challenges in conversational recommender systems: A survey. (https://www.sciencedirect.com/science/article/pii/S2666651021000164)AI Open, 2, 100–126.21.Singer, G. (2022b, May 9). Understanding of and by Deep Knowledge(https://towardsdatascience.com/understanding-of-and-by-deep-knowledge-aac5ede75169) — Towards Data Science. Medium.

陈超,北京大学应用心理硕士在读。本科曾混迹于计算机专业,后又在心理学的道路上不懈求索。越来越发现数据分析和编程已然成为了两门必修的生存技能,因此在日常生活中尽一切努力更好地去接触和了解相关知识,但前路漫漫,我仍在路上。

工作内容:需要一颗细致的心,将选取好的外文文章翻译成流畅的中文。如果你是数据科学/统计学/计算机类的留学生,或在海外从事相关工作,或对自己外语水平有信心的朋友欢迎加入翻译小组。

你能得到:定期的翻译培训提高志愿者的翻译水平,提高对于数据科学前沿的认知,海外的朋友可以和国内技术应用发展保持联系,THU数据派产学研的背景为志愿者带来好的发展机遇。

其他福利:来自于名企的数据科学工作者,北大清华以及海外等名校学生他们都将成为你在翻译小组的伙伴。

点击文末“阅读原文”加入数据派团队~

转载须知

如需转载,请在开篇显著位置注明作者和出处(转自:数据派ID:DatapiTHU),并在文章结尾放置数据派醒目二维码。有原创标识文章,请发送【文章名称-待授权公众号名称及ID】至联系邮箱,申请白名单授权并按要求编辑。

发布后请将链接反馈至联系邮箱(见下方)。未经许可的转载以及改编者,我们将依法追究其法律责任。