ECCV 2022 | 多域长尾分布学习,不平衡域泛化问题研究(开源)

极市导读

本文由被ECCV2022接受论文的作者亲自解读,讲述如何推广传统不平衡分类问题的范式,将数据不平衡问题从单领域推广到多领域。 >>加入极市CV技术交流

前言

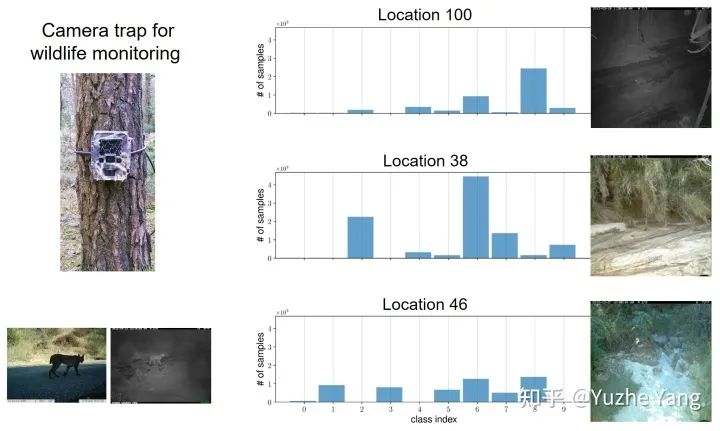

1. 研究背景与动机

2. 多域长尾学习的难点与挑战

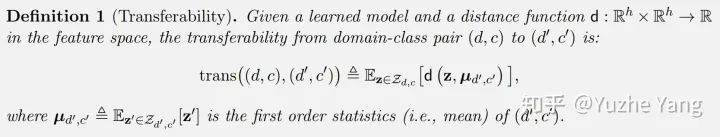

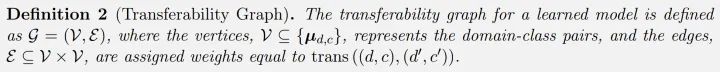

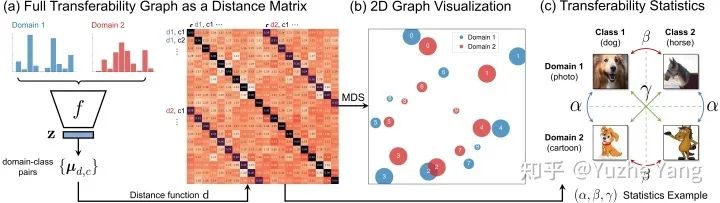

3. Domain-Class Transferability Graph(域-类对可转移性图)

4. 什么是多域长尾学习上好的特征?

4.1. 发现1:跨域不匹配的标签分布会阻碍模型学到可转移的特征

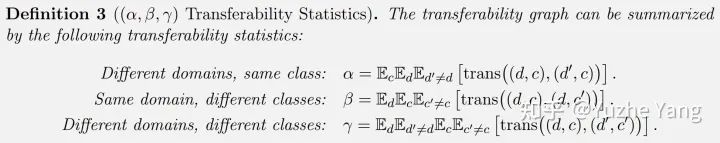

4.2. 发现2:转移统计量刻画了模型的泛化能力

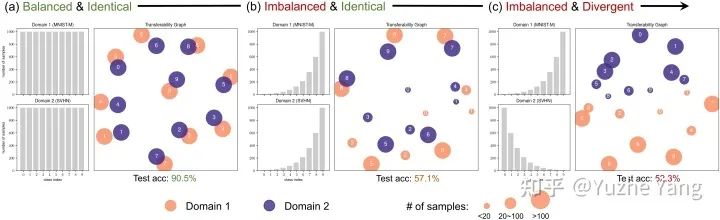

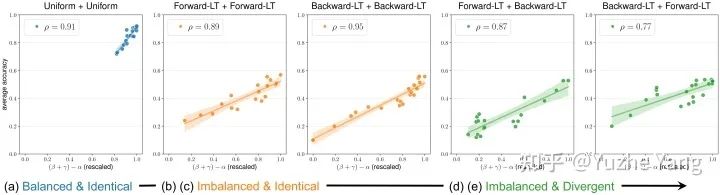

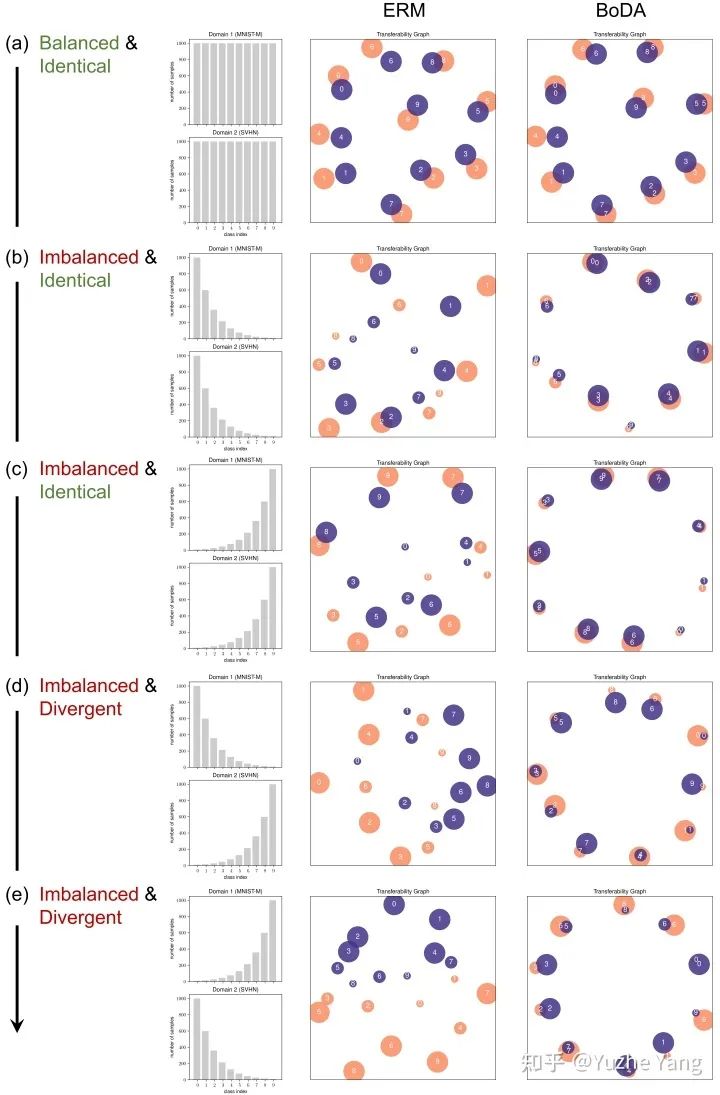

( ) 统计量表征了模型在 MDLT 中的性能。特别是, 统计量在整个范围上和每个标签配置的测试性能均显示出非常强的相关性。 数据不平衡会增加学到不可迁移特征的风险。当跨域的标签分布一致且平衡时(图a),模型对变化的参数具有鲁棒性,在右上区域聚集。然而,随着标签变得不平衡(图b、c)和进一步发散(图d、e),模型学习不可迁移特征(即较低的 )的机会增加,导致性能大幅下降。

4.3.BoDA: 一种能 Bound 转移统计量的损失函数

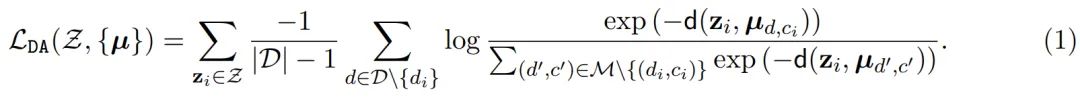

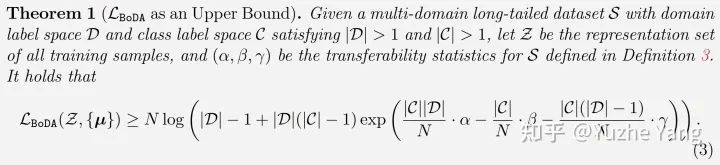

是 ( ) 统计量的一种理想的形式的upper-bound。通过最小化 ,我们确保了低 (吸引相同的类)和高 (分离不同的类),这是 MDLT 中泛化的必要条件,自然转化为更好的性能。 统计量中的常数因子对应于每个部分对可迁移性图的贡献程度。我们注意到在 里,目标与 成正比。根据定义3,我们注意到 总结了同一类的数据相似性,而 $ \frac1}{β + \frac\gamma βγ$ 的加权平均值总结了不同类的数据相似性,其中它们的权重与相关域的数量成正比(即, 为 1, 为 )。

4.4. 校准数据不平衡可以得到更好的转移性

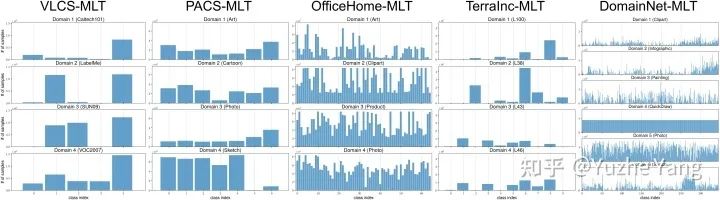

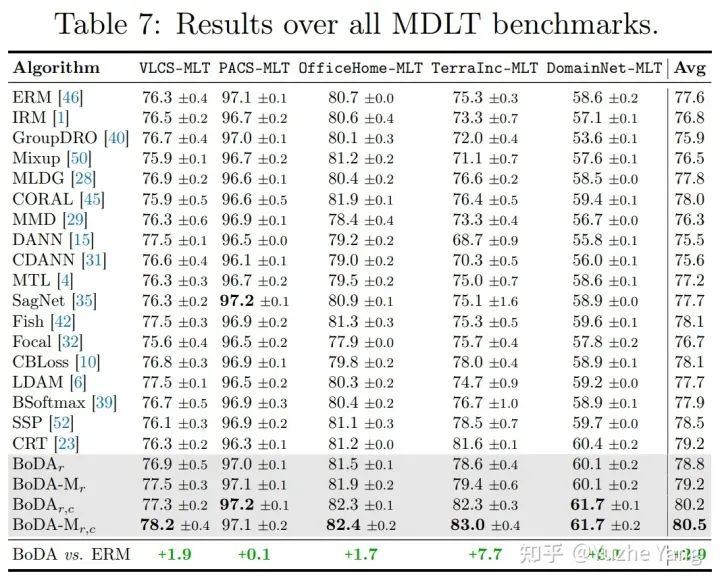

5. 基准MDLT数据集及实验分析

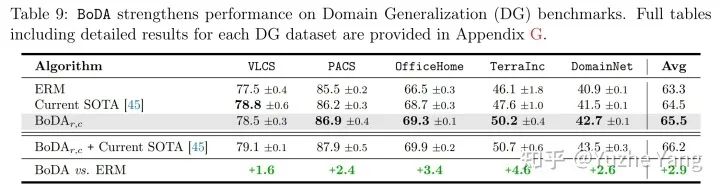

6. MDLT 更进一步:不平衡域泛化问题

7. 结语

参考

Recognition in Terra Incognita. ECCV, 2018. Multidimensional scaling. Measurement, judgment and decision making, pages 179–250, 1998. Domain-adversarial training of neural networks. Journal of machine learning research, 17(1):2096–2030, 2016. Reading digits in natural images with unsupervised feature learning. NIPS Workshop on Deep Learning and Unsupervised Feature Learning, 2011. In search of lost domain generalization. In ICLR, 2021. Delving into Deep Imbalanced Regression. ICML, 2021.

公众号后台回复“目标检测综述”获取目标检测(2001-2021)综述PDF~

“

点击阅读原文进入CV社区

收获更多技术干货

评论