来源:知乎—gwave

目录

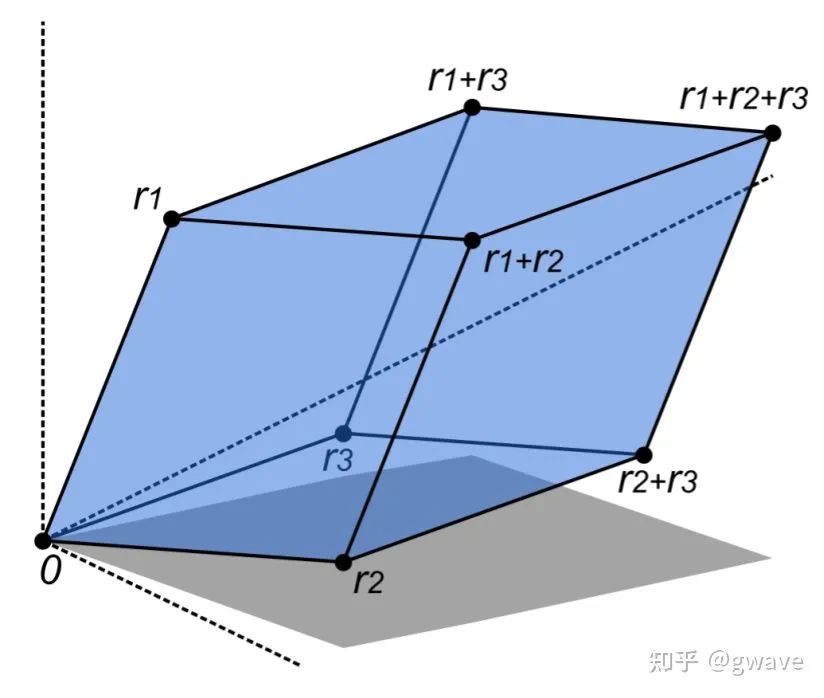

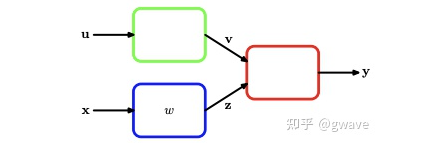

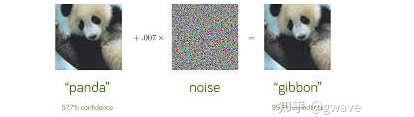

坐标变换 1D 变量替换 Jacobian矩阵 Jacobian行列式 神经网络BP误差反向传播 Jacobian regularization Carl Jacob Jacobi简介

01

02

03

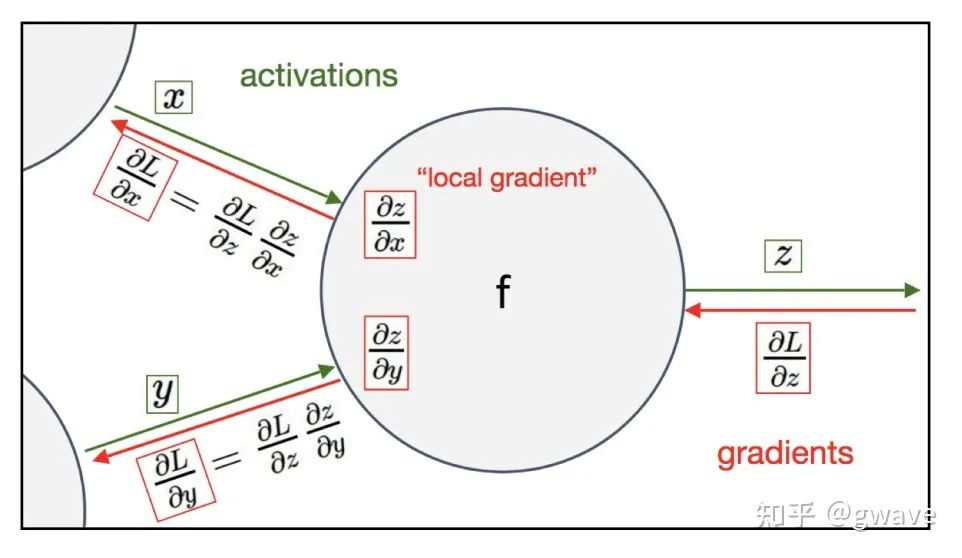

Jacobian矩阵可被视为是一种组织梯度向量的方法。 梯度向量可以被视为是一种组织偏导数的方法。 故,Jacobian矩阵可以被视为一个组织偏导数的矩阵。

04

05

06

https://arxiv.org/pdf/1908.02729.pdf

07

猜您喜欢:

戳我,查看GAN的系列专辑~!

一顿午饭外卖,成为CV视觉前沿弄潮儿! CVPR 2022 | 25+方向、最新50篇GAN论文 ICCV 2021 | 35个主题GAN论文汇总 超110篇!CVPR 2021最全GAN论文梳理 超100篇!CVPR 2020最全GAN论文梳理

附下载 |《TensorFlow 2.0 深度学习算法实战》