MIT新研究:AI仅靠看X光片就能准确识别患者种族,但没人知道为什么

大数据文摘

共 2880字,需浏览 6分钟

· 2022-05-27

AI能通过胸片识别患者种族?“我以为我的学生疯了”

AI能通过胸片识别患者种族?“我以为我的学生疯了”

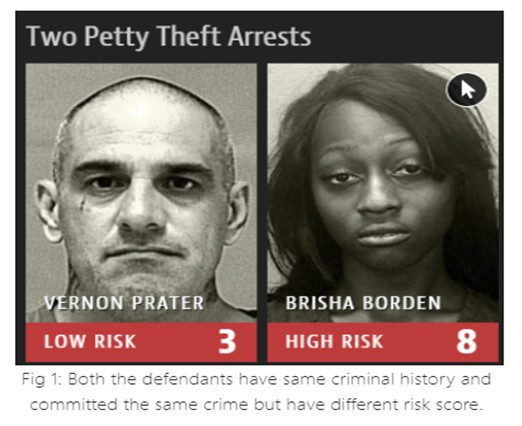

防不胜防的AI偏见

防不胜防的AI偏见

https://news.mit.edu/2022/artificial-intelligence-predicts-patients-race-from-medical-images-0520

https://pubmed.ncbi.nlm.nih.gov/35568690/

评论

为什么我直播没人看啊?

晚上特地去你的房间,看你玩了几把,然后回来瞎聊几句。我不是这行的,只说说个人意见,仅供参考。

先说看了你直播后,我的感觉:

1.直播没有明显的特色;

2.为互动而互动,和弹幕对话生硬,没有自己的思路,也容易被弹幕反引导;

3.技术并不出众。不是说差,而是看不到精彩的亮点,对游戏没有自己独特的思考和看法;同样,在玩法上,也没有自己独特的套路玩法。所以,你应该就是个一般的高手,对英雄,战局,支援GANK,甚至版本,游戏前景,缺乏个性鲜明而睿智的理解和表达。

4.最大的一个问题:态度和气势。整体给我感觉到消极和弱。为什么不播吃鸡播王者,因为王者玩的轻松,吃鸡太累;音乐声音有点大?好,那我小一点;哎呀,感觉打不过;我也不清楚;我也

法无定法

0

为什么要研究游戏AI呢?

↑↑↑关注后"星标"Datawhale每日干货 & 每月组队学习,不错过 Datawhale干货 作者:叶鑫,伦敦大学玛丽女王学院,Datawhale成员AI作为时下计算机算法的超级巨星,在例如CV、NLP、语音、机器人等诸多领域都有广泛的...

Datawhale

0

notability手写识别好用吗各位 英文中文识别起来准确吗? ?

关于识别率:

英语识别率很高,我的英语笔记的话感觉识别准确率在90%以上!但中文就得写的很规矩才行了…

搜索出来大概这个效果:

关于实用性:

如果手写笔记内容比较多,那我认为手写识别功能还是很实用的!像我自己就笔记写太多以至于有的知识点都忘记自己写过… 这个时候就忍不住感叹“手写搜索”真的太好用了!!特别是当做题的时候,可以直接检索到对应知识点,就不用自己毫无头绪的翻来翻去了。

关于使用方法:

1. 在一个主题或全部主题内搜索内容:

2. 在单篇笔记内搜索内容:

(搜索出来手写和文字内容都会有)

3. 设置默认识别语言,设置后新建的笔记里就会自动按这个搜索和识别:

4. 设置单篇笔记识别的手写语言,不

一只懒洋洋

0