ACL 2022:评估单词多义性不再困扰?一种新的基准“DIBIMT”

共 3638字,需浏览 8分钟

· 2022-05-27

大数据文摘转载数据实战派

众所周知,单词多义性给NLP领域的研究带来了诸多困难,如词义消歧(Word Sense Disambiguation)、信息检索(IR, Information Retrieval)和机器翻译(MT, Machine Translation)等等。

而词汇歧义(Lexical Ambiguity)无疑是机器翻译领域面临的最大挑战之一。

在过去的几十年里,研究者也一直致力于调查由单词的多义性引起的错误翻译。在此研究范围内,一些研究认为模型能够学习接纳训练数据中存在的语义偏差,从而产生翻译错误。

实际上,最新的研究发现,训练数据中的语义偏差与翻译中的语义错误之间存在直接关联。

但是这些发现受到以下限制:

1)并非完全基于人工制定的基准;

2)严重依赖于自动生成的资源来确定翻译的准确性;

3)不包含多种语言组合。

而在 DIBIMT: A Novel Benchmark for Measuring Word Sense Disambiguation Biases in Machine Translation 这项工作中,这支研究团队解决了上述缺点,并提出了DIBIMT。据所知,这是首个完全人工制定的评估基准。

它能够广泛研究语义偏差对MT的五种不同语言组合的影响,涵盖名词和动词。这五种语言组合分别是英语和下列一种语言中的一种:汉语、德语、意大利语、俄语和西班牙语。该基准不仅可以让社区更好地探索所描述的现象,还可以设计出更好地处理词汇歧义的创新MT系统。

此外,团队还在最新测试平台上测试最前沿的MT系统(包括商业和非商业),并对测试结果进行了全面的统计和语言分析。值得一提的是,这项研究也获得了2022 ACL best resource paper。

构建过程

DIBIMT基准侧重于检测NMT中的词义消歧偏差,即某些词对其一些更常用词义的偏差。创建这样的数据集需要做到以下两点:

1)一组包含多义词且语法正确的句子;

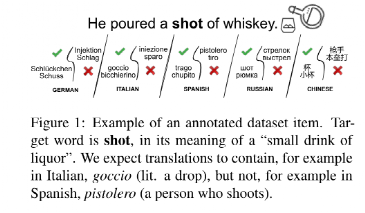

2)将每个目标词翻译成所涵盖语言的一组正确和错误的翻译,如图1所示。

首先,与先前的研究类似,团队依赖于BabelNet,这是一个大型多语言的百科全书词典,其节点是由同义词集表示的概念,即一组同义词,包含多种语言的词汇化并且来自各种异构资源,尤其是WordNet和维基词典(Wiktionary)。并对符号作出了一系列的定义。

其次,团队详细介绍了数据集的创建过程,即句子的选择以及条目的构建和过滤。

团队从两个主要来源收集初始项:WordNet 和Wiktionary。具体地说,团队成员使用了来自WordNet Tagged Glosses的示例,其中每个句子的目标词都与其同义词集进行了手动关联,从而很容易地提供第一批初始项。研究团队对原始句子应用过滤步骤,以选择可能对模型翻译更具挑战性的例子。

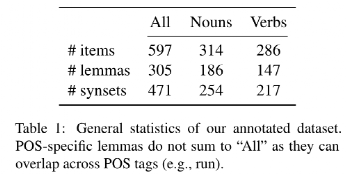

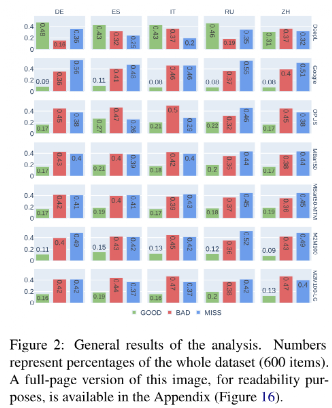

然后,开展数据集的注释任务。一旦初始项集准备好了,便可以继续进行注释阶段,将生成注释项。注释者分析了大约800个句子,丢弃了其中的200个句子,最终得到了5种语言的600个注释项。数据集统计数据如表1所示。正如预期的那样,从图2中可以注意到,注释者已经在所有语言中对 中的词汇化进行了大量改进。

中的词汇化进行了大量改进。

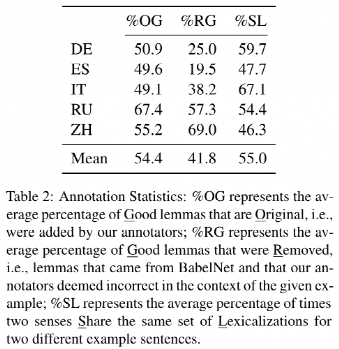

实际上,在各种语言中,平均增添了54%的好的词汇化,而现存的42%的词汇化已被删除。更重要的是,给定一个语言和两个包含相同同义词集的单词组成的句子,平均只有55%的情况下,他们也能分享这些单词的好的词汇化,从而证实假设,如果一个单词的所有同义词都是有效替换,可能会导致不正确的结果。

这些统计数据使团队得出一个简单但重要的结论:只有在有限的情况下,属于给定同义词集的词汇化才能被认为是所提供的目标词及其上下文的合适翻译等价物。

最后,是分析过程。

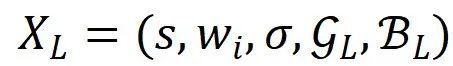

DIBIMT的分析过程相当简单:给定一个注释项 和翻译模型

和翻译模型 ,计算

,计算 ,即根据

,即根据 对语言L中的S进行翻译。随后,团队成员采用Stanza对tLand进行标记、词性标注和词形还原(lemmatization)。紧接着,检查译文中的词形还原与

对语言L中的S进行翻译。随后,团队成员采用Stanza对tLand进行标记、词性标注和词形还原(lemmatization)。紧接着,检查译文中的词形还原与 或

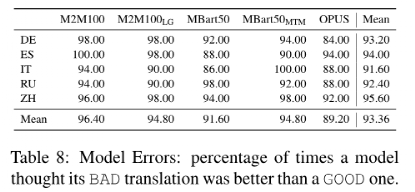

或 中所包含的是否匹配。如果不匹配,研究团队则将翻译标记为MISS;反之,根据与词性还原匹配的集合将其标记为GOOD或BAD。

中所包含的是否匹配。如果不匹配,研究团队则将翻译标记为MISS;反之,根据与词性还原匹配的集合将其标记为GOOD或BAD。

(约18%)或

(约18%)或 (约11%)中缺少术语。

(约11%)中缺少术语。

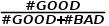

)。除了DeepL的表现远远优于其他竞争对手之外,其他模型的得分都非常低,在20%-33%之间。更令人惊讶的是,Google翻译在跨语言中表现最差。

)。除了DeepL的表现远远优于其他竞争对手之外,其他模型的得分都非常低,在20%-33%之间。更令人惊讶的是,Google翻译在跨语言中表现最差。

原文链接:

https://aclanthology.org/2022.acl-long.298/