本文是作者总结的今年计算机视觉领域最有趣的 10 篇研究论文,它是一个精选的 AI 和 CV 最新突破列表,本篇文章将带有清晰的视频解释和代码(如果有)。本文末尾列出了对每篇论文的完整参考。

2021 年排名前 10 的计算机视觉论文,包括视频演示、文章、代码和论文参考。

世界的经济活动在病毒的冲击下陷入了历史罕见的停滞中,但研究并没有放慢其狂热的步伐,尤其是在人工智能领域。今年的论文中除了一般的研究结果外还强调了许多重要方面,例如道德方面、重要偏见、治理、透明度等等。人工智能和我们对人脑及其与人工智能的联系的理解不断发展,显示出在不久的将来改善我们生活质量的有前景的应用。不过,我们应该谨慎选择应用哪种技术。

“科学不能告诉我们应该做什么,只能告诉我们可以做什么。”—— Jean-Paul Sartre, Being and Nothingness

以下是作者总结的今年计算机视觉领域最有趣的 10 篇研究论文,简而言之,它基本上是一个精选的 AI 和 CV 最新突破列表,本篇文章将带有清晰的视频解释和代码(如果有)。本文末尾列出了对每篇论文的完整参考。

完整视频链接:

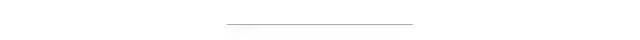

DALL·E: Zero-Shot Text-to-Image Generation from OpenAI [1]

OpenAI 成功训练了一个能够从文本标题生成图像的网络。它与 GPT-3 和 Image GPT 非常相似,并产生了惊人的结果。

代码:https://github.com/openai/DALL-E

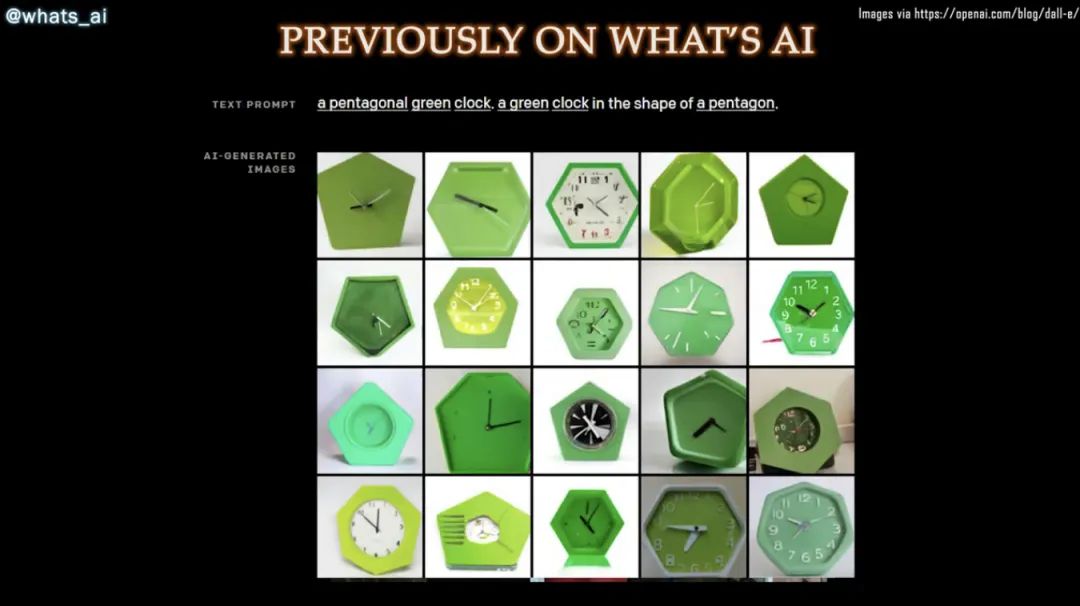

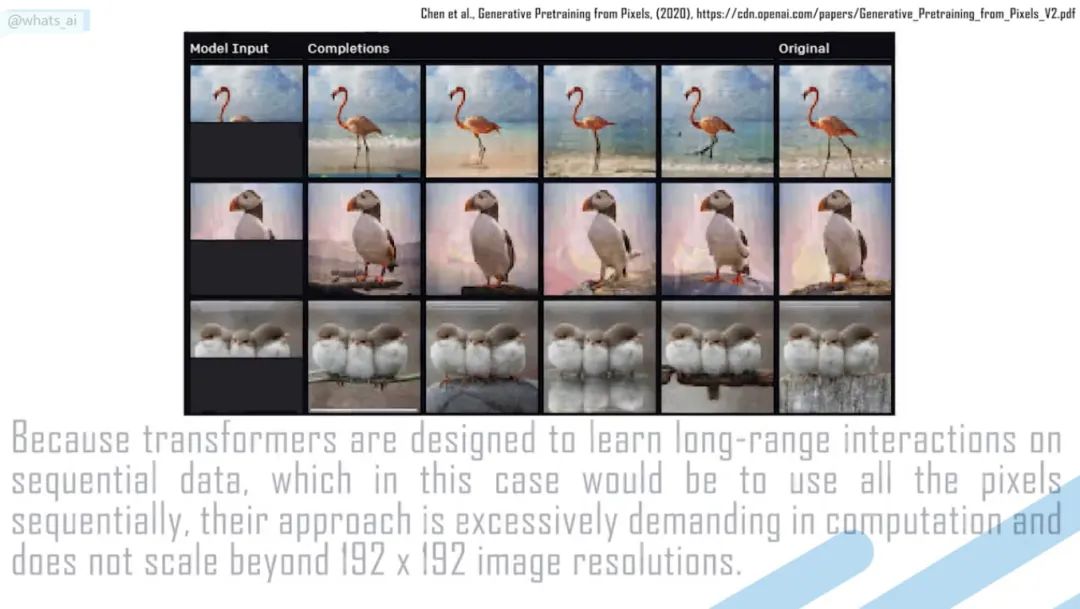

Taming Transformers for High-Resolution Image Synthesis [2]

将 GAN 和卷积方法的效率与Transformers 的表达能力相结合,为语义引导的高质量图像合成提供了一种强大且省时的方法。

代码:https://github.com/CompVis/taming-transformers

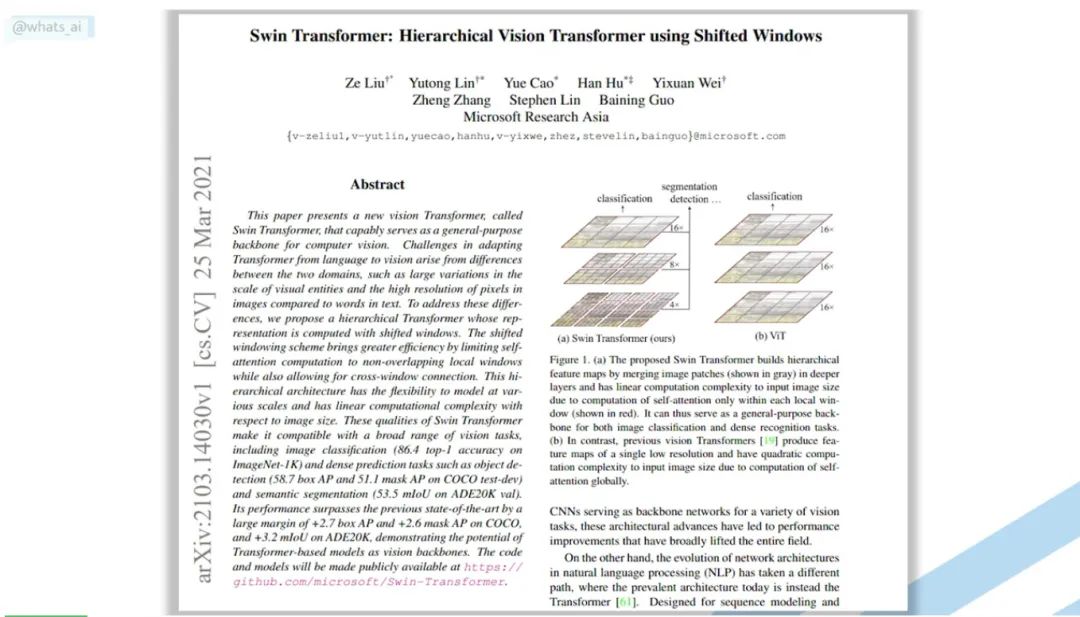

Swin Transformer: Hierarchical Vision Transformer using Shifted Windows [3]

Transformers 会取代计算机视觉中的 CNNs 吗?在不到 5 分钟的时间内,通过一篇名为 Swin Transformer 的新论文了解如何将 Transformer 架构应用于计算机视觉。

代码:https://github.com/microsoft/Swin-Transformer

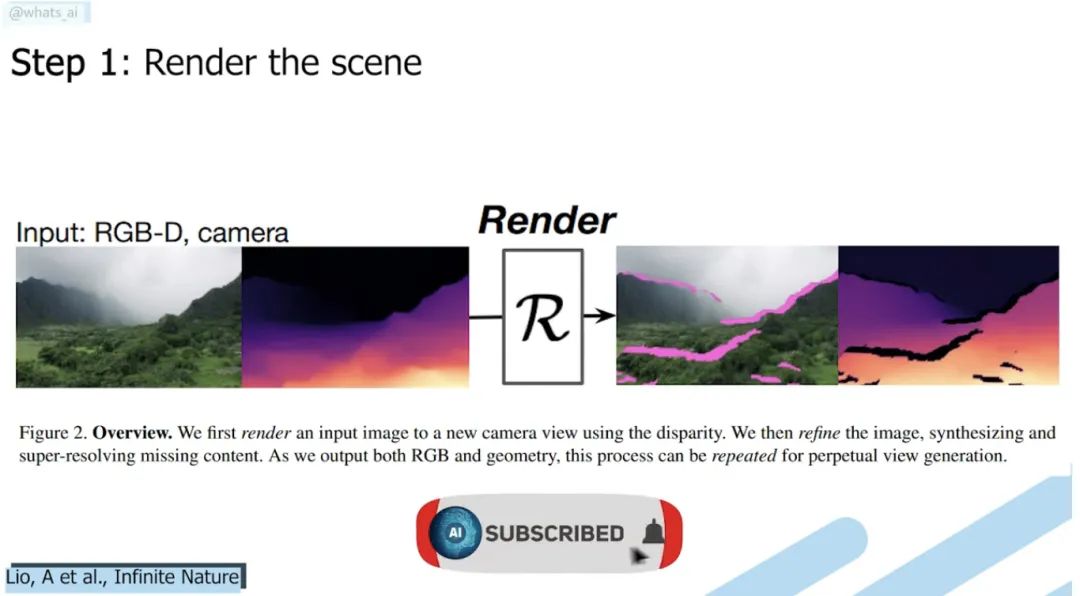

Infinite Nature: Perpetual View Generation of Natural Scenes from a Single Image [4]

视图合成的下一步:目标是拍摄一张图像,然后就可以进到图像中去探索风景!

DEMO:

https://colab.research.google.com/github/google-research/google-research/blob/master/infinite_nature/infinite_nature_demo.ipynb#scrollTo=sCuRX1liUEVM

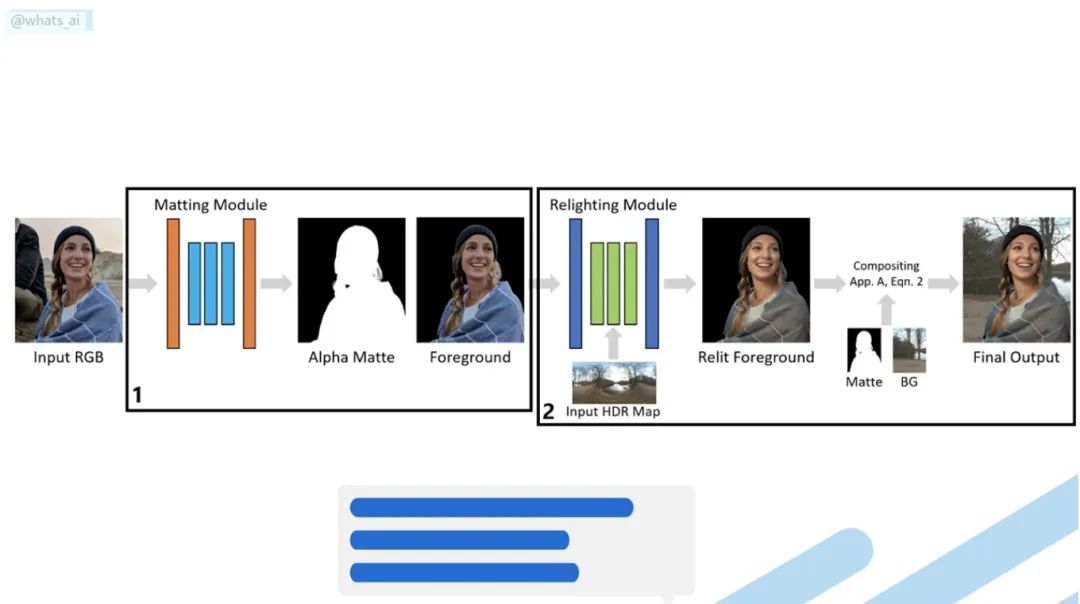

Total Relighting: Learning to Relight Portraits for Background Replacement [5]

根据添加的新背景的亮度重新为肖像补光。你有没有想过改变图片的背景,但让它看起来很逼真?如果已经尝试过就会知道这并不简单。你在家里拍一张自己的照片然后改变成海滩的背景, 任何人都会在一秒钟内说“那是经过Photoshop处理的”。对于电影和专业视频,需要完美的灯光和艺术家来再现高质量的图像,这非常昂贵。你无法用自己的照片做到这一点。但是这篇论文做到了

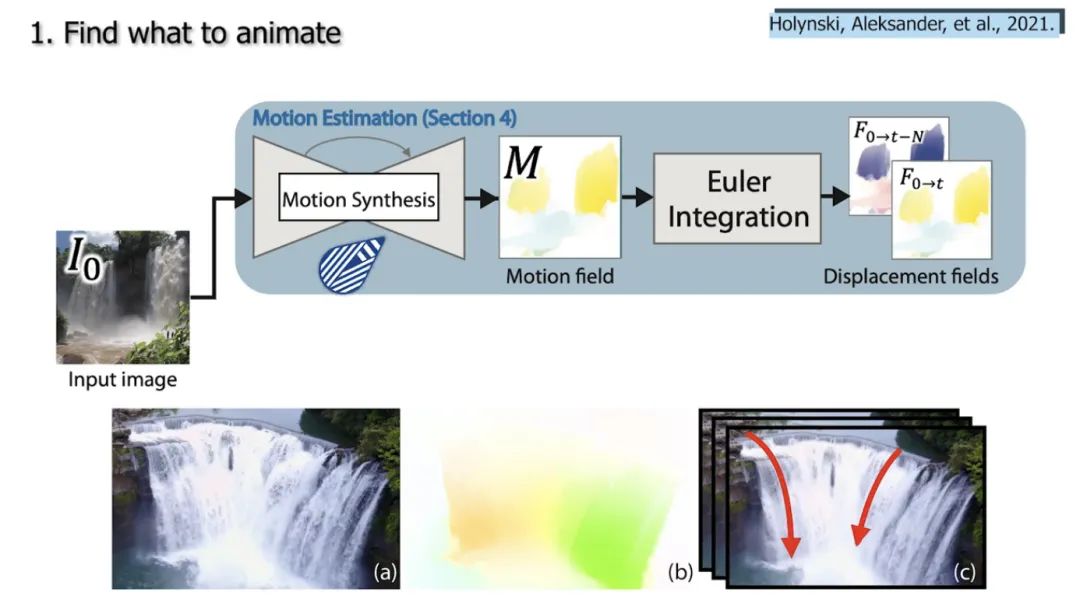

Animating Pictures with Eulerian Motion Fields [6]

该模型只通过拍摄一张照片,就能够了解哪些粒子应该在移动,并可以在限循环中为它们设置逼真的动画,同时完全保留图片的其余部分,这样我们可以将图片转换成动画……

代码:https://eulerian.cs.washington.edu/

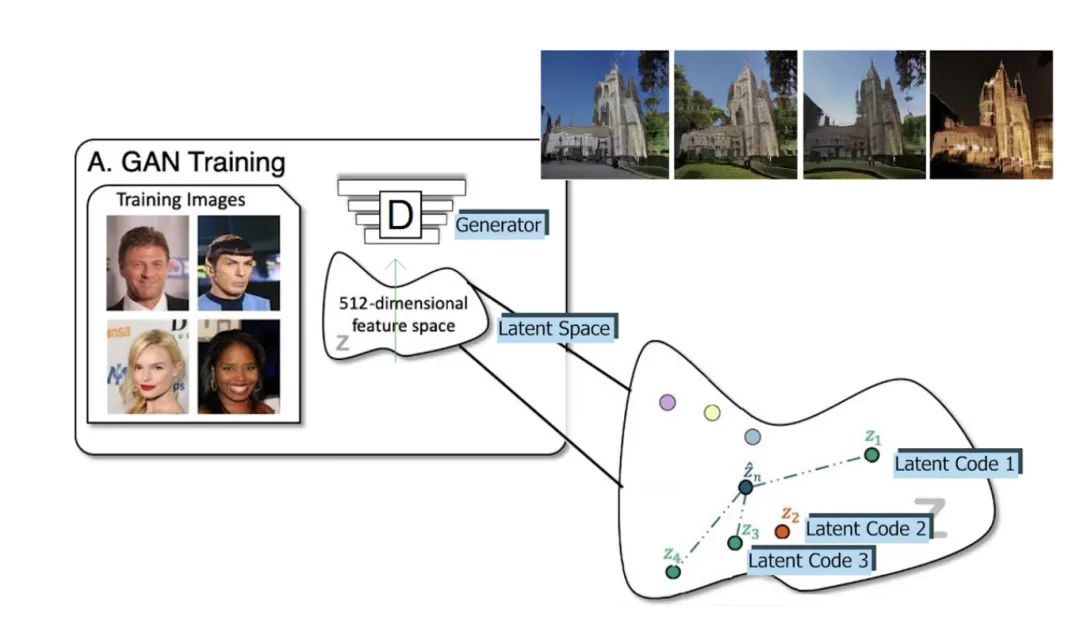

CVPR 2021 Best Paper Award: GIRAFFE — Controllable Image Generation [7]

使用修改后的 GAN 架构,他们可以在不影响背景或其他对象的情况下移动图像中的对象!

代码:https://github.com/autonomousvision/giraffe

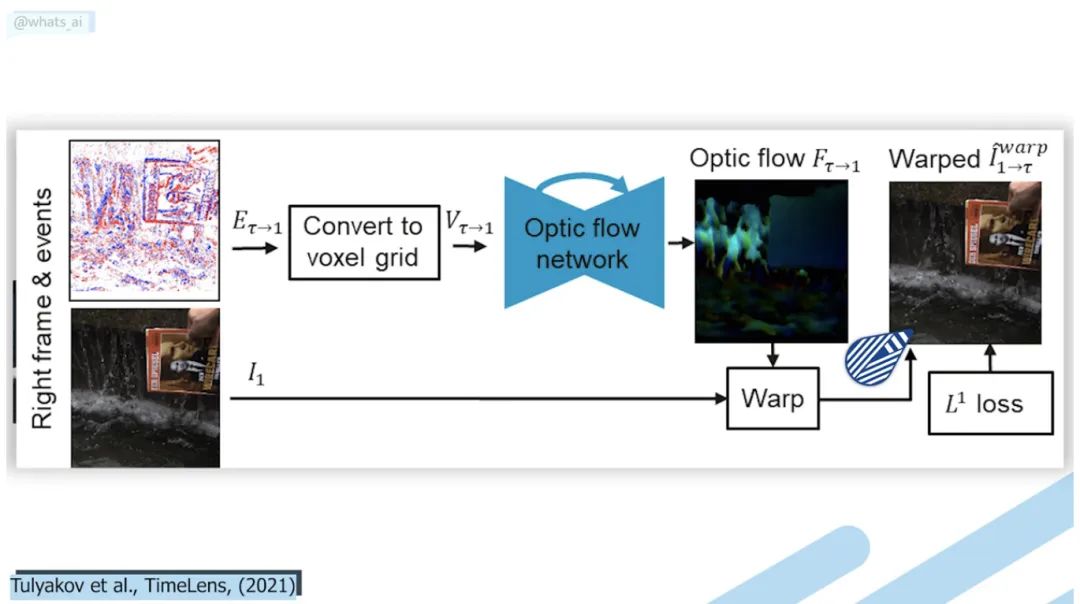

TimeLens: Event-based Video Frame Interpolation [8]

TimeLens 可以理解视频帧之间粒子的运动,用我们肉眼看不到的速度重建真正发生的事情。它达到了智能手机和其他机型无法达到的效果!

代码:https://github.com/uzh-rpg/rpg_timelens

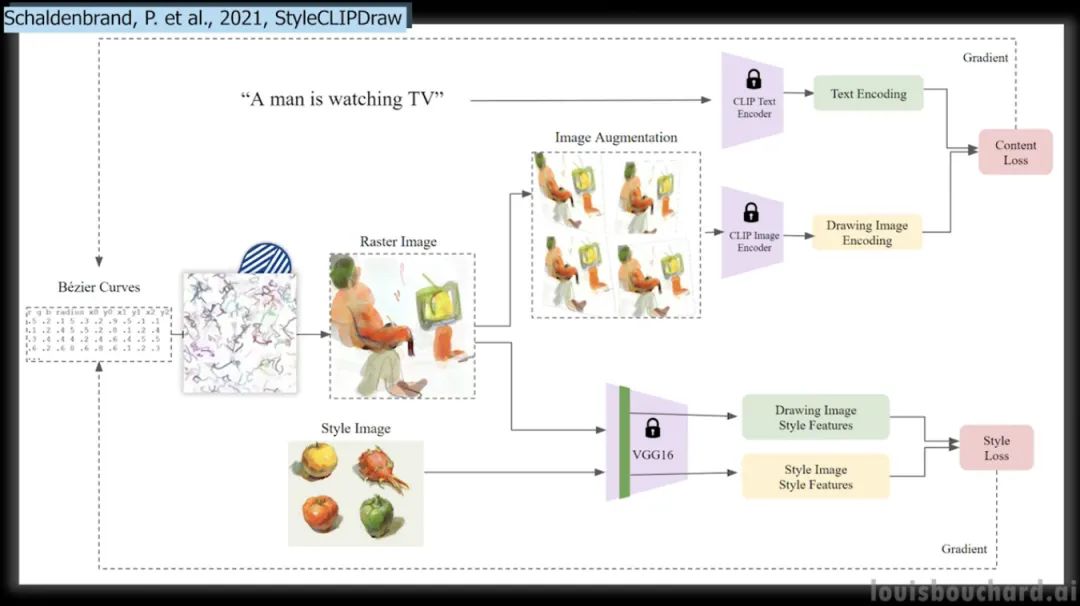

CLIPDraw: Coupling Content and Style in Text-to-Drawing Synthesis [9]

你有没有想过把照片的风格,比如左边这个很酷的绘画风格,应用到你选择的新照片上?这个模型能够做到,甚至可以仅从文本中实现这一点,并且还提供了可以立即尝试使用这种新方法及其适用于所有人的 Google Colab 。简单的拍一张你要复制的样式的图片,输入你要生成的文字,这个算法就会生成一张新的图片!结果非常令人印象深刻,特别它们可以由一行文本制成的!

DEMO:https://colab.research.google.com/github/kvfrans/clipdraw/blob/main/clipdraw.ipynb

https://colab.research.google.com/github/pschaldenbrand/StyleCLIPDraw/blob/master/Style_ClipDraw.ipynb

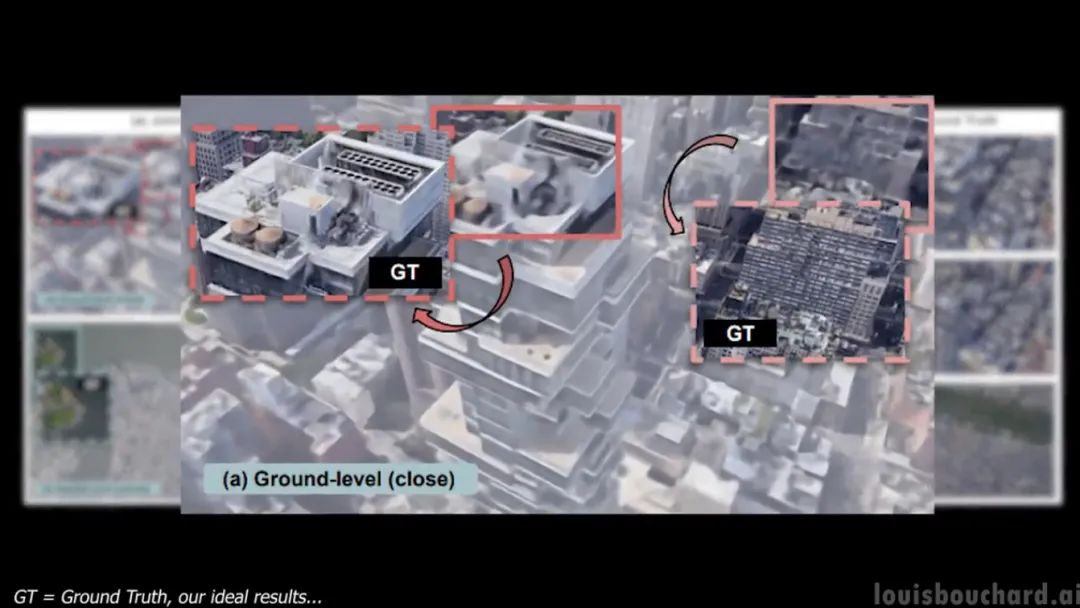

CityNeRF: Building NeRF at City Scale [10]

该模型称为 CityNeRF,是从 NeRF 发展而来的, NeRF 是最早使用辐射场和机器学习从图像构建 3D 模型的模型之一。但 NeRF 效率不高而且只适用于单一规模。在这里,CityNeRF 同时应用于卫星和地面图像,生成各种 3D 模型。简而言之他们将 NeRF 带入了城市规模。

代码:https://city-super.github.io/citynerf/

引用:

[1] A. Ramesh et al., Zero-shot text-to-image generation, 2021. arXiv:2102.12092

[2] Taming Transformers for High-Resolution Image Synthesis, Esser et al., 2020.

[3] Liu, Z. et al., 2021, “Swin Transformer: Hierarchical Vision Transformer using Shifted Windows”, arXiv preprint https://arxiv.org/abs/2103.14030v1[bonus] Yuille, A.L., and Liu, C., 2021. Deep nets: What have they ever done for vision?. International Journal of Computer Vision, 129(3), pp.781–802, https://arxiv.org/abs/1805.04025.

[4] Liu, A., Tucker, R., Jampani, V., Makadia, A., Snavely, N. and Kanazawa, A., 2020. Infinite Nature: Perpetual View Generation of Natural Scenes from a Single Image, https://arxiv.org/pdf/2012.09855.pdf

[5] Pandey et al., 2021, Total Relighting: Learning to Relight Portraits for Background Replacement, doi: 10.1145/3450626.3459872, https://augmentedperception.github.io/total_relighting/total_relighting_paper.pdf.

[6] Holynski, Aleksander, et al. “Animating Pictures with Eulerian Motion Fields.” Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2021.

[7] Michael Niemeyer and Andreas Geiger, (2021), “GIRAFFE: Representing Scenes as Compositional Generative Neural Feature Fields”, Published in CVPR 2021.

[8] Stepan Tulyakov, Daniel Gehrig, Stamatios Georgoulis, Julius Erbach, Mathias Gehrig, Yuanyou Li, Davide Scaramuzza, TimeLens: Event-based Video Frame Interpolation, IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Nashville, 2021, http://rpg.ifi.uzh.ch/docs/CVPR21_Gehrig.pdf

[9] a) CLIPDraw: exploring text-to-drawing synthesis through language-image encodersb) StyleCLIPDraw: Schaldenbrand, P., Liu, Z. and Oh, J., 2021. StyleCLIPDraw: Coupling Content and Style in Text-to-Drawing Synthesis.

[10] Xiangli, Y., Xu, L., Pan, X., Zhao, N., Rao, A., Theobalt, C., Dai, B. and Lin, D., 2021. CityNeRF: Building NeRF at City Scale.

本文作者:Louis Bouchard

3D视觉精品课程推荐:

3.彻底搞透视觉三维重建:原理剖析、代码讲解、及优化改进

4.国内首个面向工业级实战的点云处理课程

5.激光-视觉-IMU-GPS融合SLAM算法梳理和代码讲解

6.彻底搞懂视觉-惯性SLAM:基于VINS-Fusion正式开课啦

7.彻底搞懂基于LOAM框架的3D激光SLAM: 源码剖析到算法优化

8.彻底剖析室内、室外激光SLAM关键算法原理、代码和实战(cartographer+LOAM +LIO-SAM)

重磅!3DCVer-学术论文写作投稿 交流群已成立

扫码添加小助手微信,可申请加入3D视觉工坊-学术论文写作与投稿 微信交流群,旨在交流顶会、顶刊、SCI、EI等写作与投稿事宜。

同时也可申请加入我们的细分方向交流群,目前主要有3D视觉、CV&深度学习、SLAM、三维重建、点云后处理、自动驾驶、多传感器融合、CV入门、三维测量、VR/AR、3D人脸识别、医疗影像、缺陷检测、行人重识别、目标跟踪、视觉产品落地、视觉竞赛、车牌识别、硬件选型、学术交流、求职交流、ORB-SLAM系列源码交流、深度估计等微信群。

一定要备注:研究方向+学校/公司+昵称,例如:”3D视觉 + 上海交大 + 静静“。请按照格式备注,可快速被通过且邀请进群。原创投稿也请联系。

▲长按加微信群或投稿

▲长按关注公众号

▲长按关注公众号

3D视觉从入门到精通知识星球:针对3D视觉领域的视频课程(三维重建系列、三维点云系列、结构光系列、手眼标定、相机标定、激光/视觉SLAM、自动驾驶等)、知识点汇总、入门进阶学习路线、最新paper分享、疑问解答五个方面进行深耕,更有各类大厂的算法工程人员进行技术指导。与此同时,星球将联合知名企业发布3D视觉相关算法开发岗位以及项目对接信息,打造成集技术与就业为一体的铁杆粉丝聚集区,近4000星球成员为创造更好的AI世界共同进步,知识星球入口:

学习3D视觉核心技术,扫描查看介绍,3天内无条件退款

圈里有高质量教程资料、可答疑解惑、助你高效解决问题 觉得有用,麻烦给个赞和在看~