由于缺少规范化的数据集,训练一个像OpenAI一样的GPT模型通常很难。现在有了,它就是BookCorpus的"books3"数据集,一个包含196,640本书的txt数据集。

下载链接:https://the-eye.eu/public/AI/pile_preliminary_components/books3.tar.gz

但在下载这个37Gb的大文件前,我们先了解了解这个数据集。

BookCorpus

https://github.com/soskek/bookcorpus

BookCorpus是一个流行的大型文本语料库,适合在无人监督下学习句子的编码/解码器。但是,BookCorpus 目前已不再更新。

此存储库的数据来源包括smashwords的数据,是 BookCorpus 的原始来源。后续收集添加的句子可能有部分不同,但数量会更大更丰富。

最简单的调用方式是:

from datasets import load_datasetdataset = load_dataset("bookcorpus")

虽然bookcorpus已不再更新,但后续仍有人为该数据集丰富内容,更新信息。其中最突出的就是Shawn在今年9月贡献的book3语料库,每本书都以文本文件的形式单独存储。

Book3数据集

数据集的质量非常高,作者为了构建数据集,花了一周时间修缮了epub2txt脚本。

新脚本保证了:

正确保留结构,与目录非常匹配; 正确呈现数据表(默认情况下 html2txt 主要为表生成垃圾查找结果),

正确保留代码结构,使源代码和类似内容在视觉上保持一致,

将编号列表从"1\"转换为"1"。

通过"ftfy.fix_text()运用在全文上 (这是 OpenAI 对 GPT 的用途)运行全文,将Unicode的撇号替换为ascii编码的撇号;

将 Unicode 椭圆扩展到"..."(三个单独的 ascii 字符)。

book3数据集:

包含196,640本书籍

全部txt格式

链接更稳定,可直接下载。链接:https://the-eye.eu/public/AI/pile_preliminary_components/books3.tar.gz

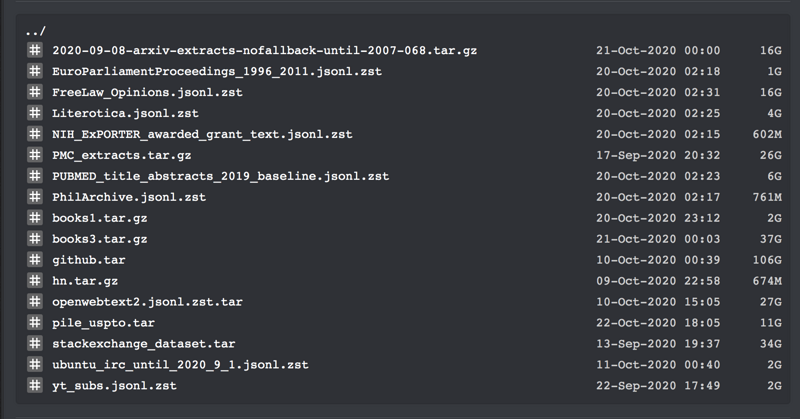

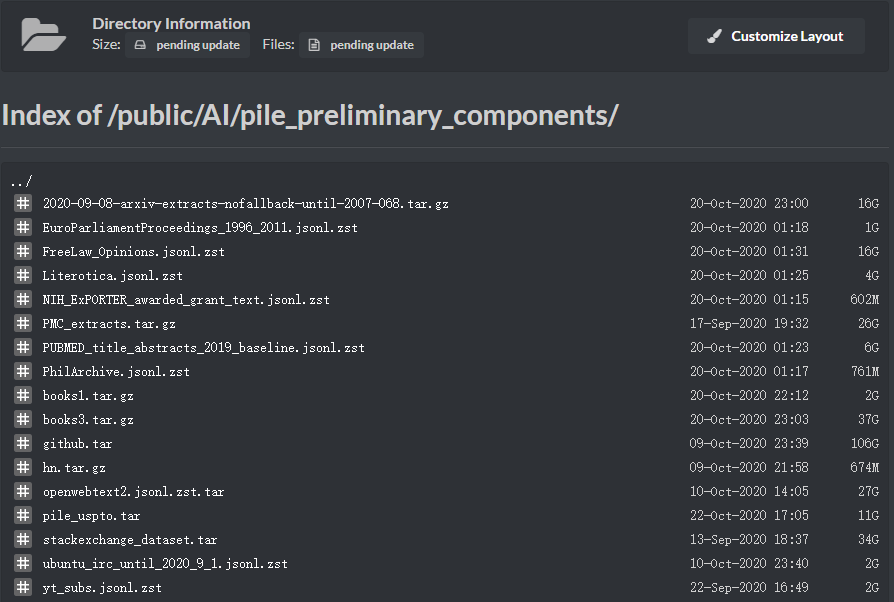

如果想要下载其他数据集,可以访问:

https://the-eye.eu/public/AI/pile_preliminary_components/

最后

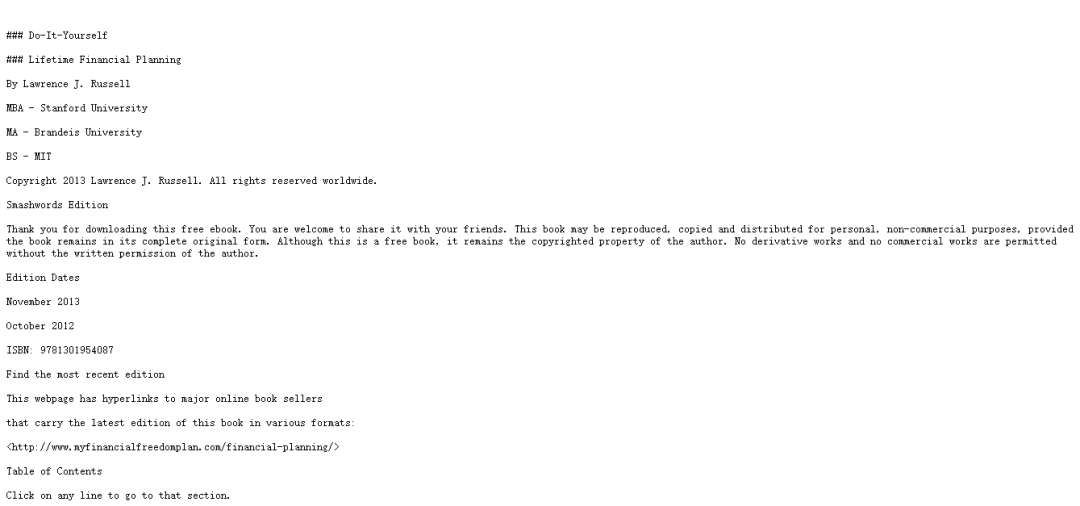

附上一个书籍的网页版样例:《Do It Yourself》

https://battle.shawwn.com/sdb/books1/books1/epubtxt/do-it-yourself-lifetime-financial-planning.epub.txt

参考:

[1]https://www.reddit.com/r/MachineLearning/comments/ji7y06/p_dataset_of_196640_books_in_plain_text_for/?utm_medium=android_app&utm_source=share

[2]https://github.com/soskek/bookcorpus/issues/27

[3]https://twitter.com/theshawwn/status/1320282149329784833

[4]https://github.com/soskek/bookcorpus

[5]https://huggingface.co/datasets/bookcorpus

- EOF -

往期精彩回顾 本站qq群851320808,加入微信群请扫码: