作者:杨夕

论文学习项目地址:https://github.com/km1994/nlp_paper_study

《NLP 百面百搭》地址:https://github.com/km1994/NLP-Interview-Notes

个人介绍:大佬们好,我叫杨夕,该项目主要是本人在研读顶会论文和复现经典论文过程中,所见、所思、所想、所闻,可能存在一些理解错误,希望大佬们多多指正。

NLP && 推荐学习群【人数满了,加微信 blqkm601 】

介绍:命名实体识别 (NER) 是各种 NLP 应用程序中的一项重要任务。

动机:在许多现实世界的场景中(例如,语音助手)经常引入新的命名实体类型,需要重新训练 NER 模型以支持这些新的实体类型。当存储限制或安全问题重新限制对该数据的访问时,为新实体类型重新 标注 原始训练数据可能成本高昂甚至不可能,并且随着类型数量的增加,为所有实体注释新数据集变得不切实际且容易出错.

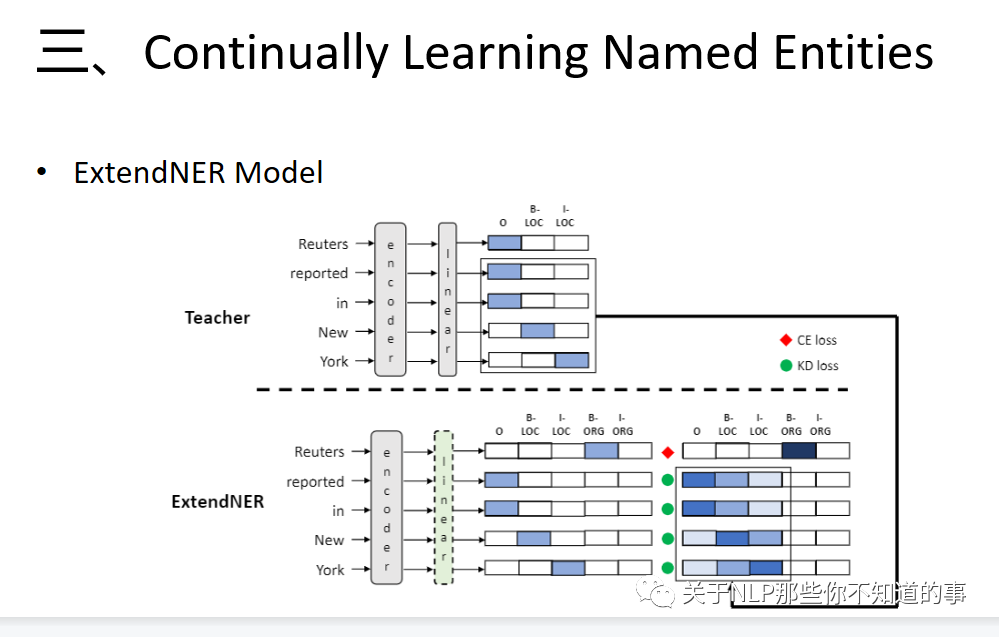

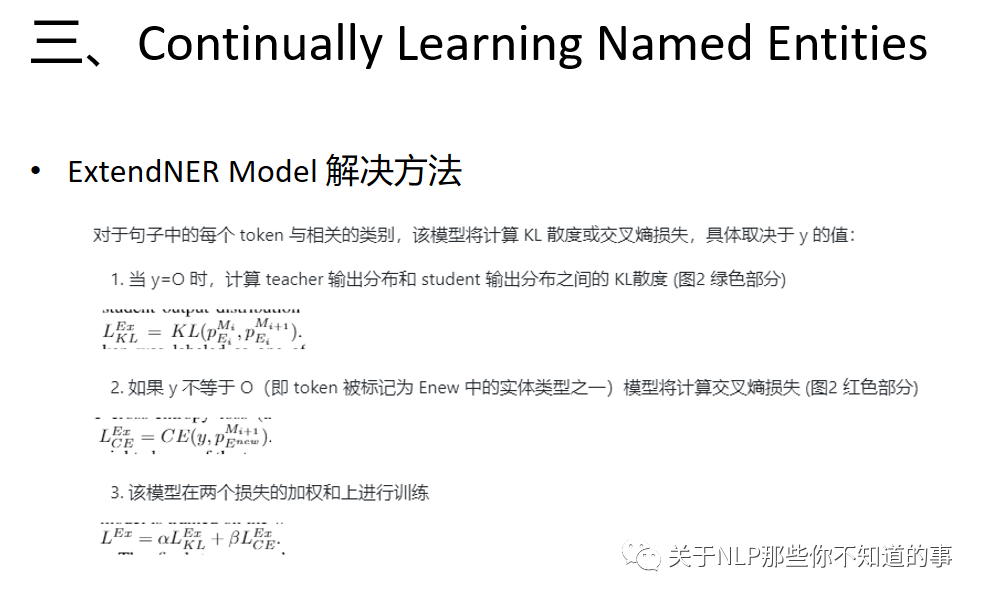

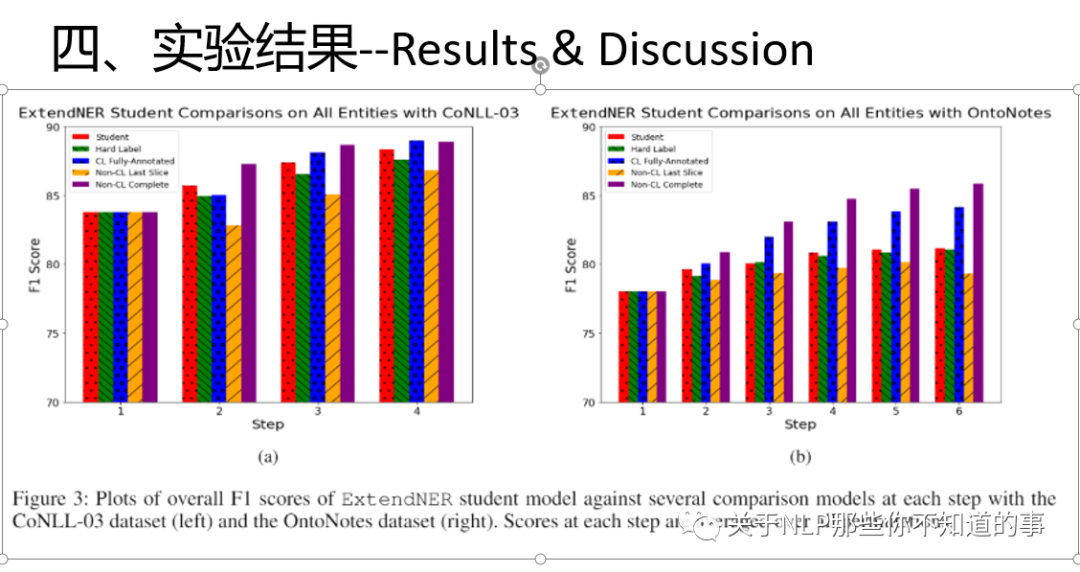

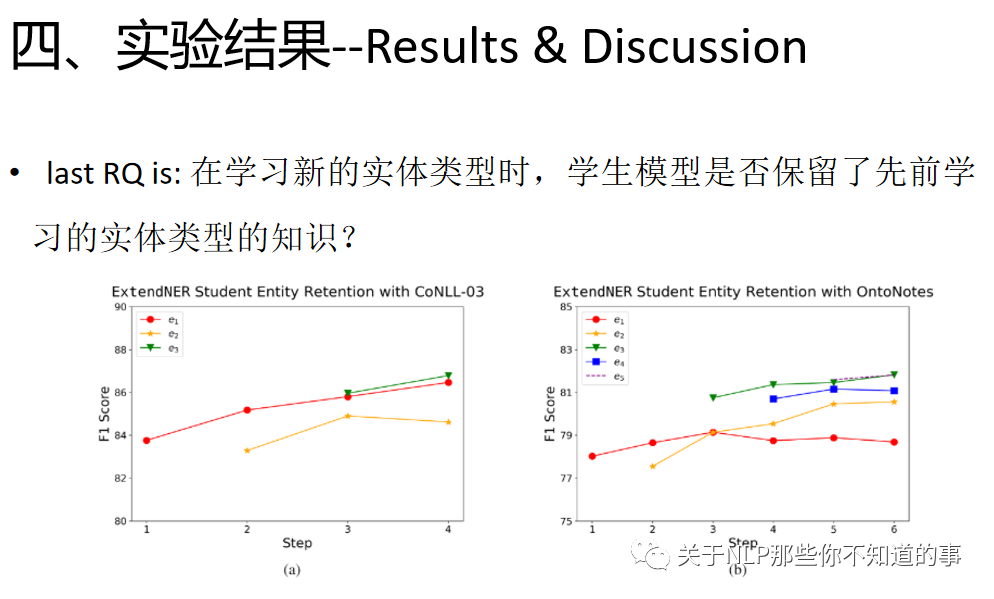

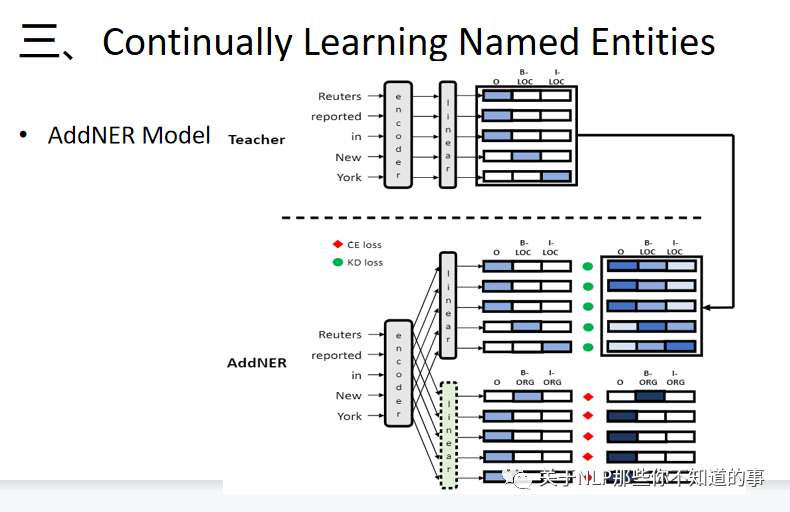

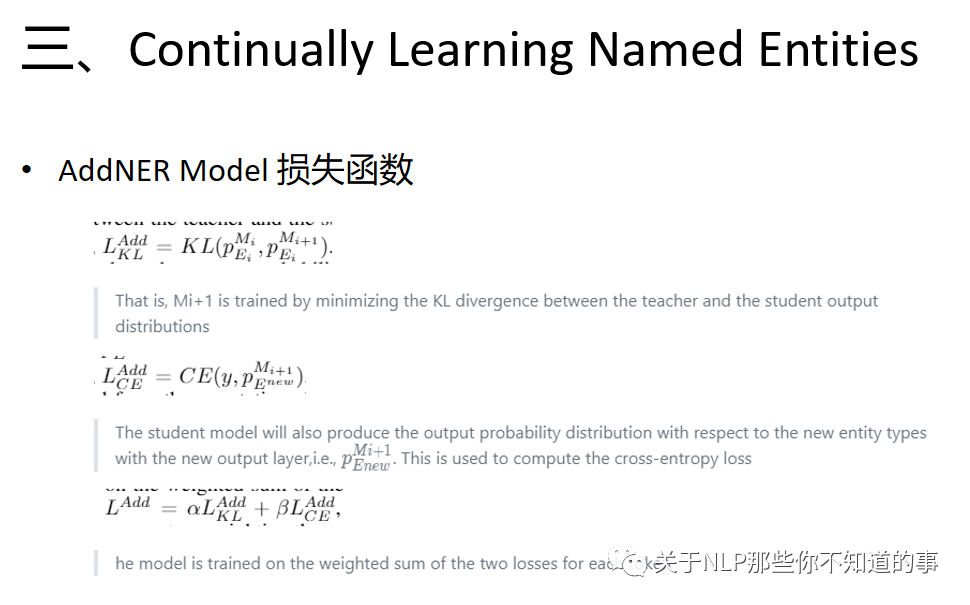

论文方法:引入了一种新颖的持续学习方法,它需要仅针对新的实体类型 标注 新的训练材料。为了保留模型先前学到的现有知识,我们利用知识蒸馏(KD)框架,其中现有的 NER 模型充当新 NER 模型(即学生)的老师,该模型通过以下方式学习新的实体类型使用新的训练材料并通过在这个新训练集上模仿教师的输出来保留旧实体的知识。

实验结果:这种方法允许学生模型“逐步”学习识别新的实体类型,而不会忘记以前学习的实体类型。我们还提供了与多个强基线的比较,以证明我们的方法在不断更新 NER 模型方面是优越的

、