作者:Patrycja Jenkner

本文约2300字,建议阅读8分钟

标签:对抗性攻击,神经网络

来源: neptune.ai

Henry Ansah

https://www.linkedin.com/in/henry-ansah-6a8b84167

快速梯度符号方法:

https://arxiv.org/abs/1412.6572

对抗性的攻击

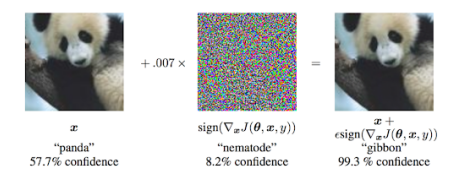

分类错误,在无需考虑预测分类的情况下诱导模型做出错误的预测;

源/目标分类错误,向图像中添加噪声,迫使模型预测特定的分类。

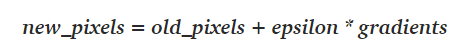

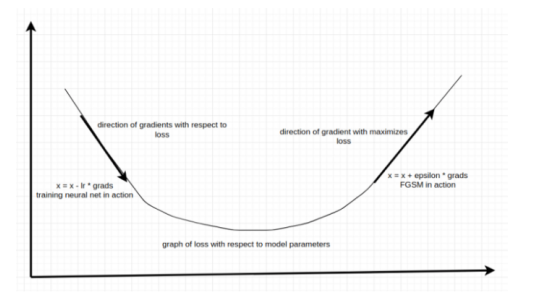

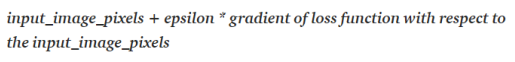

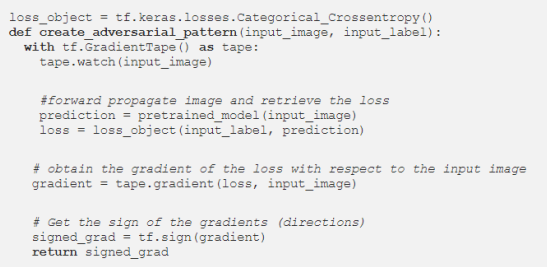

快速梯度符号法详解

new_weights = old_weights — learning_rate * gradients

神经网络前向传播图像;

计算出损失;

将梯度反向传播给图像;

在损失值最大的方向上微移图像的像素。

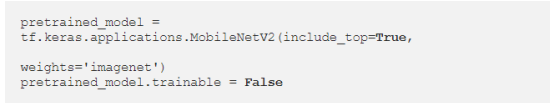

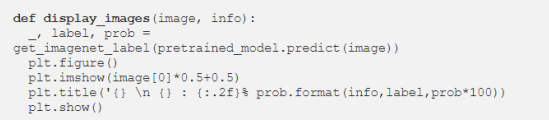

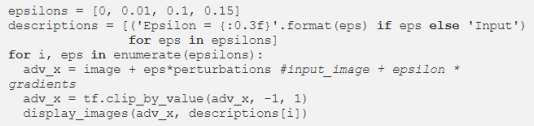

代码

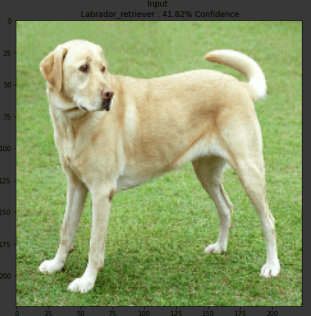

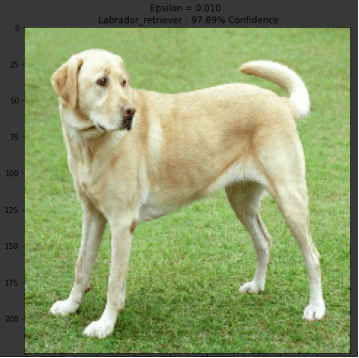

我可以得出以下结果:

下一步

Survey on Attacks:

https://arxiv.org/abs/1810.00069

译者简介

陈之炎,北京交通大学通信与控制工程专业毕业,获得工学硕士学位,历任长城计算机软件与系统公司工程师,大唐微电子公司工程师,现任北京吾译超群科技有限公司技术支持。目前从事智能化翻译教学系统的运营和维护,在人工智能深度学习和自然语言处理(NLP)方面积累有一定的经验。业余时间喜爱翻译创作,翻译作品主要有:IEC-ISO 7816、伊拉克石油工程项目、新财税主义宣言等等,其中中译英作品“新财税主义宣言”在GLOBAL TIMES正式发表。能够利用业余时间加入到THU 数据派平台的翻译志愿者小组,希望能和大家一起交流分享,共同进步

翻译组招募信息

工作内容:需要一颗细致的心,将选取好的外文文章翻译成流畅的中文。如果你是数据科学/统计学/计算机类的留学生,或在海外从事相关工作,或对自己外语水平有信心的朋友欢迎加入翻译小组。

你能得到:定期的翻译培训提高志愿者的翻译水平,提高对于数据科学前沿的认知,海外的朋友可以和国内技术应用发展保持联系,THU数据派产学研的背景为志愿者带来好的发展机遇。

其他福利:来自于名企的数据科学工作者,北大清华以及海外等名校学生他们都将成为你在翻译小组的伙伴。

点击文末“阅读原文”加入数据派团队~

转载须知

如需转载,请在开篇显著位置注明作者和出处(转自:数据派ID:DatapiTHU),并在文章结尾放置数据派醒目二维码。有原创标识文章,请发送【文章名称-待授权公众号名称及ID】至联系邮箱,申请白名单授权并按要求编辑。

发布后请将链接反馈至联系邮箱(见下方)。未经许可的转载以及改编者,我们将依法追究其法律责任。

点击“阅读原文”拥抱组织