知其然知其所以然。想要深耕深度学习,背后的数学原理还需要掌握。这就有一本值得推荐的新书。

今天,reddit 上的一个帖子可谓热度爆表,到目前为止,热度还在持续上升,在不到一天的时间里,引来大量网友的讨论。该帖子的主要内容为「深度学习中的现代数学」。由帖子内容我们可以粗略得出,这是一本介绍深度学习中关于现代数学的书籍。

在深度学习领域,数学知识至关重要,想要深入了解深度学习背后的数学知识、做更前沿更基础的研究,这背后离不开数学知识的支撑。该书是在线免费的,书中描述了深度学习数学分析的新领域。这个领域出现在一系列研究问题中,但在经典的学习理论框架内都没有得到解决。这些问题涉及:超参数化神经网络突出的泛化能力;深度在深度架构中扮演的角色;维度灾难的明显缺失;尽管遇到的问题是非凸性、但取得令人惊讶的成功的优化性能;了解哪些特征是可以学习的;为什么深度架构在物理问题上表现得异常出色;架构的哪些方面以何种方式影响学习任务的行为。书籍中给出了现代数学方法的概览,以及上述问题部分答案的概述。对于所选择的方法,书中给出了主要解决思想的更多细节。

书籍地址:https://arxiv.org/pdf/2105.04026.pdf

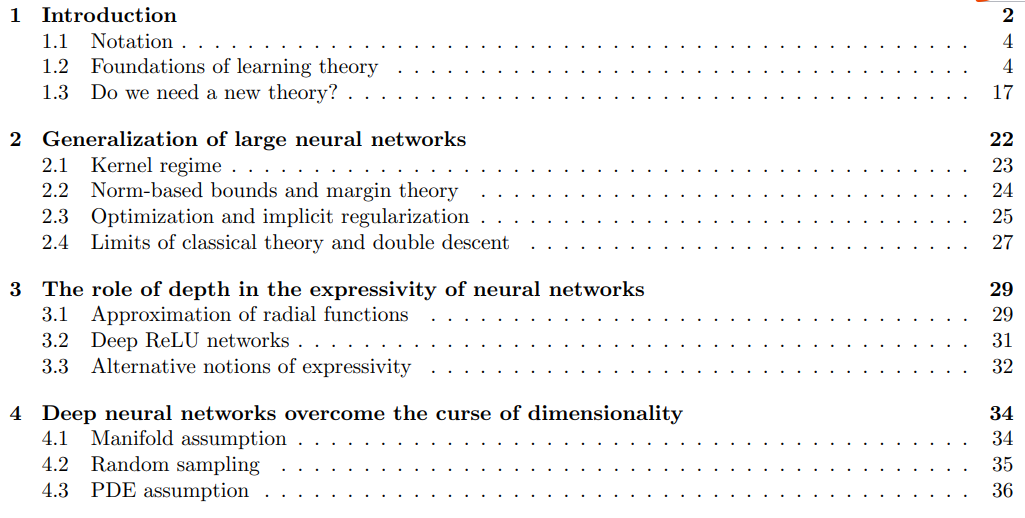

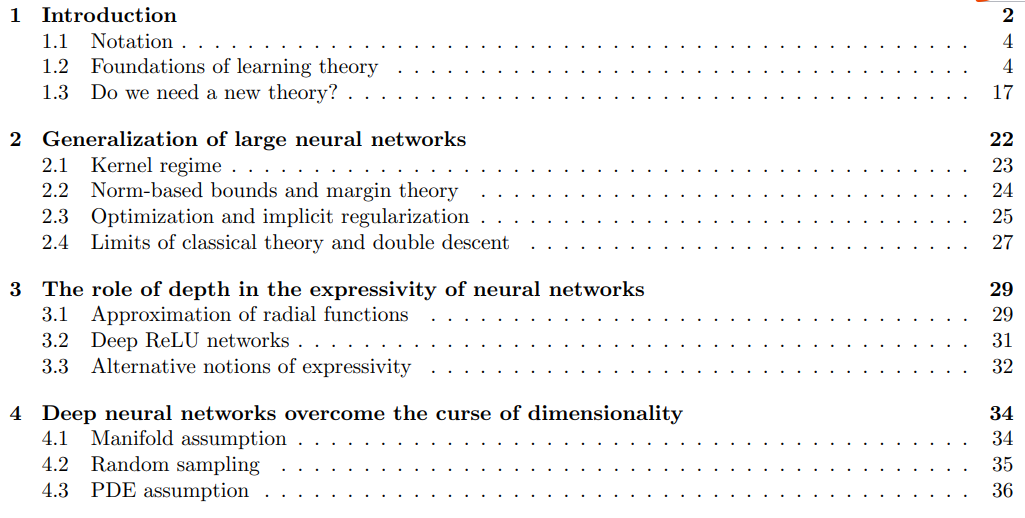

第一章:引言部分,主要介绍了该书定义的一些符号表示、理论基础、是否需要新的理论解决还未解决的问题;

第二章:大型神经网络的泛化能力,主要包括核(Kernel)相关问题、基于范数的边界和边际理论、优化和隐式正则化、经典理论的局限性;

第三章:深度在神经网络表达中的作用,主要包括径向函数逼近、深度 ReLU 网络、表达性的可替代概念;

第四章:深度神经网络克服了维数的诅咒,主要包括流形假设、随机抽样、PDE 假设;

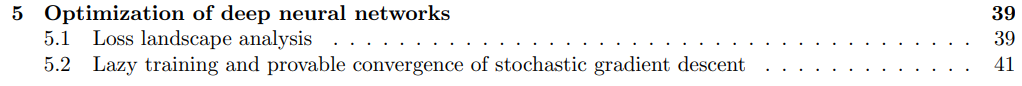

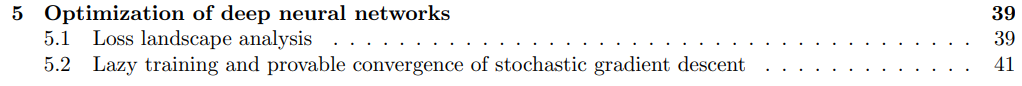

第五章:深度神经网络的优化,主要包括损失分析、随机梯度下降的惰性训练和可证明的收敛;

第六章:特殊架构的影响,主要包括卷积神经网络、残差神经网络、 Framelets 和 U-Nets 、批归一化、稀疏神经网络与剪枝、递归神经网络;

第七章:深度神经网络学习的特征描述,主要包括不变性与散射变换、分层的稀疏表示;

第八章:自然科学的有效性,主要包括深度神经网络遇到逆问题、基于 PDF 模型。

个人主页:https://homepage.univie.ac.at/julius.berner/该书作者之一 Julius Berner 曾就读于维也纳大学(BSc,MSc),攻读应用数学和科学计算专业,对机器学习和神经网络特别感兴趣。目前,Julius Berner 正在 Philipp Grohs 博士的指导下在维也纳大学攻读博士学位,其研究重点是基于深度学习方法的数学分析,这些方法是在逼近理论、统计学习理论和优化方法的交叉处进行的。除此以外,书籍作者还包括来自维也纳大学的 Philipp Grohs 及 Philipp Petersen 等人。这本书籍引起了广大网友的讨论。有网友表示:「这是一项非常棒的工作!我经常有『我真的了解我在做什么吗?』的感觉。感谢你们把深度学习和数学结合起来,该书出版时,我会订购。」

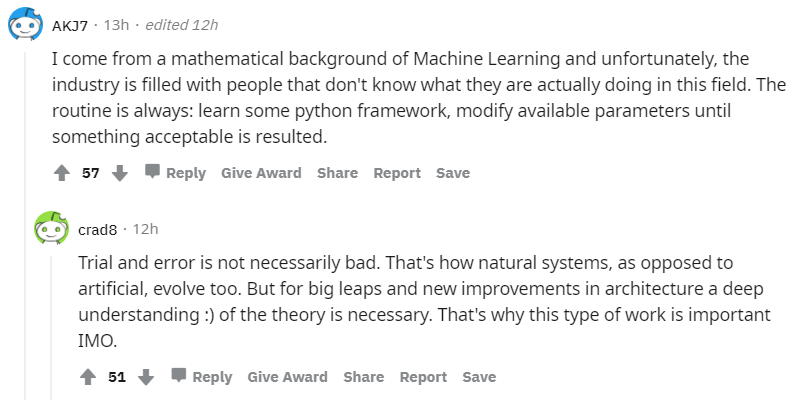

还有网友表示:「我在机器学习领域且具有数学背景,但不幸的是,在该领域中,许多公司的员工不知道自己在干什么。工作流程基本上是:学习一些 Python 基本框架,然后就是修改参数,直到产生可接受的结果。」

对此,有人表示「反复试验不一定是坏事。这就是自然系统(而不是人工系统)进化的方式。但是,对于架构上的飞跃和新改进,必须对该理论有深刻的理解。」对于从事深度学习的研究者来说,或许这本书能帮到你。https://www.reddit.com/r/MachineLearning/comments/najnjg/r_the_modern_mathematics_of_deep_learning/往期精彩:

【原创首发】机器学习公式推导与代码实现30讲.pdf

【原创首发】深度学习语义分割理论与实战指南.pdf

谈中小企业算法岗面试

算法工程师研发技能表

真正想做算法的,不要害怕内卷

算法工程师的日常,一定不能脱离产业实践

技术学习不能眼高手低

技术人要学会自我营销

做人不能过拟合

求个在看