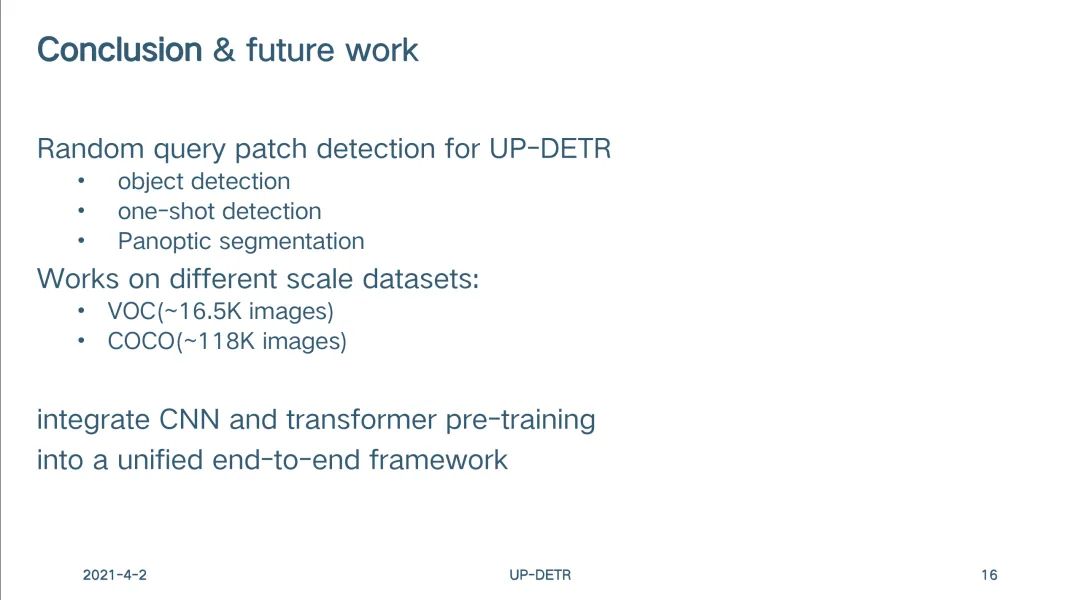

极市沙龙回顾|CVPR2021-戴志港:UP-DETR,针对目标检测的无监督预训练Transformer

作者信息

https://arxiv.org/pdf/2011.09094

https://github.com/dddzg/up-detr

完整报告

-

背景介绍 -

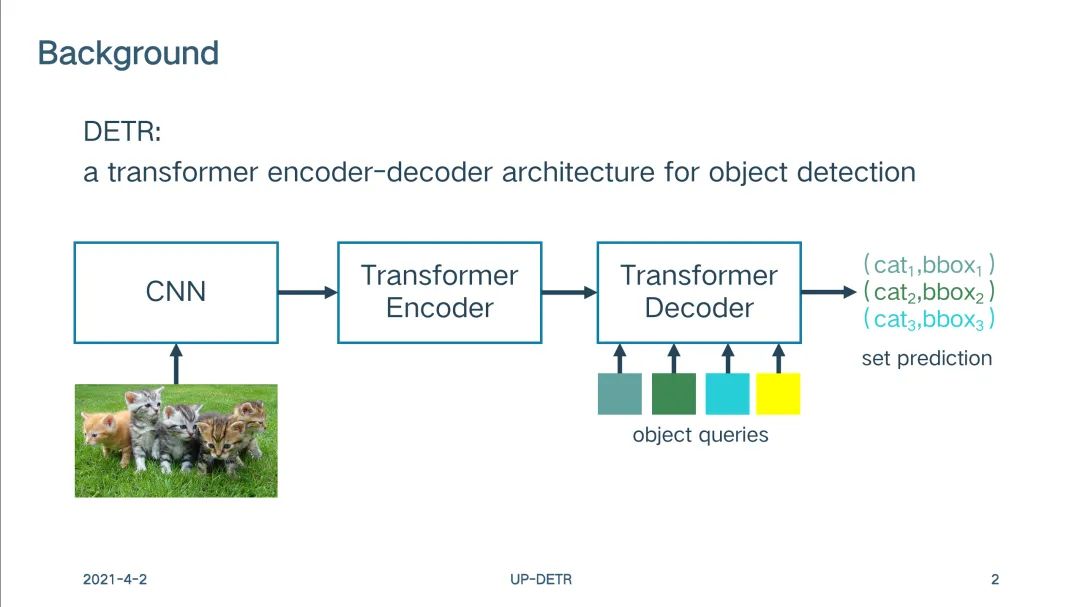

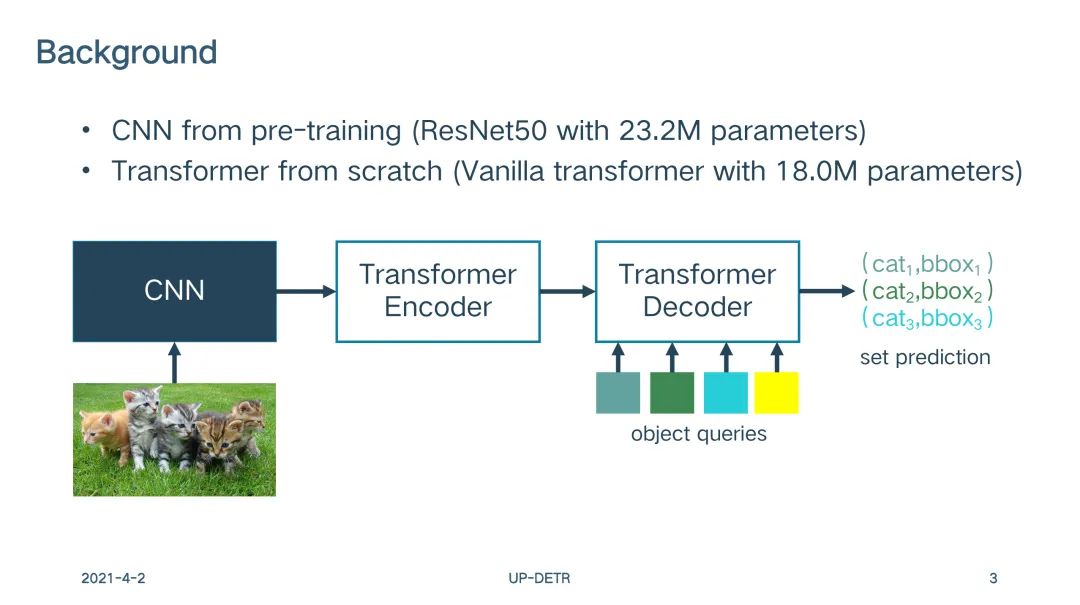

DETR:用于目标检测的Tranformer编码器-解码器架构 -

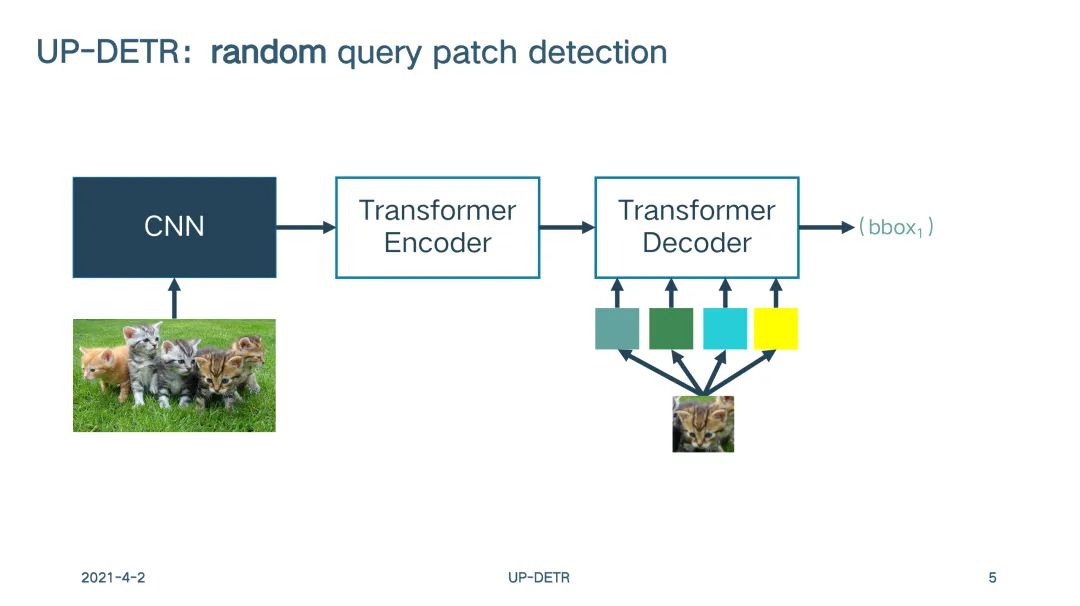

无监督预训练CNN与在Tranformer预训练的结合

-

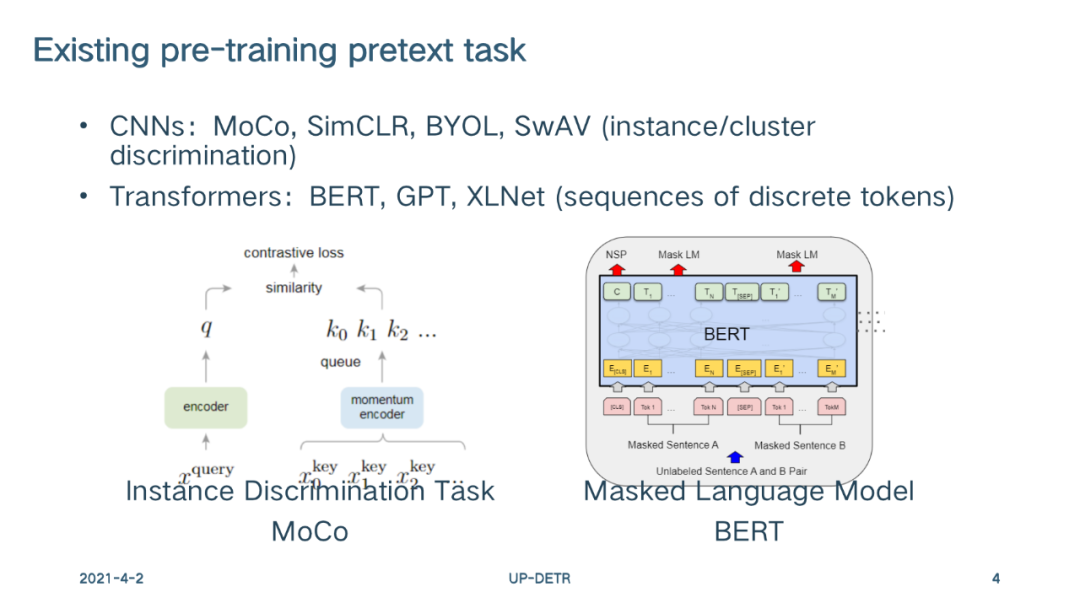

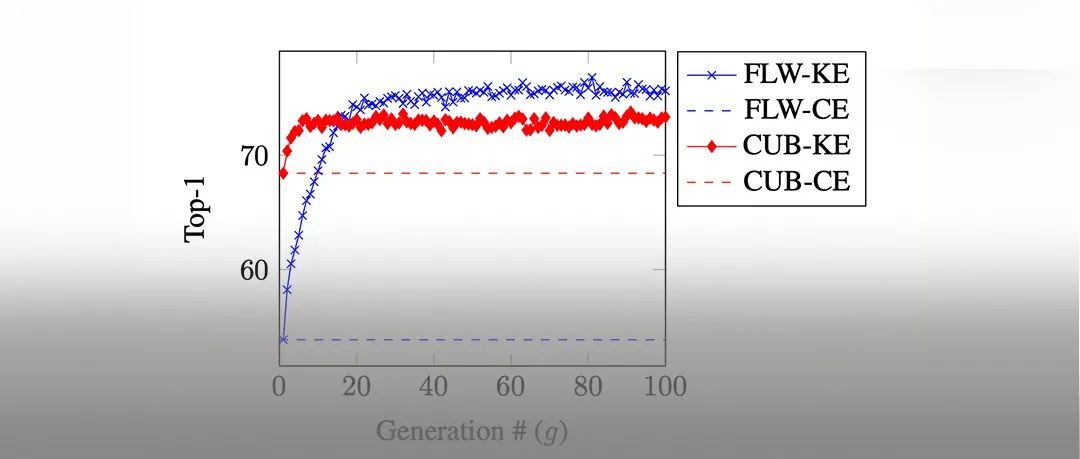

无监督预训练的关键:设计pretext任务。由于现有的CNN与Transformer方法并不适用于目标检测任务

-

本文的方法

-

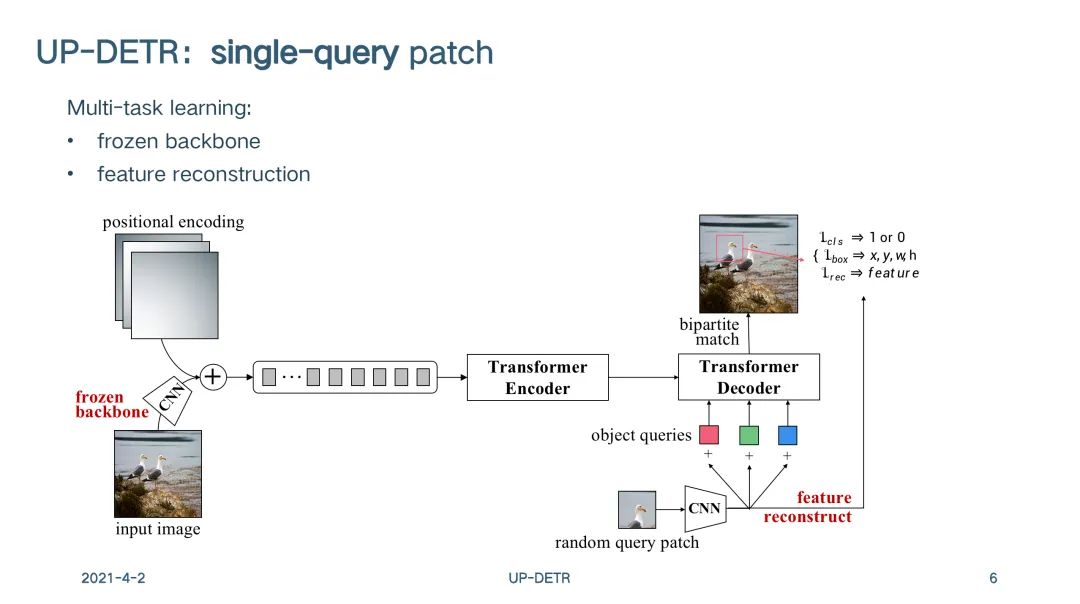

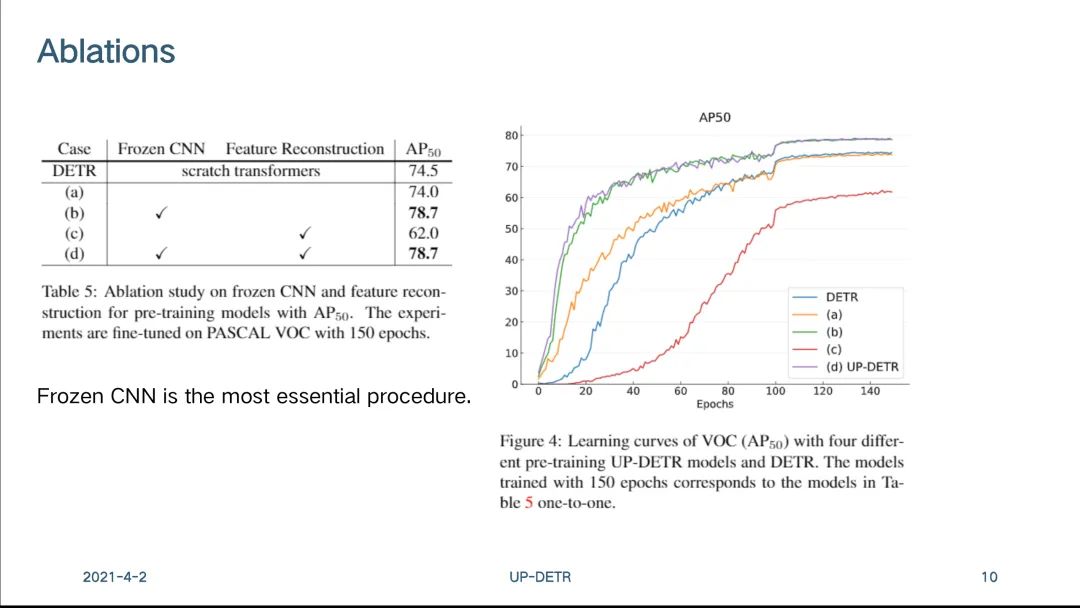

针对multi-task learning问题:

-

固定预训练好的CNN权重,新增patch feature reconstruction分支 -

使经过Transformer的特征能保持和经过CNN后的特征一致的分类判别性

-

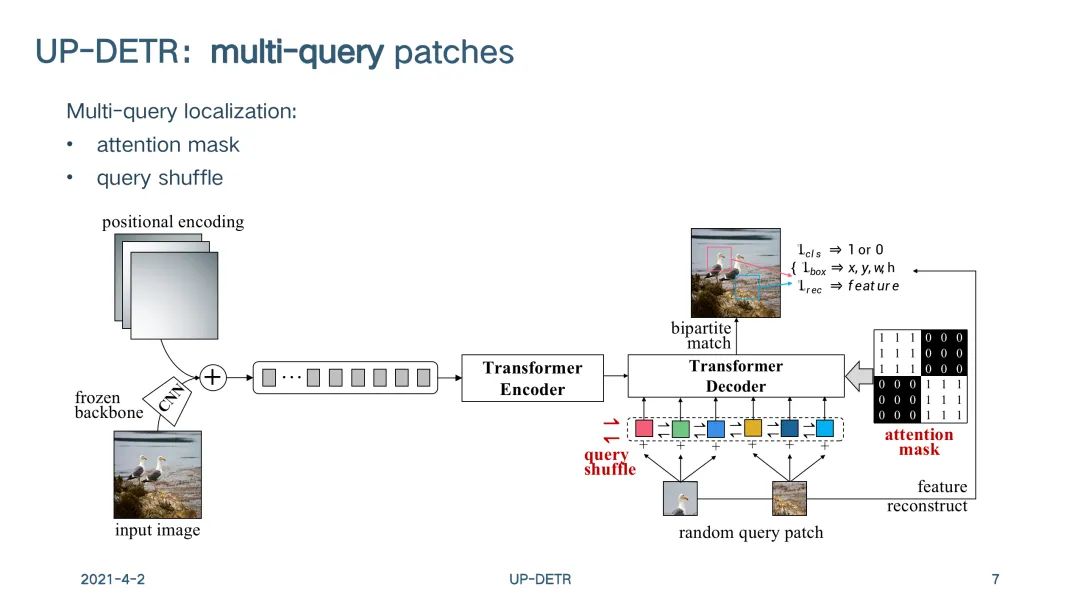

针对multi-query localization问题: -

随机设置M个query patch,并分配至100个embedding -

提出了一个放在解码器上的attention mask,以确保query之间框的预测独立 -

提出了object query shuffle,以确保embedding和query patch的随机性

-

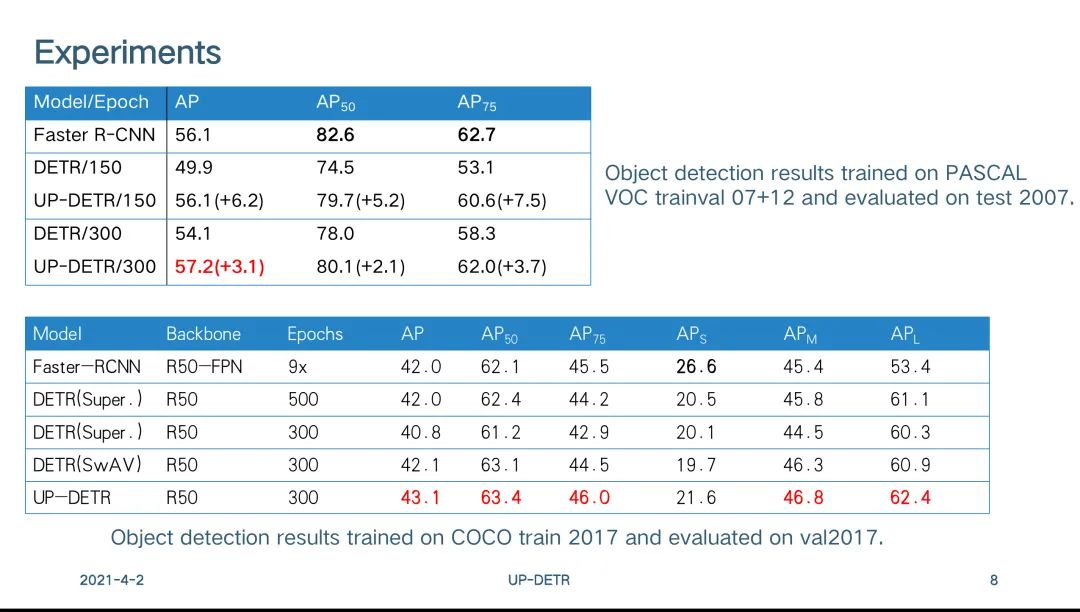

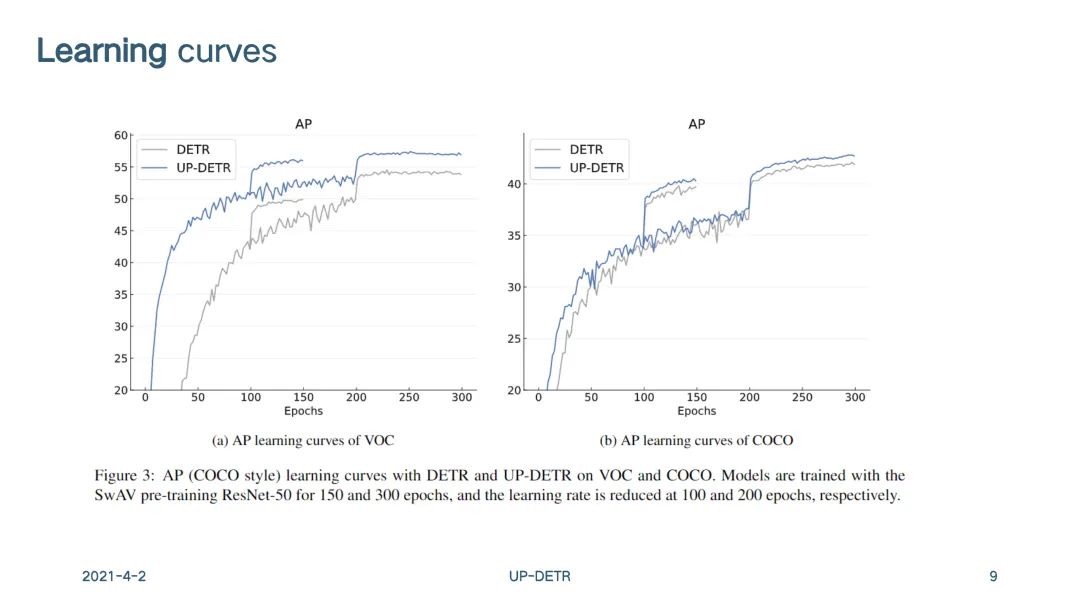

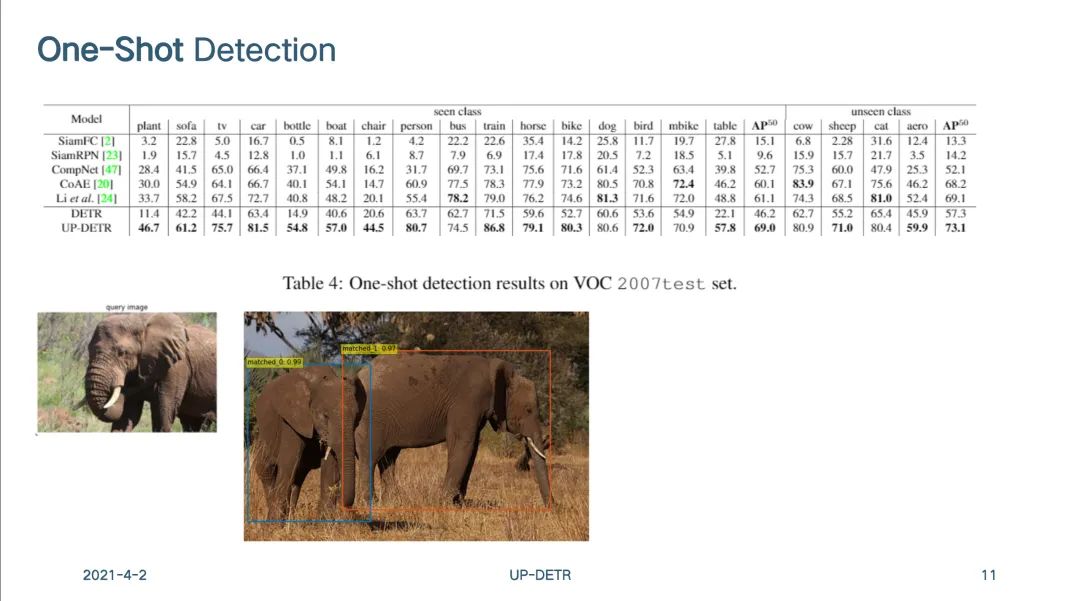

实验 -

在ImageNet上无监督预训练后,UP-DETR在VOC和COCO上都取得更快的收敛和更高的精度

-

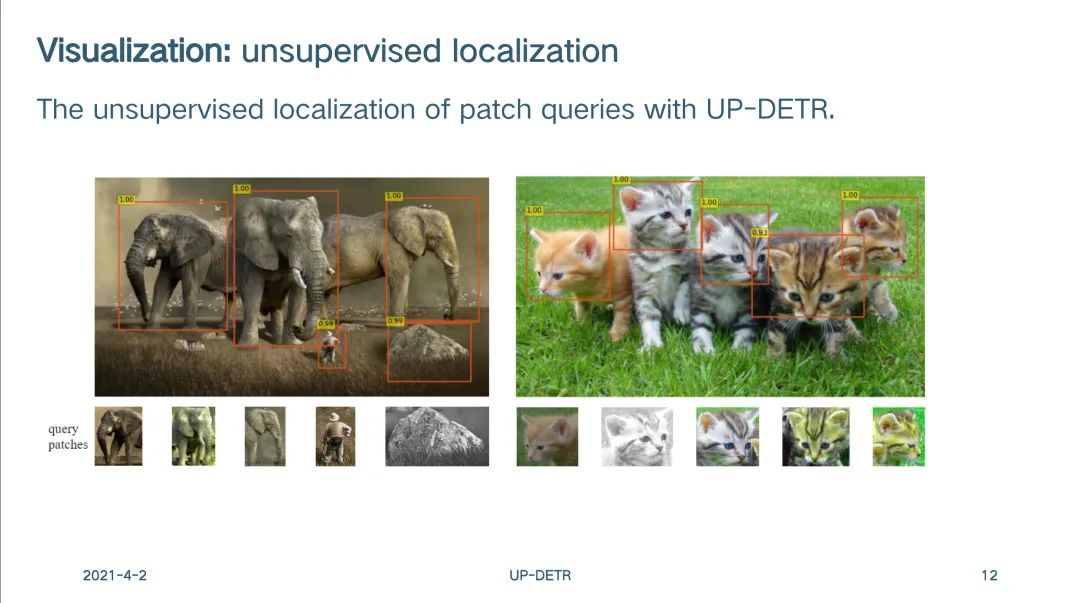

可视化:无监督定位

-

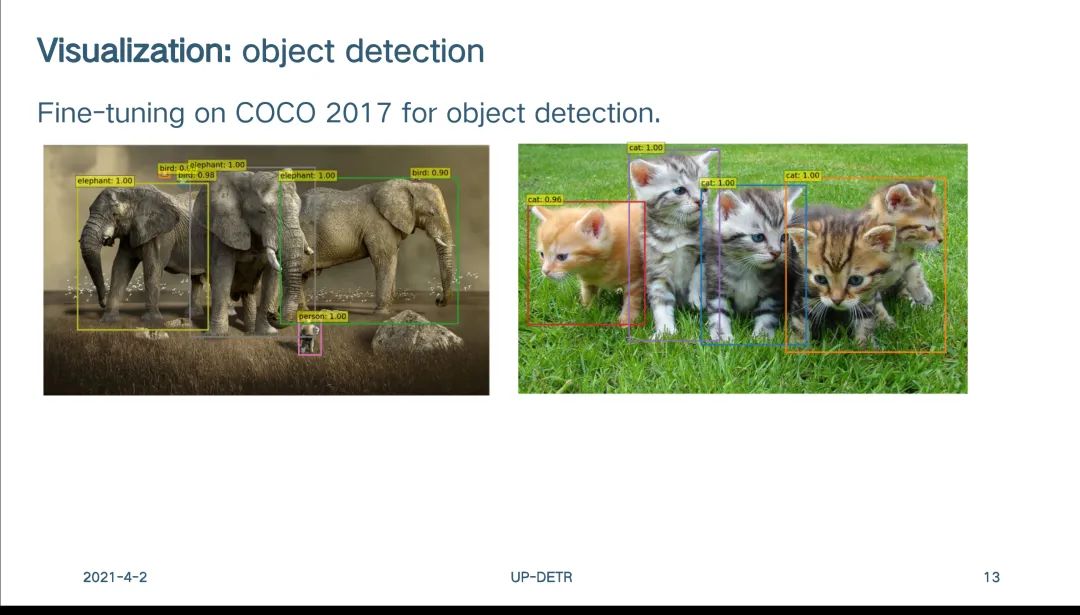

可视化:目标检测

-

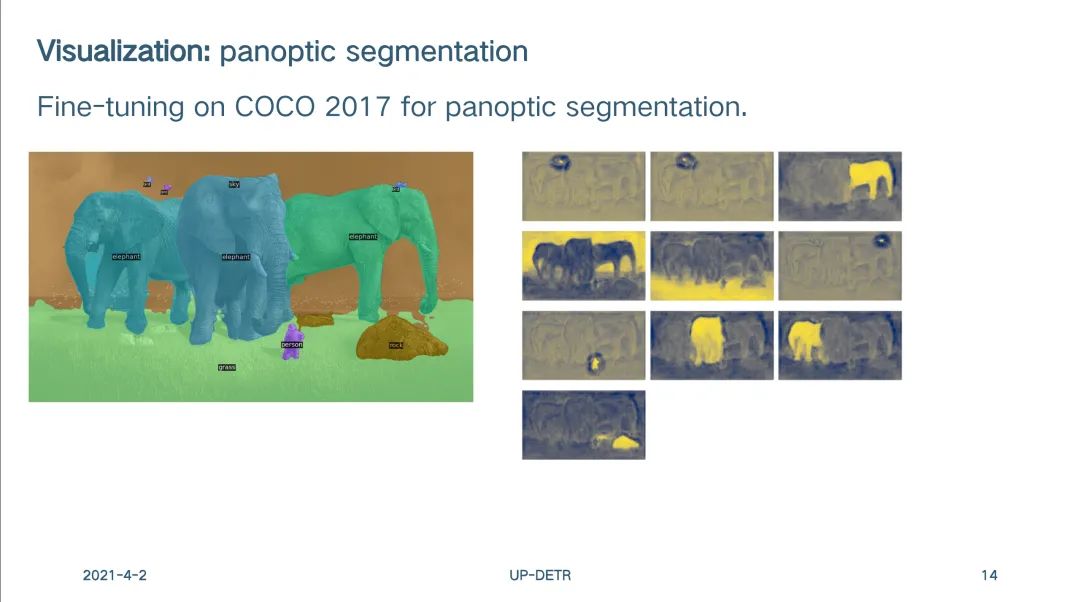

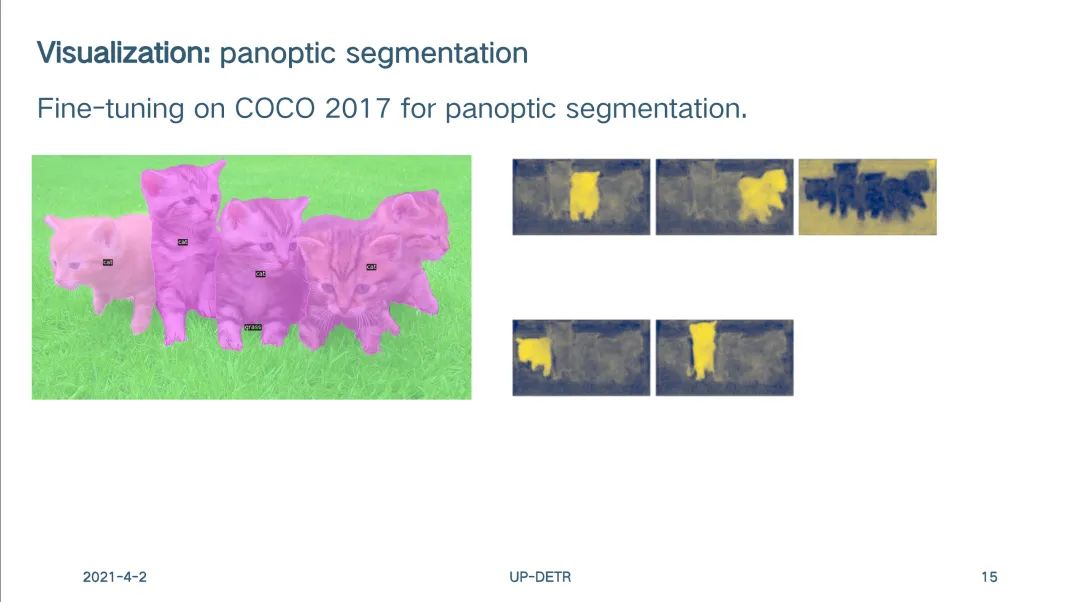

可视化:全景分割

现场照片

# 极市线下沙龙

CVPR2021论文研讨会

。

2021 · 3月27日

深圳是今年极市线下沙龙的第一站,但其他城市的小伙伴不要着急,可以在下方评论区留言你期待的极市沙龙举办地点,我们的下一站说不定就会在那儿哦~

推荐阅读

2021-03-31

2021-03-27

2021-03-29

# 极市原创作者激励计划 #

评论