解决机器学习最大弊病?马普所联合Google再探「因果学习」

新智元

共 4119字,需浏览 9分钟

· 2021-04-06

新智元报道

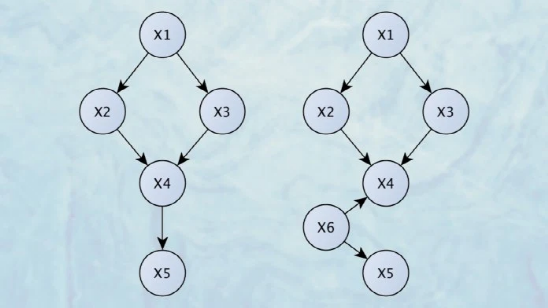

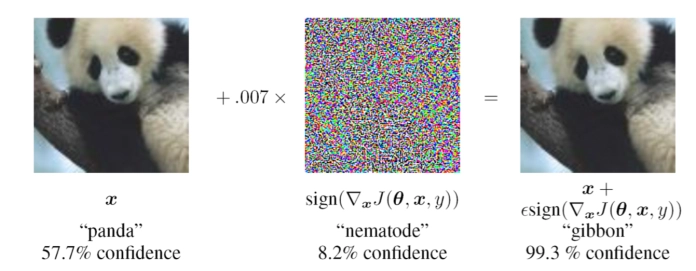

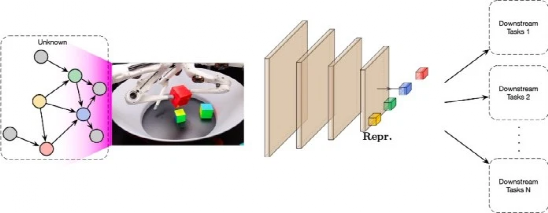

【新智元导读】对于机器学习算法来说,因果关系的推理仍然是一个大的挑战。近日,在一篇题为「因果表示学习「的文章中, 来自马普所、蒙特利尔研究所和Google Research的研究人员讨论了缺乏因果表示所带来的挑战,并提供了创建可以学习因果表示AI系统的方向。

评论

互联网晚报 | 大麦网已退款凤凰传奇演唱会“柱子票”;钟薛高再成被执行人;iPhone 16或取消实体音量键和电源键

大麦网回应凤凰传奇演唱会买到“柱子票”:已退票退款据报道,凤凰传奇2024巡回演唱会常州站演出结束的第二天,有网友称自己在大麦网买到“柱子票”,因为观看效果不佳,要求退款被拒。23日,记者从涉事网友处了解到,大麦方面给出了退款建议,但被其拒绝,“我希望平台退款加赔偿,并重视屡次出现的‘柱子票’问题。

产品刘

0

字节面试:如何解决MQ消息积压问题?

面试题大全:www.javacn.siteMQ(Message Queue)消息积压问题指的是在消息队列中累积了大量未处理的消息,导致消息队列中的消息积压严重,超出系统处理能力,影响系统性能和稳定性的现象。1.消息积压是哪个环节的问题?MQ 执行有三大阶段:消息生产阶段。消息存储阶段。消息消费阶段。

Java中文社群

0

特斯拉中国Model Y、S、X全系降价;盒马否认侯毅张勇出价20亿美元联手买下盒马;瑞幸回应“不招聘上海人”

特斯拉中国Model Y、S、X全系降价特斯拉中国Model Y售价降至24.99万元人民币,MODEL Y长续航版售价降至29.09万元人民币。特斯拉中国 MODEL Y高性能版售价降至35.49万元人民币。特斯拉中国MODEL S售价降至68.49万元人民币。特斯拉中国 MODEL S PLAI

亿欧网

0

新能源汽车季度观察2024年Q1 | 探舆论场

2024年,新能源车企“卷”新赛季。一季度,比亚迪、问界销量遥遥领先;小米入局汽车行业。此外,李斌直播首秀;极氪车展事故等引发较多关注。知微报研《新能源汽车季报》从市场格局、行业态势及热点观察三个方向,阐述该季度中新能源汽车行业的发展动向,为品牌的营销和公关工作提供舆情观察及建议。完整版报告可扫码添

知微数据

0

乐普心安宝及心电图机,助力安康市搭建“心电一张网”,打通全域“生命线”!

为持续推动胸痛中心建设,助力全民健康,全面提升心血管疾病等急危重症救治能力水平。4月20日,由安康市卫健委主办、安康市中医医院承办的“第七届心血管汉江学术会议暨安康市胸痛中心大会”在高新国际会议中心顺利举行。市人大常委会主任王彪、市政协副主席唐纹、市政府党组成员刘英华等领导亲临现场,受邀参会的中国科

乐普医疗AI

0

python读取多个excel表多个sheet后映射匹配再分组计算、纵向拼接

大家好,我是飞奔的蜗牛ing。一、前言前几天在一个客户给到一单数据处理的 问题,需求是这样的:1.表“aa2020”中2020年数据需要按季度分成四个表。(1-3月、4-6月、7-9月、10-12月)2.表“2020年一季度”代表2020年一季度客户所对应的管理档位,需要把表中的档位导入附表“aa2

IT共享之家

0

周鸿祎:雷军说小米SU7不适合我,等小米做SUV时再推荐

360公司创始人周鸿祎在互联网30周年座谈会上向雷军提出想要体验小米SU7的请求,但被雷军婉拒。雷军给出的理由是,他仔细研究了周鸿祎的选车标准,发现周鸿祎不会开车,只坐后座,而小米SU7是为追求驾驶乐趣的用户设计的,因此不适合周鸿祎。雷军还表示,等到小米推出SUV版本时,再推荐给周鸿祎。目前已知明确

Python涨薪研究所

0

文末送书 | 大模型时代下如何学习云原生

《containerd 原理剖析与实战》新书内购中,点击阅读原文,限时 69.9 元购买。文末免费赠书大模型与云原生近年来,大语言模型的热度可谓是愈发高涨,尤其是今年年初 Sora 的出现,更是让全球再次看到了AIGC 的巨大威力。Sora 生成实例视频---几头巨大的长毛猛犸踏着积雪的草地而来在当

云原生实验室

509