来源丨https://zhuanlan.zhihu.com/p/235533342本文整理了Focal Loss、IOU Loss、GIOU Loss等的多种loss的相关信息,包括公式表示、优缺点和相关论文等方面的内容。

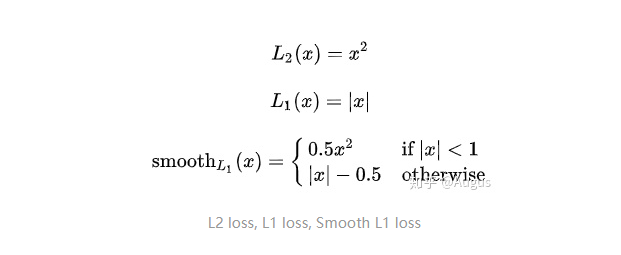

L2, L1, smooth L1

smooth L1 loss 相对于 L2 loss的优点:当预测框与 ground truth 差别过大时,梯度值不至于过大;当预测框与 ground truth 差别很小时,梯度值足够小。Focal Loss

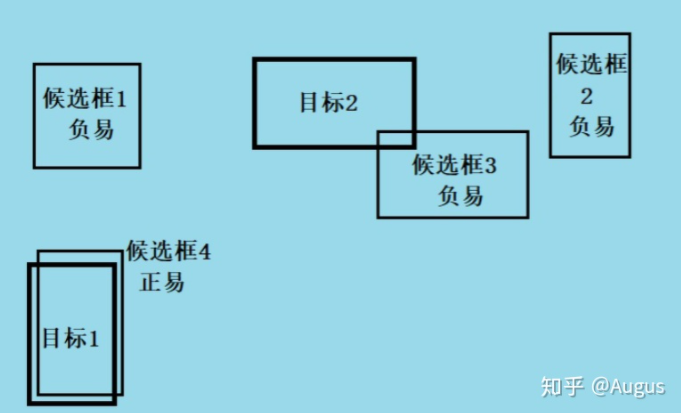

在one-stage检测算法中,会出现正负样本数量不平衡以及难易样本数量不平衡的情况,为了解决则以问题提出了focal loss。hit的检测框就是正样本。容易的正样本是指置信度高且hit的检测框,困难的负样本就是置信度低但hit的检测框,容易的负样本是指未hit且置信度低的检测框,困难的负样本指未hit但置信度高的检测框。目的是解决样本数量不平衡的情况 - 正样本loss增加,负样本loss减小 - 难样本loss增加,简单样本loss减小IOU loss

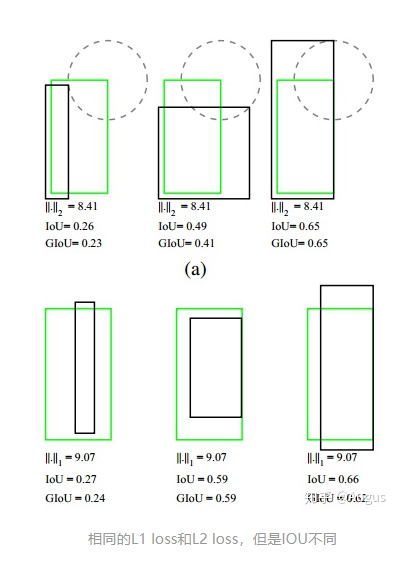

arxiv2016: UnitBox: An Advanced Object Detection Network通过4个点回归坐标框的方式是假设4个坐标点是相互独立的,没有考虑其相关性,实际4个坐标点具有一定的相关性可能存在相同的l1 或 l2 loss(如下图),但是IOU不唯一。尺度不变性,也就是对尺度不敏感(scale invariant), 在regression任务中,判断predict box和gt的距离最直接的指标就是IoU。(满足非负性;同一性;对称性;三角不等性)GIOU Loss

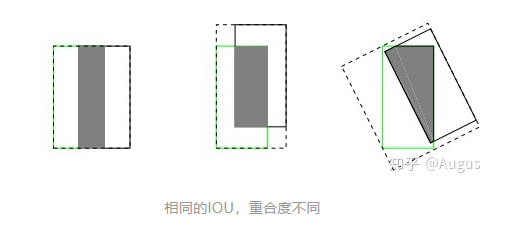

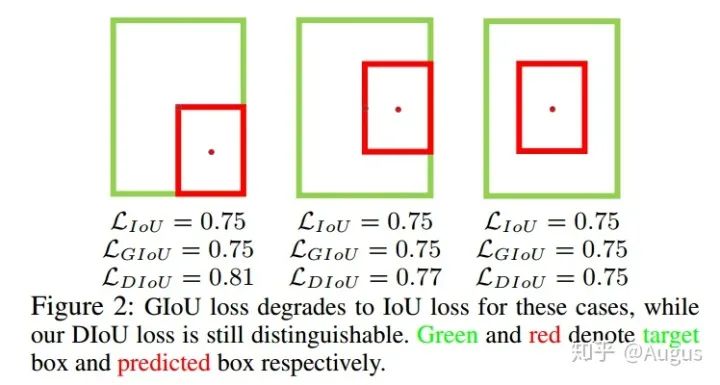

论文链接:https://arxiv.org/abs/1902.09630github链接:https://github.com/generalized-iou/g-darknet如果两个框没有相交,根据定义,IoU=0,不能反映两者的距离大小(重合度)。同时因为loss=0,没有梯度回传,无法进行学习训练。IoU无法精确的反映两者的重合度大小。如下图所示,三种情况IoU都相等,但看得出来他们的重合度是不一样的,左边的图回归的效果最好,右边的最差。DIOU Loss

- 论文链接:https://arxiv.org/abs/1911.08287

- github链接:https://github.com/Zzh-tju/DIoU-darknet

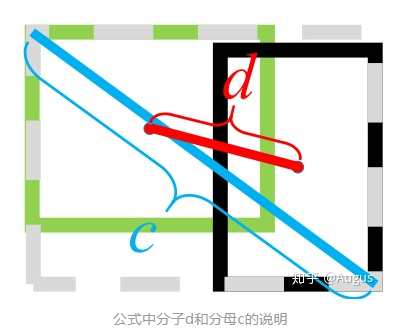

当目标框完全包裹预测框的时候,IoU和GIoU的值都一样,此时GIoU退化为IoU, 无法区分其相对位置关系,如下图三种情况GIOU loss是完全一致的。其中 表示欧式距离,分子d表示GT框和Inference框中心点距离的平方,分母c表示GT框和Inference框最小外接矩形的对角线距离。相比于GIOU,优化距离替换优化面积,收敛速度更快。解决GIOU的缺点:完全包裹预测框时loss一样的情况。CIOU Loss

论文链接:https://arxiv.org/abs/1911.08287github链接:https://github.com/Zzh-tju/DIoU-darknetDIOU没有考虑到检测框的长宽比。长宽比更接近的边框应当有更低的loss。参数 是个trade off的参数,参数 用来衡量长宽比一致性。目标检测回归损失函数简介:SmoothL1/IoU/GIoU/DIoU/CIoU Loss5分钟理解Focal Loss与GHM——解决样本不平衡利器

往期精彩:

【原创首发】机器学习公式推导与代码实现30讲.pdf

【原创首发】深度学习语义分割理论与实战指南.pdf

喜欢您就点个在看!