老板:再用Log4j就收拾东西回家吧!

Hollis

共 1777字,需浏览 4分钟

· 2020-08-19

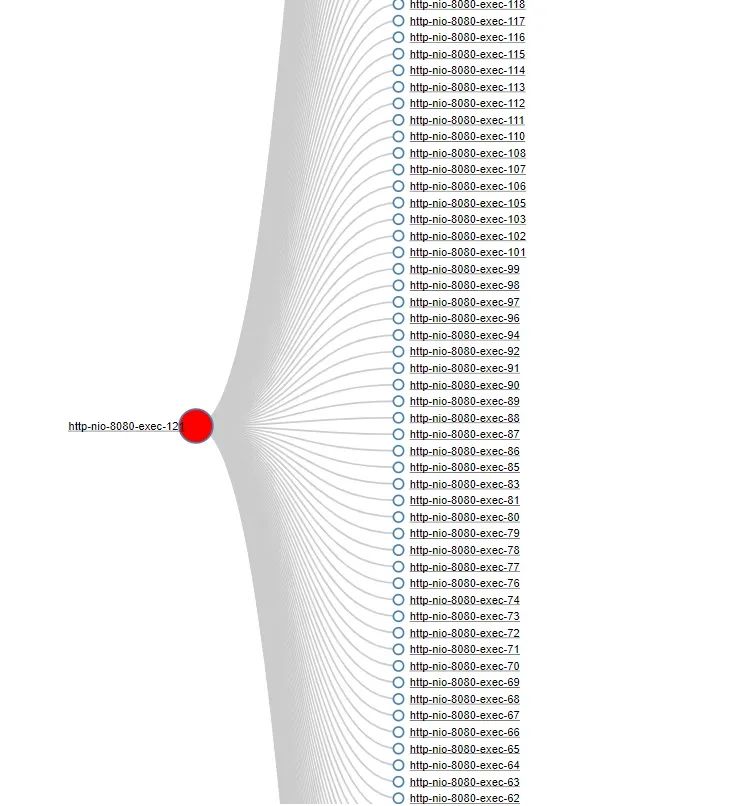

之前一段时间,为我们发现的一个SaaS应用程序会间歇性地卡顿、变慢,因为很长时间都没有定位到原因,所以解决的办法就只能是重启。

这个现象和之前我们遇到的程序变得卡顿不太一样,因为我们发现这个应用程序不仅在高流量期间时会变慢,有时在低流量时期也会变慢。所以这令大家都很奇怪。

这类应用程序的变慢,重新启动之后就可以维持一段时间,但是过段时间又有可能会再次出现。

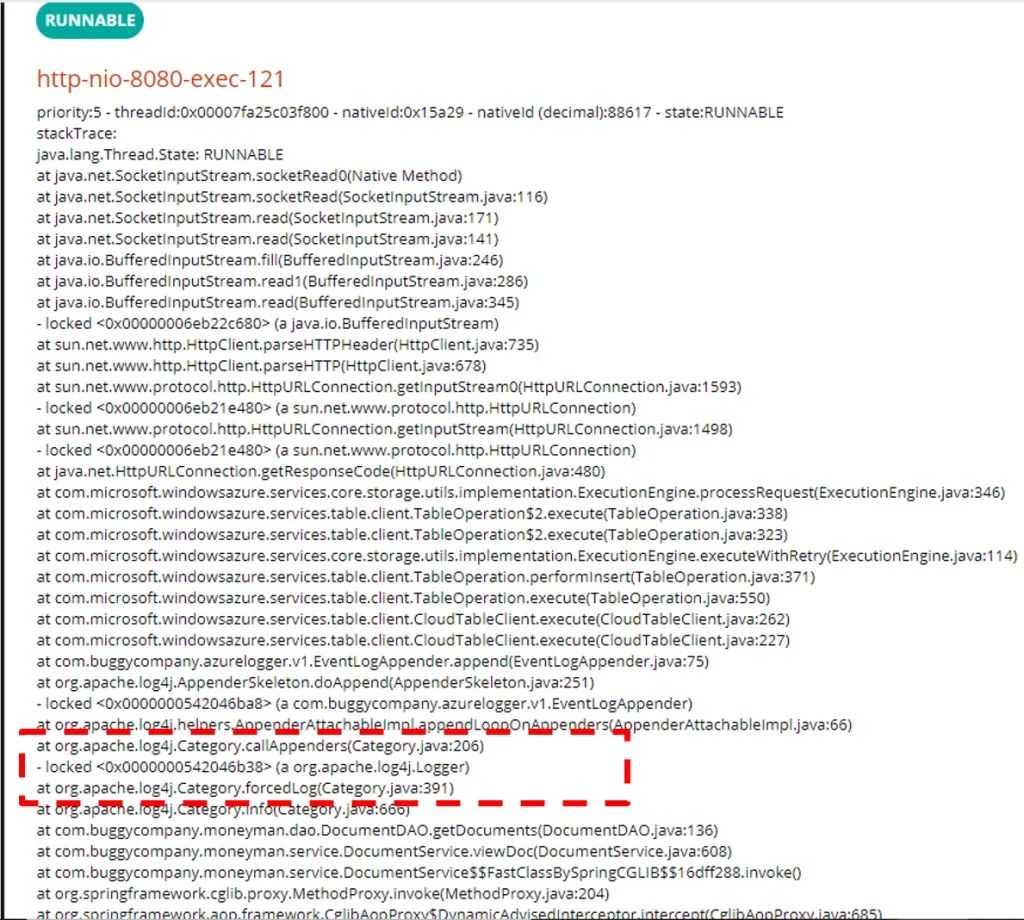

在问题发生时获得线程Dump是非常关键的!

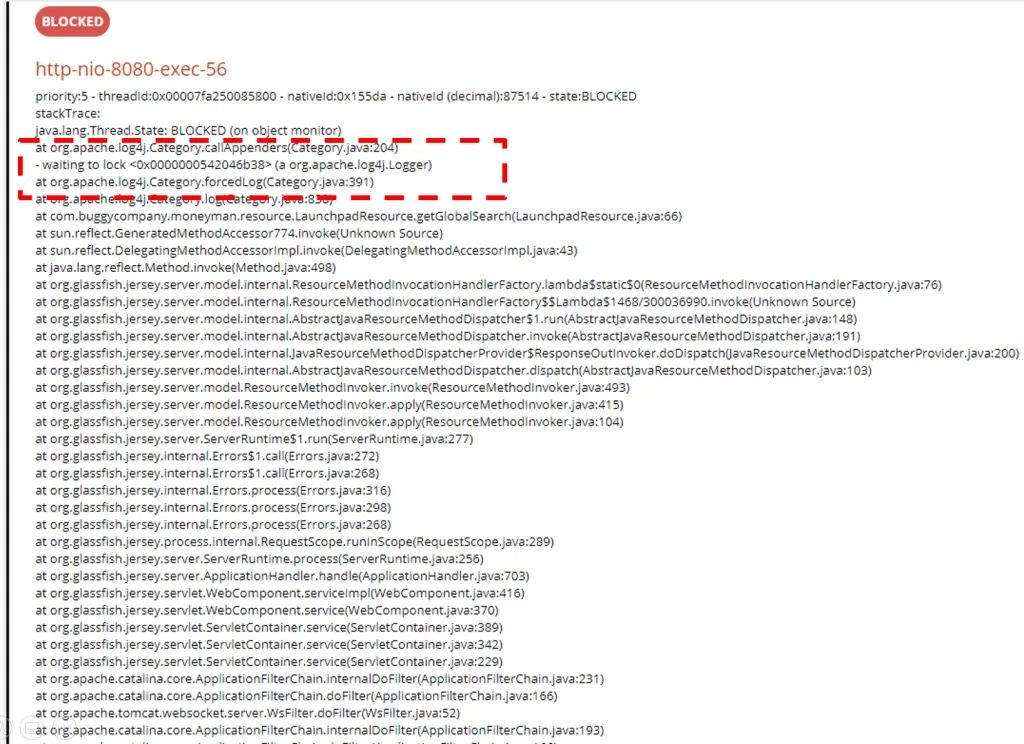

org.apache.log4j.Logger的锁,正在进行其他的操作。

org.apache.log4j.Logger的锁。org.apache.log4j.Logger的锁。因此,每当任何应用程序线程试图记录日志时,它都会因为无法获取到锁而进入阻塞状态。

往期推荐

京东热 key 探测框架新版发布,单机 QPS 可达 35 万

Docker真的被禁止使用了?

《Java开发手册》解读:大整数传输为何禁用Long类型?

直面Java第329期:哪个命令可以监控虚拟机各种运行状态信息?

深入并发第013期:拓展synchronized——锁优化

如果你喜欢本文,

请长按二维码,关注 Hollis.

转发至朋友圈,是对我最大的支持。

评论

盱眙城区一辆解放牌五小车辆对外转让,有需要的老板跟车主联系。

解放牌五小车辆原厂自卸车,年审及保险最新。无任何事故及违章,正常干活车辆,无毛病,手续齐全,车况良好,价格不高,需要的欢迎看车购买。买好车加满油让你开回家。车辆地址:盱眙天鹅湖附近。车主电话:13770461668潘先生

盱眙老妹

0

47岁了,要失业了。工作二十多年,存款大几百万,两套房,目前为是否找工作纠结,还是不甘心,觉得还没老就没用了

上一篇:得知下属工资比我高5K,我气得直接提了离职,HR却疑惑问我为什么,能留下再加5k,有机会升职管整个部门47岁了,面临失业的现实,但若能在私营企业工作至这一年龄,已经算是达到了职业生涯的一个高峰。面对这样的情况,是否应该感到沮丧?其实不必,考虑到个人的资产状况——拥有两套房产和数百万的存款,加

开发者全社区

10

老板创业一半跑去考公,员工心态直接崩了~~

将Python客栈设为“星标⭐”第一时间收到最新资讯今日在网上冲浪的时候,看到这样一条帖子称,朋友开了一家小工作室有两三个员工,工资福利也还不错。最近被员工发现,朋友竟然跑去考公了!员工心态崩了,半夜给他打电话哭诉。真是有点太玄幻,开眼了!帖子下的网友调侃说:“先帝创业未半而老板跑去考公”“这搁古代

Python客栈

0

L4 自动驾驶是骗局?华为徐直军:我们起点就瞄准L4

图源:“华为智能汽车解决方案”公众号撰文 | 程子筠编辑 | 神璐璐审核 | 刘玉琳封面 | “华为智能汽车解决方案”公众号泰伯网讯,在第21届华为分析师大会上,华为副董事长、轮值董事长徐直军在演讲中提到:“华为智能驾驶的起点就是瞄准L4的架构和L4的目标,其次向下适配不同车型的

泰伯网

9

雷军回应被称爽文第一男主;Meta推出开源大模型Llama 3;特步就北京半程马拉松赛发布致歉声明

雷军:没模仿马斯克、乔布斯,卡里也没有冰冷的40亿,SU7正式版本开始交付4月18日,小米集团CEO雷军开播,与网友畅谈SU7开售这20天并带领大家参观小米交付中心。在直播中雷军称:”很多人都催我们快一点交付啊,雷总你能不能去工厂打螺丝啊。今天我们这个工厂是现代化工厂啊,主要的工艺都是全自动化生产的

亿欧网

0

支付系统就该这么设计,稳的一批!!

支付永远是一个公司的核心领域,因为这是一个有交易属性公司的命脉。那么,支付系统到底长什么样,又是怎么运行交互的呢?抛开带有支付牌照的金融公司的支付架构,下述链路和系统组成基本上符合绝大多数支付场景。其实整体可以看成是交易核心+支付核心 两个大系统。交易系统关联了业务场景和底层支付,而支付系统完成了调

程序员闪充宝

804

SpringBoot 实现动态插拔的 AOP,就变得有趣多了

大家好,我是小富~现在有这么一个需求:就是我们日志的开与关是交给使用人员来控制的,而不是由我们开发人员固定写死的。大家都知道可以用aop来实现日志管理,但是如何动态的来实现日志管理呢?aop源码中的实现逻辑中有这么一个步骤,就是会依次扫描Advice的实现类,然后执行。我们要做的就是自定义一个adv

程序员内点事

1277

从字节平薪跳槽?网友:你就偷着乐吧

👇SpringBoot+Vue完整源码免费分享👇(源码+搭建教程+可商用)1、医院管理系统源码2、酒店管理系统源码3、仓库管理系统源码👆源码会持续更新,加油哦!👆最近,我在网上冲浪时,眼睛一亮,看到一个有意思的帖子:“平薪跳槽,这操作6啊!”看到这个帖子,我就来劲了。事情是这样的,发帖的网友在字节跳

码农编程进阶笔记

98