谷歌最新T5模型17项NLP任务霸榜SuperGLUE,110亿参数量!

新智元

共 2418字,需浏览 5分钟

· 2019-10-27

AI WORLD 2019 世界人工智能峰会精彩重放!

10 月 18 日,2019 中关村论坛平行论坛 ——AI WORLD 2019 世界人工智能峰会在北京启幕。新智元杨静、科大讯飞胡郁、微软王永东、华为王成录、英特尔宋继强、旷视及智源学者孙剑、滴滴叶杰平、AWS 张峥、依图颜水成、地平线黄畅、autowise.ai 黄超等重磅嘉宾中关村论剑,重启充满创新活力的 AI 未来。峰会现场,新智元揭晓 AI Era 创新大奖,并重磅发布 AI 开放创新平台和献礼新书《智周万物:人工智能改变中国》。回放链接:

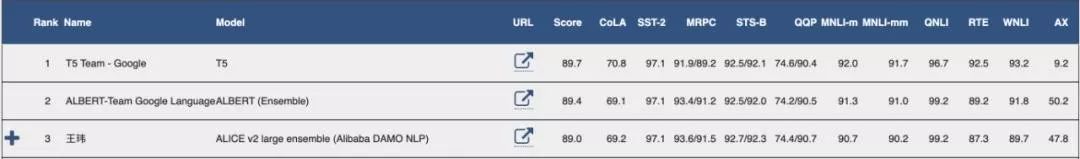

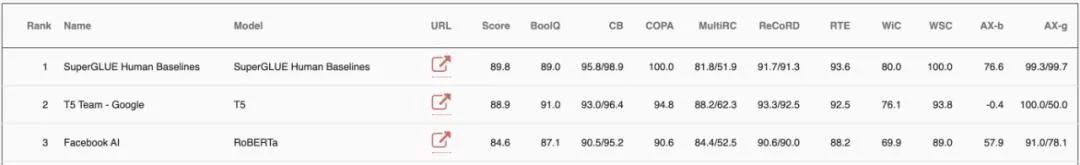

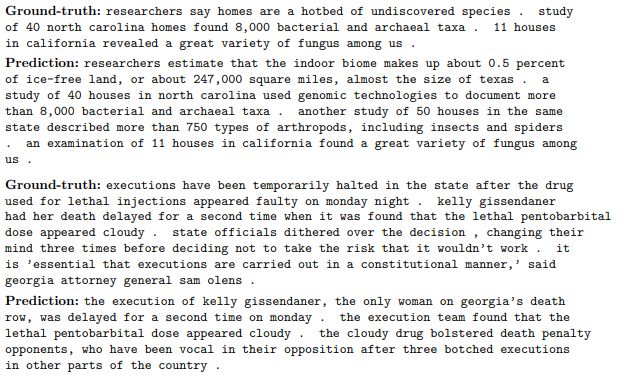

【新智元导读】谷歌提出了一个新的预训练模型:T5。该模型涵盖了问题解答,文本分类等方面,参数量达到了110亿!一举超越ALBERT,刷新Glue榜单,成为全新的NLP SOTA预训练模型。在SuperGlue上,T5也超越了Facebook提出的的RoBERTa,以89.8的得分成为仅次于人类基准的SOTA模型!欢迎来新智元 AI 朋友圈与大咖一起讨论~

论文链接:https://arxiv.org/abs/1910.10683 Github

GitHub链接:https://github.com/google-research/text-to-text-transfer-transformer

评论

日本影山优佳最新杂志照,展现充满透明感的美丽

今天的图文分享的是影山优佳的杂志写真。元日向坂46的影山优佳,登上了写真杂志《周刊FLASH》5/7和5/14合并号的封面。影山优佳是日本艺人、女演员、前偶像。身高155厘米。2001年5月8日出生于东京都。2023年7月从组合日向坂46毕业,之后作为演员活跃的影山优佳,在《周刊FLAS

python教程

0

Langchain使用 | 模型、提示和解析器、存储

零、LangChain介绍为各种不同基础模型提供统一接口- 帮助管理提示的框架- 一套中心化接口,用于处理长期记忆(参见Memory)、外部数据(参见Indexes)、其他 LLM(参见Chains)以及 LLM 无法处理的任务的其他代理(例如,计算或搜索)。总的来说,有六大核心模块:Models:

Python之王

0

【第127期】推荐常用的国内外AI大模型

概述 多个国内外的AI大模型及其特点。以下是一些被提及的AI大模型和平台:全球大模型:ChatGPT:由OpenAI开发,支持多种语言,包括中文。Claude:由Anthropic开发,擅长深层次语言模式和复杂推理。Gemini:由Google Research开发,擅长自然语言理解和生成。Mis

前端微服务

0

为啥大模型还没完全取代你?

点击下方“JavaEdge”,选择“设为星标”第一时间关注技术干货!免责声明~任何文章不要过度深思!万事万物都经不起审视,因为世上没有同样的成长环境,也没有同样的认知水平,更「没有适用于所有人的解决方案」;不要急着评判文章列出的观点,只需代入其中,适度审视一番自己即可,能「跳脱出来从外人的角度看看现

JavaEdge

0

又一国产灭霸,要来了

据透露,vivo X100 Ultra确定会在今年5月份发布,这款机型基本可以锁定“vivo X系列有史以来最强的影像旗舰”。vivo推出自研影像品牌BlueImage,也意味着继华为XMAGE后,手机行业第二个独立影像品牌的诞生。vivo X100 Ultra后置三摄,将会搭载一枚2亿像素潜望式超

放毒

2

一文读懂大模型发展过程!

点击下方“JavaEdge”,选择“设为星标”第一时间关注技术干货!免责声明~任何文章不要过度深思!万事万物都经不起审视,因为世上没有同样的成长环境,也没有同样的认知水平,更「没有适用于所有人的解决方案」;不要急着评判文章列出的观点,只需代入其中,适度审视一番自己即可,能「跳脱出来从外人的角度看看现

JavaEdge

0

人人都能在本地电脑上部署LLama3大模型

电脑配置要求:推荐16GB内存以上,最低8GB。最近几年主流CPU均可。英伟达显卡性能表现会更好,但不是必须。部署流程:1、下载安装Ollama大模型运行框架2、下载运行LLama3大模型3、下载安装服务器容器Docker Desktop4、下载运行OpenWebUI应用服务搞定!视频演示

Python涨薪研究所

0

4款最新可用的老牌 KMS 工具,亲测完美激活!

对于没有激活的Windows、Office系列产品的电脑,确实有点难用!例如没有激活的Windows电脑,大大的图标水印提示需要激活!例如没有激活的Office产品,根本没有办法编辑。为了解决激活Windows、激活office、还有Windows家庭版升级专业版。这里给大家推荐4款亲测有效的KMS

dotNET全栈开发

229