ICLR2020 最新提交论文,这五篇Open代码的 GNN 论文值得读

新智元

共 3274字,需浏览 7分钟

· 2019-10-14

【新智元导读】最近,人工智能和机器学习领域的国际顶级会议ICLR 2020刚刚截止submission不久,大会共收到近2600篇投稿,相比ICLR 2019的1580篇论文投稿,今年增幅约为62.5%,竞争尤其激烈。现在进入online open review阶段,图神经网络(GNN)相关的论文依然很火爆,为此,小编提前为大家筛选了五篇Open代码的GNN相关论文供参考和学习!来新智元AI朋友圈与AI大咖一起参与讨论吧~

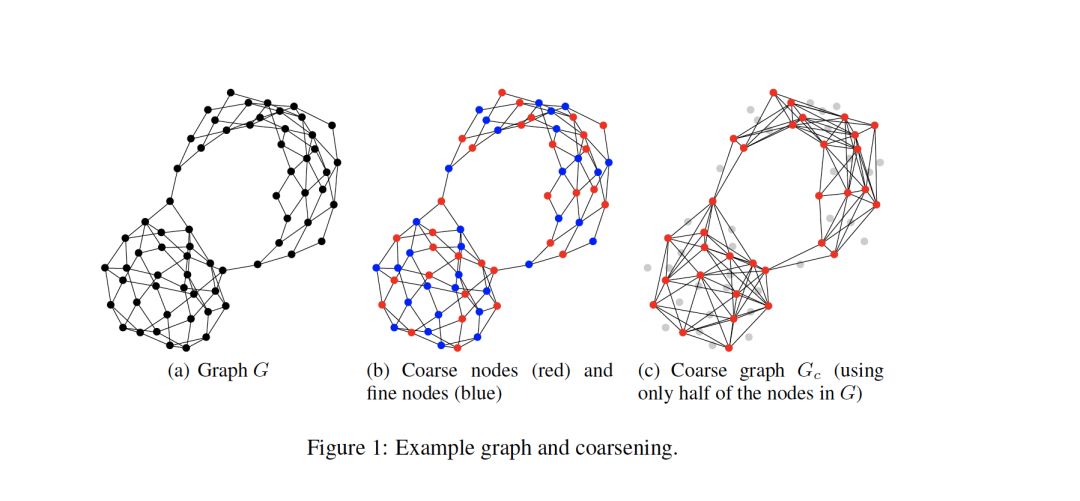

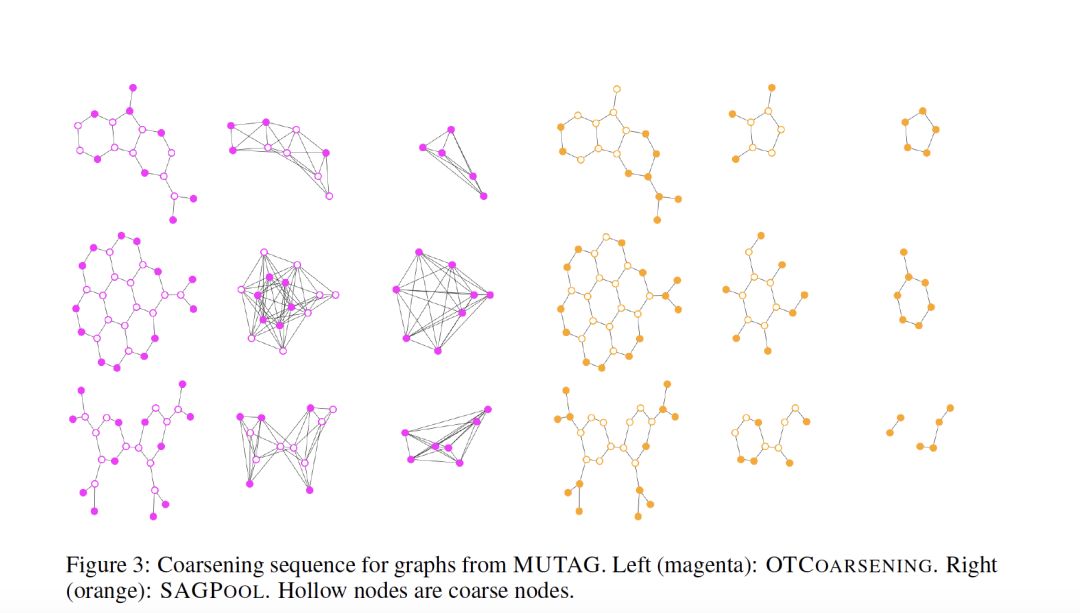

网址:https://openreview.net/forum?id=Bkf4XgrKvS代码:https://github.com/anonymousOPT/OTCoarsening

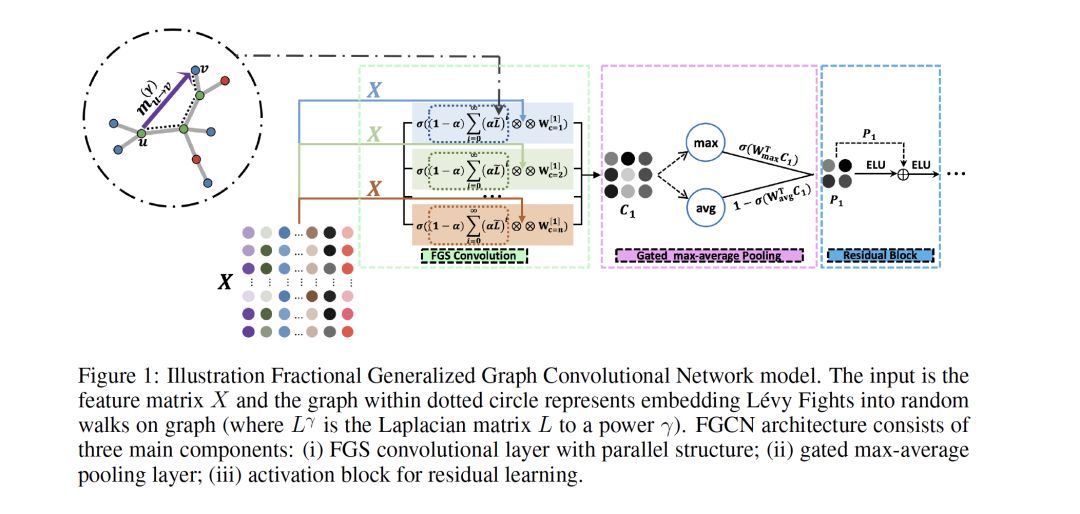

网址:https://openreview.net/forum?id=Bkf4XgrKvS代码:https://github.com/anonymousOPT/OTCoarsening摘要:由于在许多应用程序(从社交网络到区块链到电网)中的高实用性,对非欧几里德对象(如图和流形)的深入学习继续获得越来越多的兴趣。目前大多数可用的技术都是基于这样的思想,即在spectral域中使用适当选择的非线性可训练滤波器进行卷积运算,然后使用有限阶多项式逼近滤波器。然而,这种多项式逼近方法往往对图结构的变化不具有鲁棒性,而且主要用于捕获全局图拓扑。在本文中,我们提出一种新的Fractional Generalized Graph Convolutional Networks (FGCN)方法,该方法将L'evy Fights投射到图上的随机游走中,因此,可以更准确地解释内在图拓扑和大幅度提高分类性能,尤其是对异构图形。

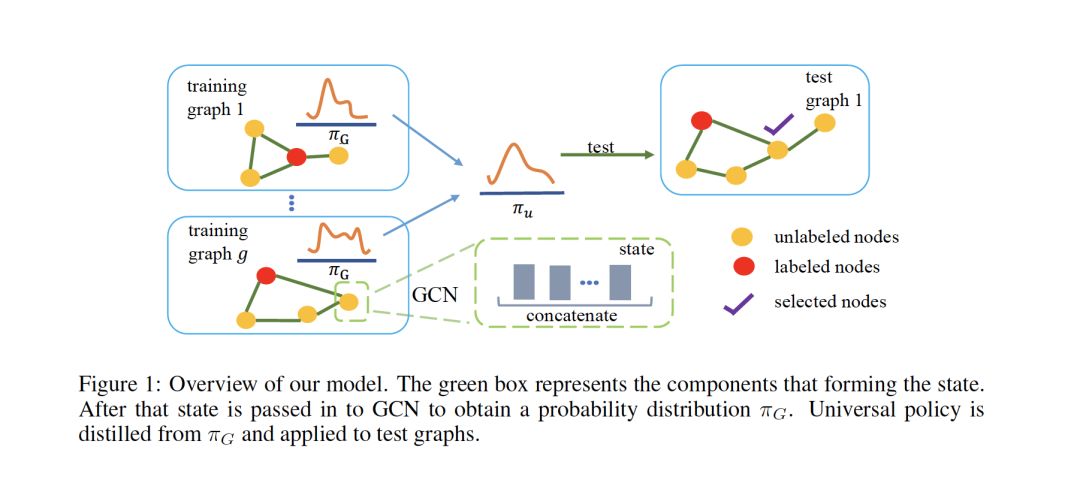

网址:https://openreview.net/forum?id=BygacxrFwS代码:https://github.com/yuzhouchen92/

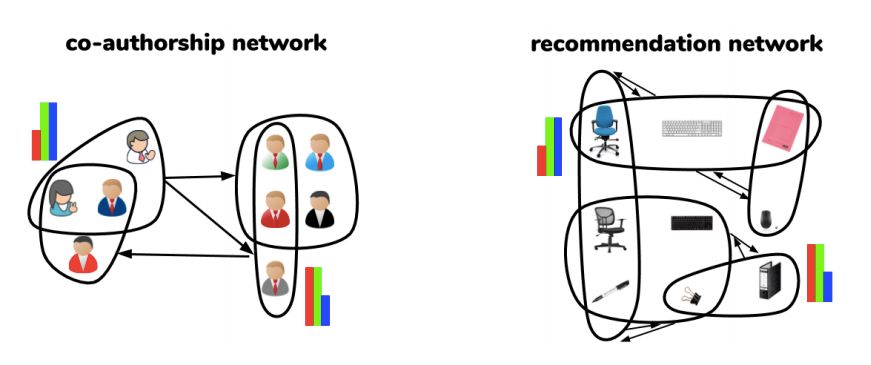

网址:https://openreview.net/forum?id=BygacxrFwS代码:https://github.com/yuzhouchen92/ 网址:https://openreview.net/forum?id=BklOXeBFDS代码:https://drive.google.com/drive/folders/1GFGR2WFEuG49MQN-nX4pkZj9Y_E7vPP5

网址:https://openreview.net/forum?id=BklOXeBFDS代码:https://drive.google.com/drive/folders/1GFGR2WFEuG49MQN-nX4pkZj9Y_E7vPP5

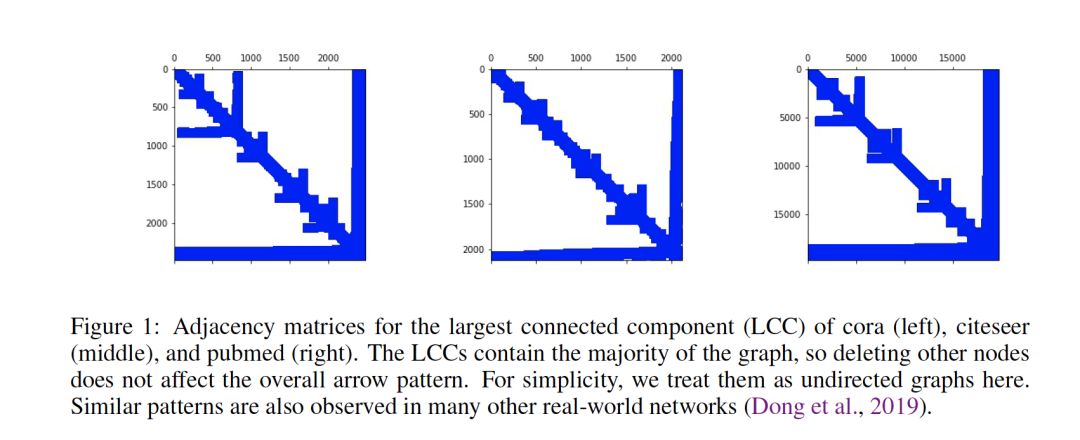

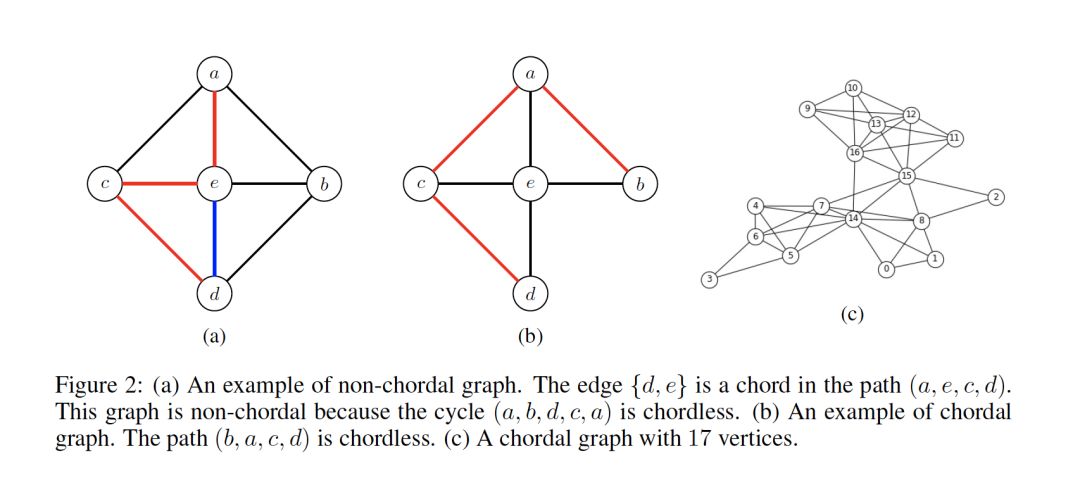

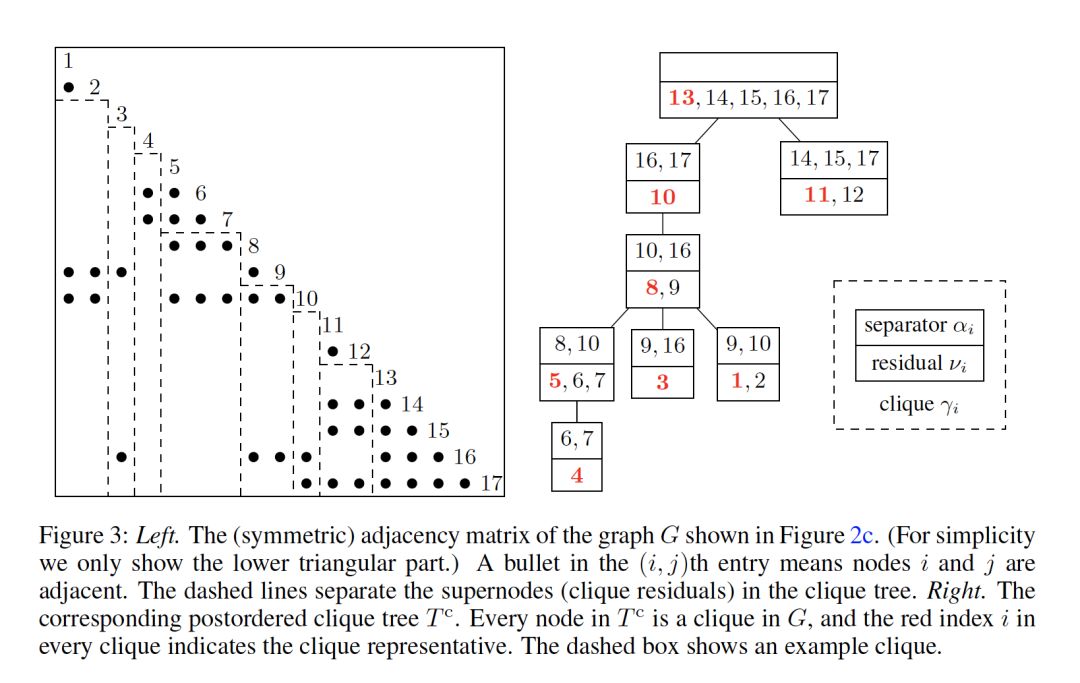

网址:https://openreview.net/forum?id=rJl05AVtwB代码:

网址:https://openreview.net/forum?id=rJl05AVtwB代码:https://www.dropbox.com/s/0vby5gbu9qkbigr/chordal-gcn.zip?dl=0

网址:https://openreview.net/forum?id=ryestJBKPB代码:

网址:https://openreview.net/forum?id=ryestJBKPB代码:https://drive.google.com/file/d/1i7l5jPBPZ3TRG7YkG6NvJ10j19dnAfOf/view?usp=sharing

评论